Каждый день я пользуюсь веб-сканерами. Они очень полезны, несмотря на то, что просто имитируют действия поисковых роботов. Значит, вы не всегда получаете точную картину.

Единственный инструмент, который даст вам реальные данные — логи. Учитывая, что многие оптимизаторы буквально помешаны на бюджете сканирования — количестве страниц, которые за один проход может прокраулить бот, — нам такая информация нужна. Анализ логов поможет обнаружить такие адреса, о существовании которых вы даже не подозревали, хотя роботы их обходят.

Это большая трата ресурсов Google, о чем компания нам сообщает: "Трата ресурсов на такие страницы приводит к потере активности при сканировании важных страниц. Это приводит к задержке индексации нового и ценного контента на сайте".

Факт в том, что большинству сайтов нужно беспокоиться о бюджете сканирования. Об этом несколько раз говорил и Джон Мюллер.

Когда вы знаете, что говорят логи, вы получите ценную информацию о том, как Google сканирует и просматривает ваш сайт. А значит, у вас есть все данные, чтобы оптимизировать ресурс и увеличить трафик. Чем больше ресурс, тем сильнее это влияет на решение проблем с поисковым продвижением.

Что такое логи сервера

Файл с логами — это запись всего, что происходит на сервере: какую информацию он получает и отправляет. Можно представить, что это книга запросов, которые делают пользователи и поисковые роботы.

Кроме этого, вы увидите, какие ошибки на сайте требуют вашего внимания. Например, так мы узнали, что из-за ошибки в нашей CMS каждый URL дублировал сам себя. Google обходит оба адреса, в результате мы получили дублирование контента. А дубли начали конкурировать друг с другом.

Анализ журналов — не отправка ракеты в космос. Логика как при работе с электронными таблицами. Самое сложное — вытащить логи, экспортировать и отфильтровать данные нужным образом.

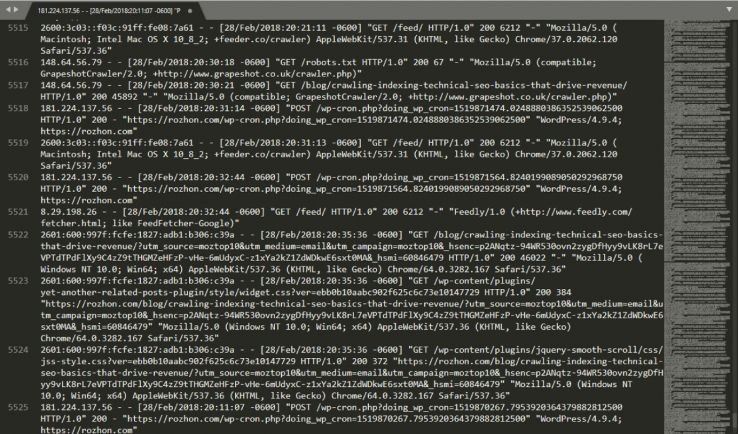

В логе вы увидите примерно следующее:

Присмотритесь к этой строке: 66.249.65.107 - - [08/Dec/2017:04:54:20 -0400] "GET /contact/ HTTP/1.1" 200 11179 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Понятно, что здесь:

- 66.249.65.107 — IP-адрес (кто).

- [08/Dec/2017:04:54:20 -0400] — время (когда).

- GET — метод (функция, которая выполняется по запросу).

- /contact/ — запрошенный пользователем адрес URL.

- 200 — код ответа сервера (результат).

- 11179 — размер переданной информации в байтах.

- "-" реферер URL. Он пустой, поскольку запрос совершался ботом.

- Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) — подпись пользователя. Здесь она типичная для бота Google.

Полезные инструменты

Есть много способов для анализа логов. Полный список давать я не буду, а расскажу о разнице между статичными сервисами и теми, которые работают в режиме реального времени.

Статичные — анализируют текущий файл. Вы получаете информацию, которая в нем находится на момент анализа. Чтобы обновить данные, придется заливать новый файл. Я пользуюсь для этого Power BI.

Инструменты реального времени — собирают всю информацию и в реальном времени показывают ее вам.

Начало анализа

Если вы не знаете, зачем вам логи — лучше ничего не делайте. В противном случае будете долго ковыряться в непонятных данных, потратите время, но ничего нового не узнаете.

Вот примеры вопросов, на которые можно найти ответ в логах:

- какие боты заходят на сайт?

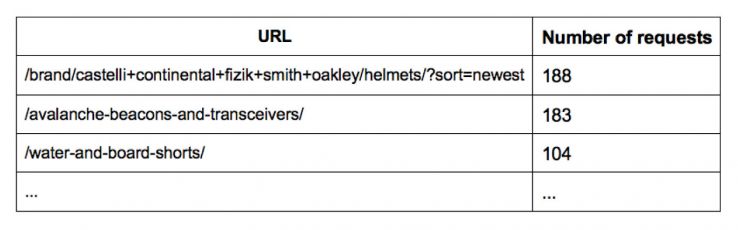

- по каким URL они ходят чаще всего?

- какой тип контента быстрее обходят?

- какие кода ответа возвращаются?

Например, вы видите, что Google сканирует несуществующие страницы (404). Можно узнать, какой из запрошенных адресов возвращает код 404. Выстройте список по количеству запросов, выделите самые частые, чтобы найти страницы с высоким приоритетом. Подумайте, есть ли проблема с адресом, нужно ли что-то предпринимать.

Фильтрация данных

Группировка данных даст вам агрегированную информацию и общее представление. Это облегчит поиск закономерностей и тенденций, которые вы могли упустить, изучая отдельные URL. Вы можете найти проблемные разделы на сайте и изучить их внимательнее.

Несколько вариантов группировки адресов:

- по типу контента (страницы категорий, отдельные страницы товаров);

- по языку (страницы на разных языках для мультиязычной версии сайта);

- по товарам (продукция из Канады или Америки);

- по формату (css, JS, image).

Не забудьте также обязательно выгрузить user-agent. Без этого вы не найдете в логах ничего полезного.

Отслеживание поведения роботов

Со временем ваш сайт меняется. А значит, меняется и поведение поисковых ботов. Googlebot часто меняет скорость сканирования в зависимости от скорости загрузки сайта или страниц, структуры внутренних ссылок, наличии ловушек.

Проверяйте файлы в течение года и при внесении изменений на сайт. Я лично изучаю логи почти каждую неделю.

А если вы решите пару раз в год заглянуть в файлы, вряд ли увидите существенные изменения в поведении роботов.

Следите за подменой

Спам-боты и грабберы часто "подделывают свою личность". Они могут использовать пользовательский user agent, чтобы избежать спам-фильтров.

Чтобы узнать, настоящий ли веб-сканер побывал у вас на сайте, можете воспользоваться поиском DNS. Подробнее — в справочном центре для вебмастеров Google.

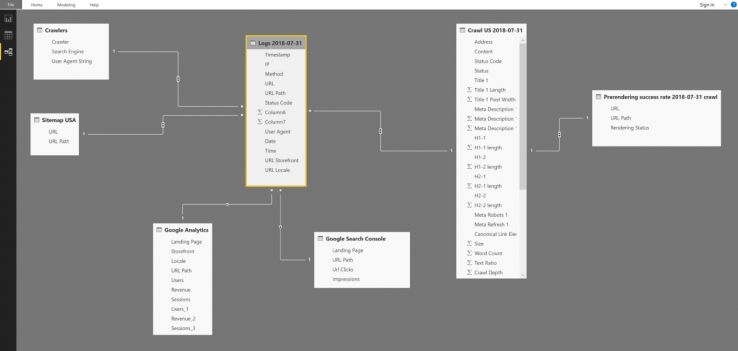

Объединение логов с другими источниками данных

Хотя это и не обязательно, но объединение логов с другими источниками данных даст вам еще больше понимания, что происходит вообще. Если вы используете Power BI, то объединить данные просто. Насколько я знаю, такая функция есть и во многих других инструментах мониторинга логов, например, Tableu.

Можно рассматривать информацию в логах в совокупности с данными из Google Analytics, как ранжируются ключевые слова и т. д. Вот примеры вопросов, на которые вы получите ответ:

- Какие страницы быстро сканируются, но не включены в sitemap.xml?

- Какие страницы включены в карту сайта, но не сканируются?

- Какие страницы обеспечивают прибыль из наиболее часто посещаемых роботом?

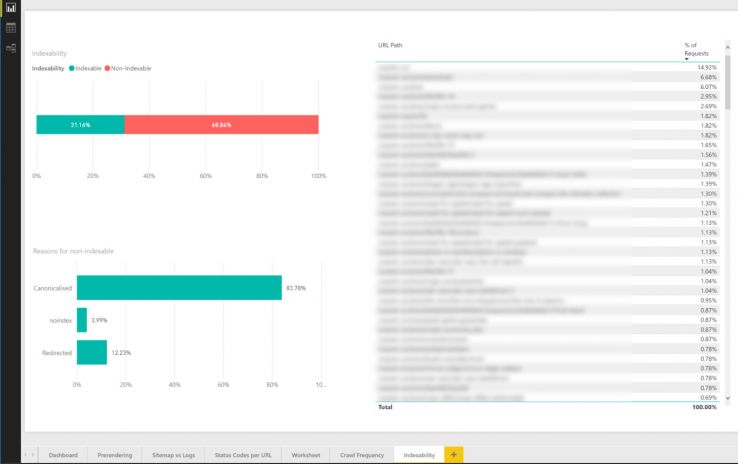

- Индексируется ли большинство просканированных страниц?

Так, например, вы можете узнать, что большинство страниц с основными ключевыми словами просто не индексируются. Естественно, эта информация усовершенствует вашу SEO-стратегию.

Использование логов для отладки Google Analytics

Логи полезны не только для SEO. Вы сможете узнать о серьезных технических ошибках и вовремя их исправить, пока они не стали серьезной проблемой.

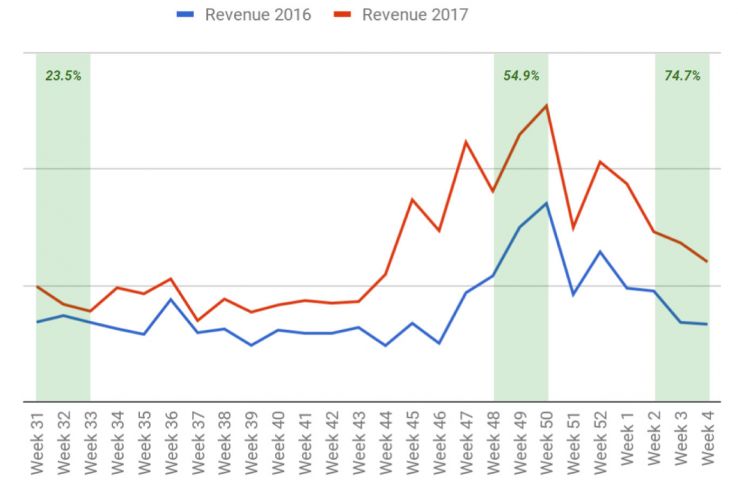

Год назад из GA мы узнали, что у нас снизился органический трафик на сайт, несмотря на то, что другие сервисы веб-аналитики ничего такого не сказали. Что происходит?

Мы обратились к логам. Проанализировали их и поняли, что просадки по трафику не было. Дело в недавно настроенном WAF — брандмауэре, который переопределял реферер, что привлеко к тому, что львиная доля трафика в GA неверно квалифицировалась.

Использование лог-файлов вместе с мониторингом ключевых слов помогло нам раскрыть всю проблему и быстро в ней разобраться.

Заключение

Анализ логов — обязательное условие при работе с большими сайтами.

Мой совет — начать с сегментации данных, затем — регулярно отслеживать ситуацию. Затем можете комбинировать данные из разных источников и получать неплохие инсайты.