Нейронные сети сейчас снова у всех на слуху. Только вначале 2016 года появились десятки различных сервисов, использующих в своей основе «глубинное обучение». Отрасли применения этих сервисов совершенно разные, результаты впечатляющие, будущее из фантастики 60-х уже стучится к нам в дверь.

Особенно ярким событием стала мартовская игра, спроектированного компанией DeepMind (подразделение Alphabet (Google)) алгоритма для популярной восточной игры ГО под названием AlphaGo. Вначале, осенью 2015 года, он с разгромным счетом расправился с трехкратным чемпионом Европы Фань Хуэй, а затем в марте 2016 смог победить профессионального корейского игрока в ГО 9 дана Ли Седоля. Правда, в отличие от Хуэя, Седоль все же смог один раз обыграть созданный интеллект.

Для того чтобы воплотить в жизнь огромный массив вычислений, который требуется для игры, для запуска алгоритма понадобилось 170 видеокарт и 1200 процессоров.

Казалось бы, победа программного обеспечения в игре над человеком не новое явление, подобное было и раньше, как не вспомнить игру Каспарова с IBM DeepBlue в 1997 году в шахматы. Однако, разница между системой игравшей в 90-е и текущими разработками огромна.

В шахматах меньшее количество возможных ходов и система может просчитать большинство вариантов на несколько шагов вперед, к тому же данные об алгоритмах и победных стратегиях, можно сказать, инструкции к действию для победы, в подобные программы добавляет сам человек, система не обучается игре, она лишь использует внесенные в ее «разум» подсказки.

AlphaGo же имеет в своей основе так называемые нейронные сети, основанные на алгоритме «глубинного обучения» (deep learning). Если описывать систему двумя словами — это обучение самостоятельно. Да, система пытается сама догадаться на основе огромного объема данных, какая стратегия для игры будет более действенной, алгоритм пытается обучаться, в том числе и играя партии с самим собой.

Но зачатки подобных систем можно встретить не только в играх, используются они и для распознавания изображений, речи (подобный алгоритм позволил увеличить % распознавания речи на Android-устройствах). Есть и любительские проекты, одни из последних — нейронная сеть, которая раскрашивает черно-белые изображения и программа, имитирующая стиль известных художников для создания новой картины, да, пока что это только удачная компиляция уже созданных произведений, но потенциал — колоссальный.

Что же такое Deep Learning и как он появился?

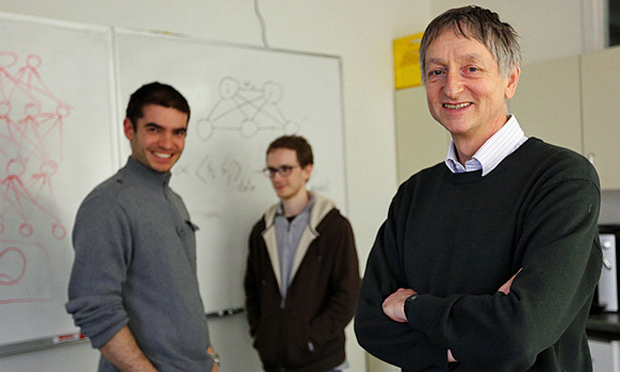

На протяжении последних 30 лет во многих отраслях проводились работы по развитию алгоритмов «глубинного обучения». Один из немногих людей, кого по праву можно назвать крестным отцом deep learning — это профессор Хинтон, в настоящее время работающий в Google и преподающий в Университете Торонто. Начиная с 1980-х годов и на протяжении последующих десятилетий, Хинтон продвигал идею построения нейронных вычислений и адаптивную программу восприятия. Помимо Хинтона, вместе с ним работал над созданием основ deep learning и Эндрю Нг, главный научный сотрудник Baidu.

В начале нулевых сфера «глубинного обучения» переживала спад и активно не развивалась, во многом это было связано с ограниченной мощностью чипов, которые используются для обработки данных и построения нейронных сетей. Однако, оказалось, что идеи Хинтона просто опередили свое время. Но будущее умеет ждать.

Давайте попробуем разобраться, что же из себя представляет «глубинное обучение».

Это вид машинного обучения на основе нейронных сетей. Главной задачей ставится, создание машины, которая будет самостоятельно придумывать результат, без сторонней загрузки алгоритмов действий.

В этом и есть главное отличие «глубинного обучения» от машинного обучения, когда компьютер получает знания благодаря человеку. При таком типе обучения, в машину загружается большой объем учебных примеров, возникшие ошибки исправляются вручную. Выходит, что за машину необходимые абстракции человек и они при этом ограничены его фантазией и возможностями.

Deep learning подразумевает моделирование высокоуровневых абстракций, состоящих из множества нелинейных трансформаций, созданных самой машиной.

Для этого и используются нейронные сети, основанные на принципе «глубинного обучения», когда машина снова и снова анализирует большие объемы информации, создавая при этом новые самостоятельные пути решения проблем в любых отраслях.

А что же в настоящем и будущем?

За последние 8 лет большинство технологических гигантов вкладывают средства в различные проекты связанные с ИИ и нейронными сетями. Обработка огромных массивов данных, анализ и самообучение, быстрый ответ на вопрос во всевозможных областях знаний, вот таким уже сейчас выглядит «будущее».

- Например, компания IBM и их проект IBM Watson. Watson является суперкомпьютером с вопросно-ответной системой искусственного интеллекта. Сам по себе он лишь часть более крупного проекта DeepQA. Основная задача, которая ставилась перед компьютером, это возможность понимать сформулированные на естественном языке вопросы и находить на них ответы в базе данных. Разработкой активно заинтересовались различные медицинские исследовательские центры, которые хотели бы воплотить в жизнь систему, позволяющую диагностировать и лечить пациентов, находя при этом в огромных массивах информации индивидуальные истории болезни и пути лечения.

- Помимо этого, с прошлого года проходит тестирование еще одного направления, в котором задействован IBM Watson, это создание новых кулинарных рецептов, где компьютер из предложенных ингредиентов предлагает пользователю новое блюдо, которое он никогда не пробовал и, возможно, и не попробовал бы. Все из-за уникальной системы подбора составляющих блюда, порою они довольно экзотичны и их выбор понятен только самому компьютеру.

- WolframAlpha — еще одна вопросно-ответная система запущенная в мае 2009 года. Система создавалась для систематизации всего, что поддается систематизации, для быстрого поиска точных ответов на миллионы вопросов. Вольфрам хоть внешне и похожа на обычную поисковую систему, позволяет ответить на вопросы, заданные естественным языком, включая довольно специфические, например: Сколько запятых в трагедии «Гамлет» Шекспира. Помимо этого, система позволяет делать математические, физические вычисления, визуализацию химических формул и многое другое.

- Исследования проводит и Facebook (благодаря специальному подразделению Facebook AI Research (FAIR)). Один из главных продуктов по «глубинному обучению» от социальной сети — открытое программное обеспечение Torch. Которое частично в своих разработках используют DeepMind, FAIR, IBM, Yandex и Idiap Research Institute. На основе этого ПО была создана система по распознаванию лиц.

- Своя система по распознаванию лиц есть и у компании Microsoft, благодаря их подразделению Microsoft Project Oxford. Помимо этого, была проведена интеграция Оксфорда и Cortana (личный голосовой помощник от Microsoft) в Windows 10.

- В 2011 году компанией Google был запущен проект под названием Google Brain, который на основе анализа видеороликов на Youtube, в которых фигурировали кошки, смог составить общий «фоторобот» для распознавания этих животных.

Причем никаких данных о внешнем виде кошек в систему не вносилось, все было сделано интуитивно с помощью самообучения (кстати, этот проект тоже детище Хинтона).

Давайте перенесемся в 2012 год, когда для машинного обучения произошел настоящий бум. Примерно с этого времени Google начинает активно скупать различные компании и стартапы, связанные deep learning направлением. Самой крупной сделкой в этой отрасли стала покупка в 2014 году британской DeepMind, которую мы уже упоминали ранее.

В 2015 году компаний, связанных с «глубинным обучением» стало еще больше. Например, Clarifai с их разработками в сфере маркетинга: была разработана система для лучшего определения целей зрителей, которые потом применяются для рекламы, модерации и фильтрации данных.

В феврале 2016 года был запущен российский сервис FindFace. Как заявляют разработчики, в основе используется фотобаза социальной сети Вконтакте, по которой нейронная сеть ищет человека, ориентируясь на 80 ключевых параметров. Стоит только загрузить фотографию, сделанную, например, на улице и система проанализирует, есть ли в базе такой человек, затем покажет его личную страницу в социальной сети.

5 апреля 2016 года компания Nvidia на конференции GPU Technology Conference презентовала революционную архитектору Pascal. Представленный чип имеет 15 миллиардов транзисторов на одном кристалле, таких результатов ранее никто не достигал. Характеристики просто впечатляют. В первую очередь на новой архитектуре будут построены игровые видеокарты, ориентированные на быстро развивающиеся технологии виртуальной реальности. Также был представлен модуль Tesla P100, построенный на базе Pascal.

Но самое важное, Nvidia показала свой компьютер DGX-1, который позиционируется как первый суперкомпьютер для «глубинного изучения» в сборе. Он построен на восьми модулях P100 с общей производительностью в 170 терафлопс. Стоит заметить, что компьютер предыдущего поколения удалось обойти по техническим характеристикам в 12 раз. Поэтому DGX-1 позволяет тренировать нейронные сети в 12 раз быстрее, если раньше системе требовалось 150 часов на обучение, теперь уходит всего 2 часа.

Что это значит для SEO?

В марте 2015 года Google опубликовал статью про доверие и оценку надежности интернет-ресурса. Главная идея — ссылочному продвижению уже в ближайшее время придется остаться в прошлом, количество ссылок на сайт будет неважным. Новый подход основывается на корректности фактической информации, размещенной на сайте.

Сами факты автоматически парсятся с каждого ресурса при помощи методов извлечения информации, подобных тем, что используются для создания баз знаний.

Чтобы различать ошибки, сделанные в процессе выгрузки данных, от фактических ошибок, используется метод комбинированного логического вывода, основанный на новейшей многослойной вероятностной модели.

Полученная оценка достоверности была названа «доверием, основанным на знаниях» (Knowledge-Based Trust (KBT)). После моделирования данных удалось доказать, что метод надежно определяет истинную достоверность ресурсов. Для этого был проведен тест на базе данных с 2,8 миллиардами фактов, извлеченных из сети. Таким образом удалось оценить достоверность 119 миллионов веб-страниц. Оценка групп результатов, которая была проведена без автоматизации, подтвердила эффективность метода.

Однако, даже используя новый метод, поисковая система не сможет работать корректно без понимания смысла информации, размещенной на странице.

Именно понимание написанного (а не просто анализ по ключевым словам) сделает поиск совершенно другим. Здесь и выходят на первое место нейронные сети с их самообучением.

Для каждого типа сайтов, для каждой тематики, нейронная сеть подберет свои уникальные сигналы и особенности, по которым можно будет определить, вызывает ли ресурс доверие, верные ли данные размещены, всё ли соответствует тематике.

Мы наконец-то перешли рубеж, когда в поисковик будет интегрирован искусственный интеллект.

Можно выделить несколько основных прогнозов для поисковой выдачи:

- Поиск имени меня. Полная персонализация поисковой выдачи под конкретного человека. От поиска будет требоваться умение предугадывать действия и запросы пользователя на несколько шагов вперед.

- Смерть спамных и неинформативных сайтов. Google уже долгое время борется со спам-сайтами, для отслеживания таких проектов ранее уже вводился алгоритм Пингвин. Поиск на основе deep learning сможет распознавать неестественность информации на сайте.

- Улучшенная интеграция между различными устройствами. Первой ласточкой можно назвать алгоритм Mobilegeddon от Google, запущенный весной 2015 года. Который давал преимущество при ранжировании для сайтов, оптимизированных под мобильные девайсы. А с момента выхода в открытую продажу систем виртуальной реальности от Facebook (Oculus) и Microsoft (Hololens), от поисковой выдачи будет требоваться, чтобы она умела подстраиваться под конкретное устройство, которое использует пользователь в данный момент, соответственно и выдача будет отличаться.

- Никому не скрыться. Уже сейчас есть новые типы браузерных кук — super cookie, которые сложно обнаружить и удалить с компьютера, при этом они перманентно привязываются к устройству. Такие технологии уже используют Facebook, Verizon, AT&T.

- Визуальное содержание прежде всего. Даже сейчас, большинство информации размещенной на Facebook — это фотографии. Исследования подтверждают, что привлекательные визуальные эффекты и графика лучше сказываются на продвижении продукции. Нейронные сети смогут подстраивать выдачу на основе личностных предпочтений пользователя. Любимый цвет или стиль, всё будет учтено.

В ближайшие пять лет нас захлестнет новая технологическая волна, которая возможно перевернет многое в IT отрасли сверху вниз развернув приоритеты поисковой оптимизации на 360 градусов. Осталось совсем немного, будущее уже не завтра, оно уже сегодня.