В этом большом руководстве вы узнаете все про:

- сканирование сайта и его индексирование;

- карты сайтов XML;

- дублирующийся контент;

- структурирование данных;

- атрибут hreflang.

Контент, линкбилдинг, сбор семантики очень важны. Но фундамент продвижения сайта — техническая оптимизация. Об этом и поговорим.

1. Основы технического SEO

Техническая оптимизация — это набор рекомендаций. Они нужны, чтобы сайт соответствовал требованиям поисковых систем. Как мы помним, каждый поисковик стремится предоставлять по запросу пользователя лучший релевантный ответ.

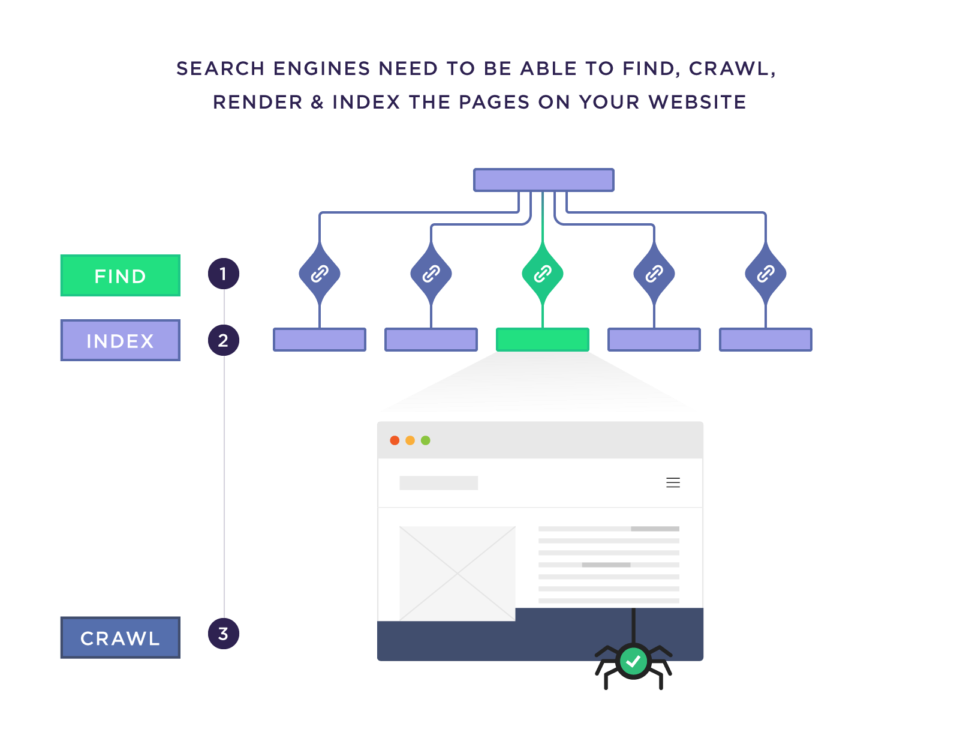

У вас может быть лучший контент в нише. Но если с технической точки зрения сайт испорчен, то он не будет ранжироваться в поисковиках. На базовом уровне системы должны иметь возможность находить, сканировать, отображать и индексировать страницы вашего ресурса.

Даже если эти простые действия осуществимы, это вершина айсберга. Кроме этого — для полной технической оптимизации — страницы:

- должны быть безопасны;

- адаптированы для мобильных устройств;

- не содержать дублирующуюся информацию;

- должны быстро загружаться.

Планирование структуры сайта — номер 1 по важности технических работ. Проблемы с индексацией возникают из-за плохо спроектированной архитектуры ресурсы. Но если выполнить все как надо, не придется беспокоиться о том, как система обойдет сайт.

Кроме этого, структура сайта влияет на все остальное, что вы делаете для оптимизации — от URL-адресов до robots.txt.

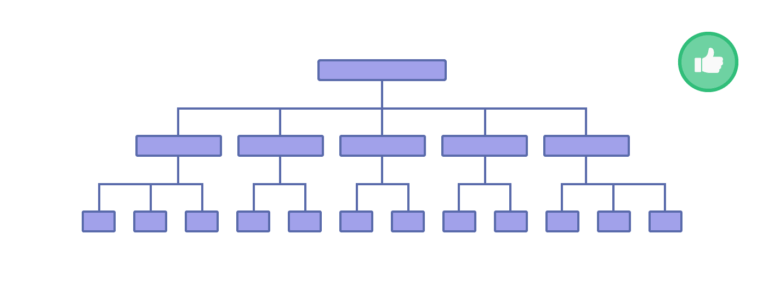

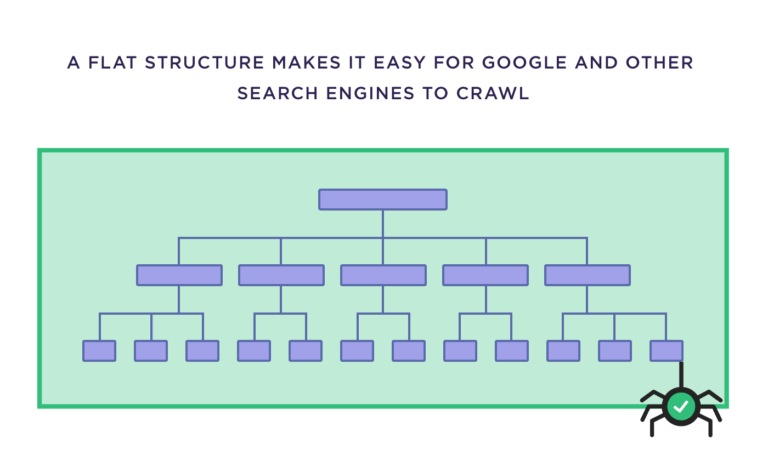

Плоская, организованная структура сайта

Структура вашего сайта — это то, как организованы все его страницы. Она должна быть «плоской»: при ней все страницы сайта находятся в нескольких кликах друг от друга.

Это важно, потому что только такая структура поможет Google и другим поисковикам просканировать абсолютно весь ресурс.

Для личного блога или небольшого сайта местной забегаловки, возможно, это не имеет большого значения. Но если у вас большой интернет-магазин с 250 тыс. разных карточек товара? Плоская архитектура в таком случае — лучший вариант.

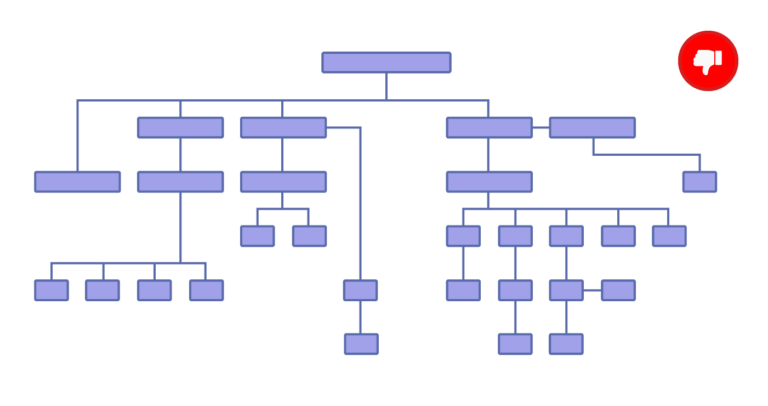

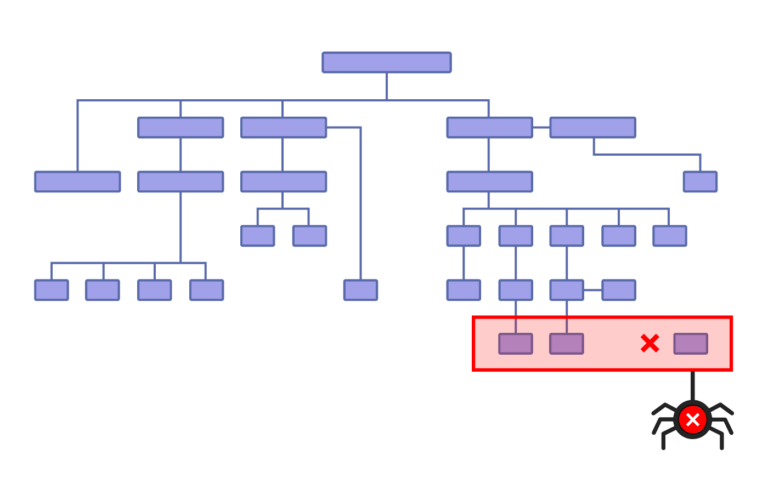

Кроме этого, всю структуру нужно правильно организовать. Другими словами, на скриншоте ниже плохой пример — не делайте так же:

Основная проблема здесь — «оторванные страницы», на которые не указывает ни одна ссылка.

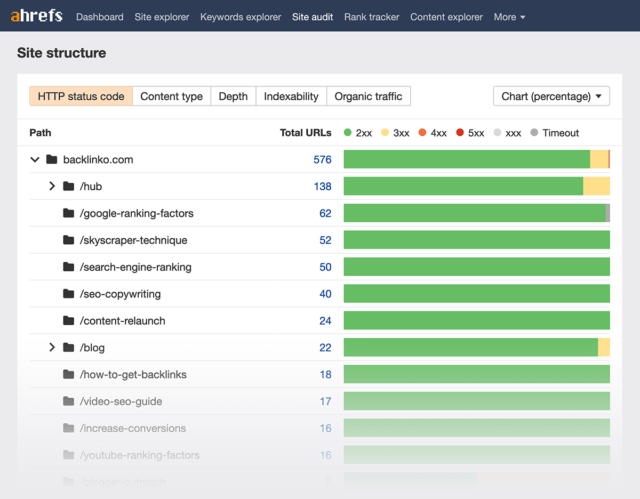

Такие страницы сложнее обойти краулеру. Можно провести аудит сайта через Ahrefs и получить представление о структуре сайта.

Полезно, но не удобно. Чтобы наглядно увидеть расположение страниц и их отношения друг к другу, используйте Visual Site Mapper. Это бесплатный инструмент, который создаст интерактивную карту вашего сайта.

Согласованную структуру URL

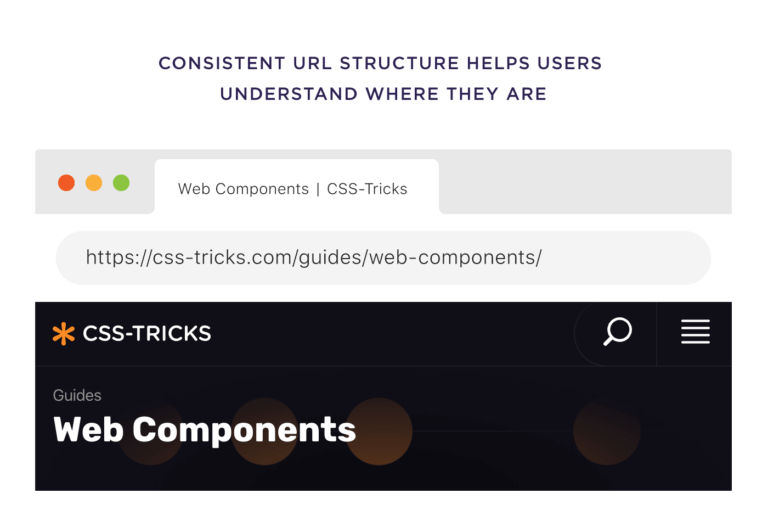

Сразу бросаться править все урлы смысла нет, особенно в случае с небольшим сайтом. Но все равно в них нужна логика и организованность. Это помогает людям понимать, где именно они находятся у вас на сайте.

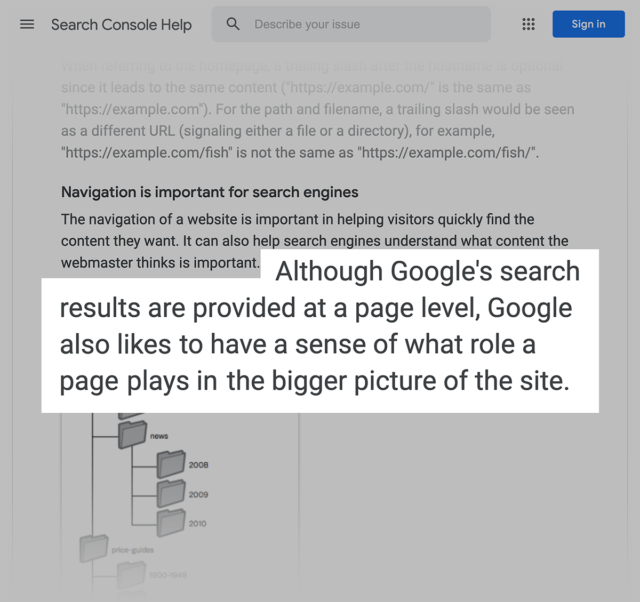

Размещение страниц в соответствующих категориях дает поисковикам дополнительный контекст.

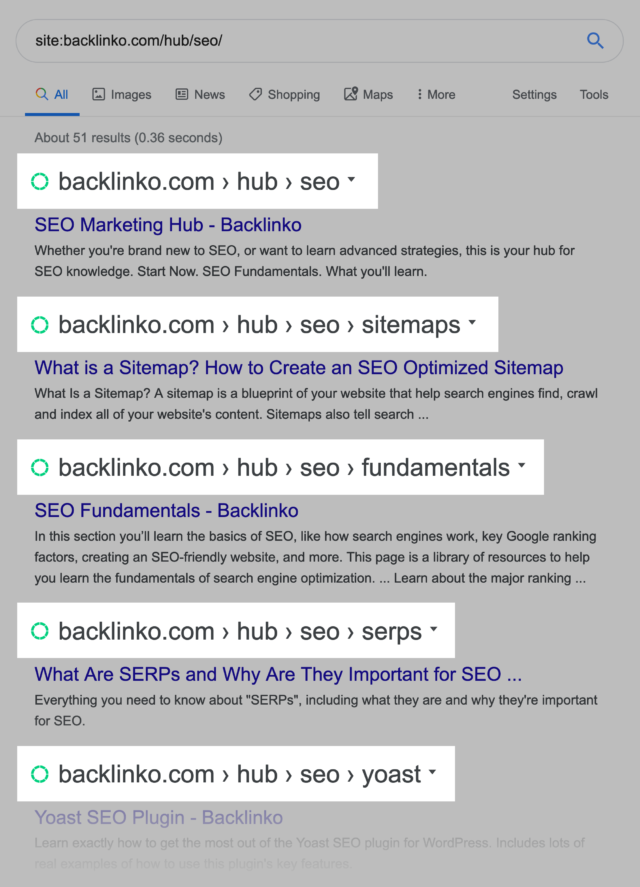

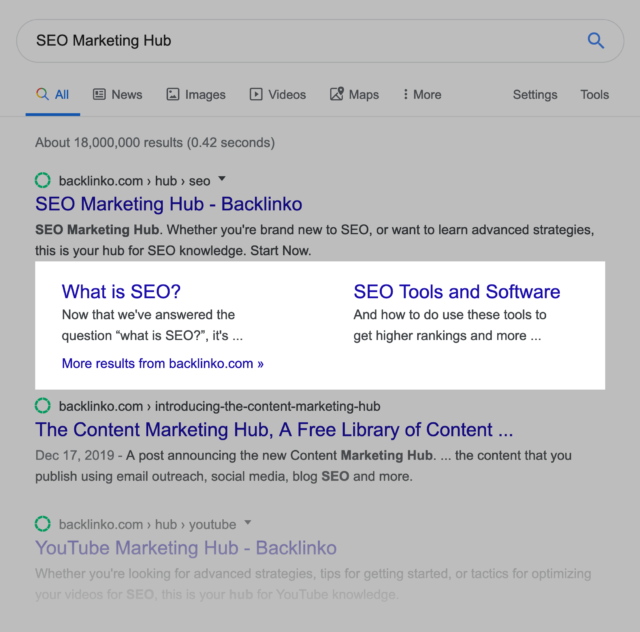

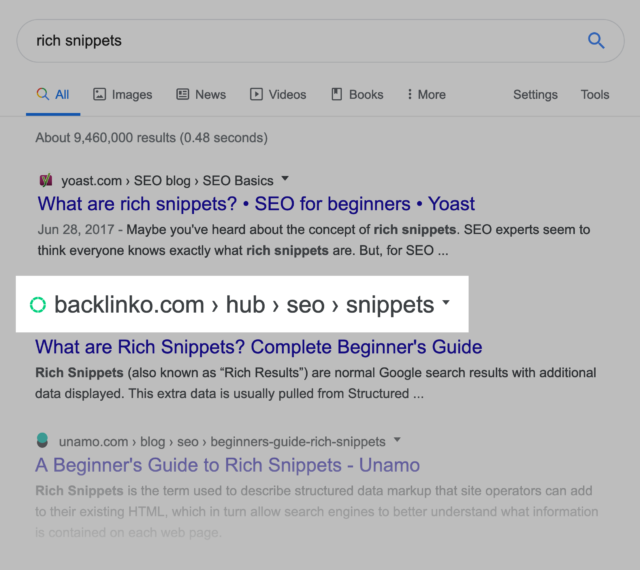

Для примера, на Backlinko есть раздел — SEO Marketing Hub, расположен по адресу /hub/seo/. Для каждой статьи этот каталог не меняется, и Google легче понимает, какая тематика у всех статей из этого раздела.

И это работает. Вы можете видеть, как в Google у сниппетов есть дополнительные ссылки.

Все страницы, на которые Google ставит ссылки, находятся в одном разделе.

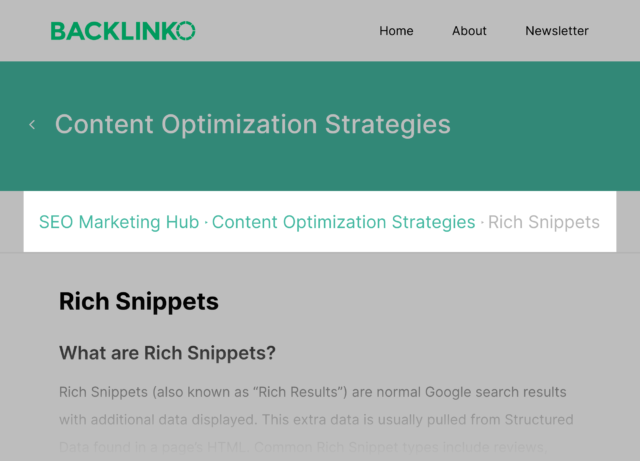

Наверняка вы знаете, что хлебные крошки на сайте — must have. Они автоматически добавляют внутренние ссылки на категории и подстраницы.

Это помогает укрепить архитектуру сайта, не говоря уже о том, что Google превратил URL-адреса в навигационную систему в выдаче.

Поэтому рекомендация: когда уместно, делать навигацию именно по типу хлебных крошек.

Раздел про упрощение поиска сайта в интернете и индексации всех страниц. Вы узнаете, как находить и исправлять ошибки в обходе сайта роботами поисковых систем и как отправлять их на самые глубокие страницы.

Ищем ошибки при индексировании

Первый шаг — найти на сайте страницы, с которыми роботы испытывают трудности при сканировании. Есть три способа это сделать.

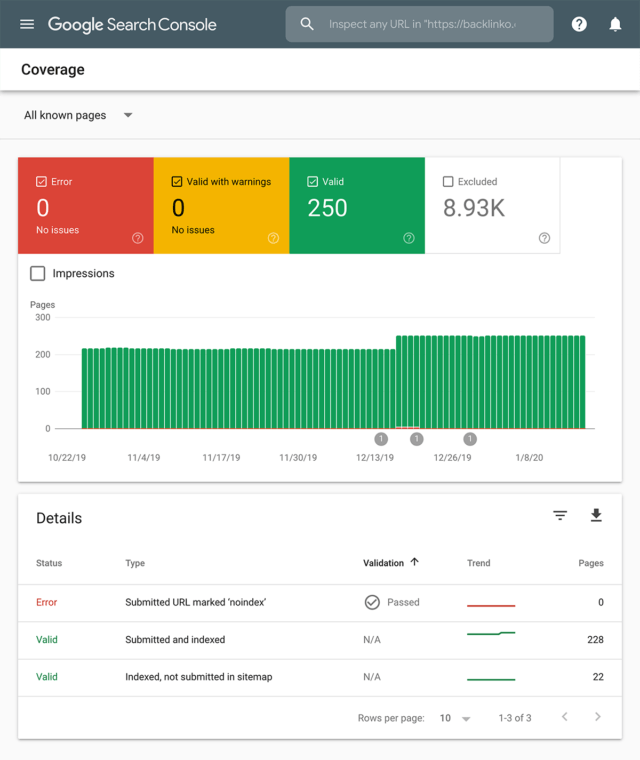

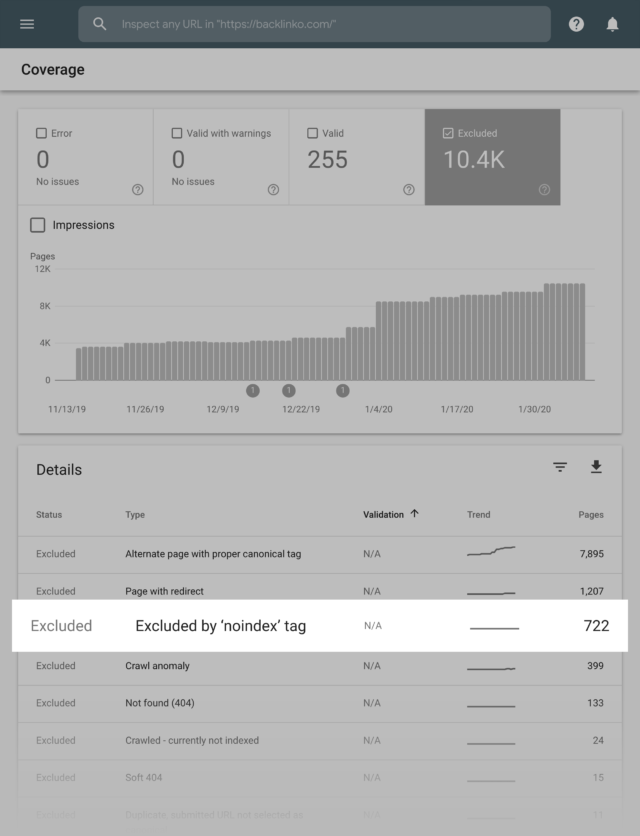

Способ 1. Отчет «Об индексировании»

Отчет есть в Google Search Console. В нем информация, какие страницы Google по какой-то причине не смог проиндексировать.

Способ 2. Через Screaming Frog

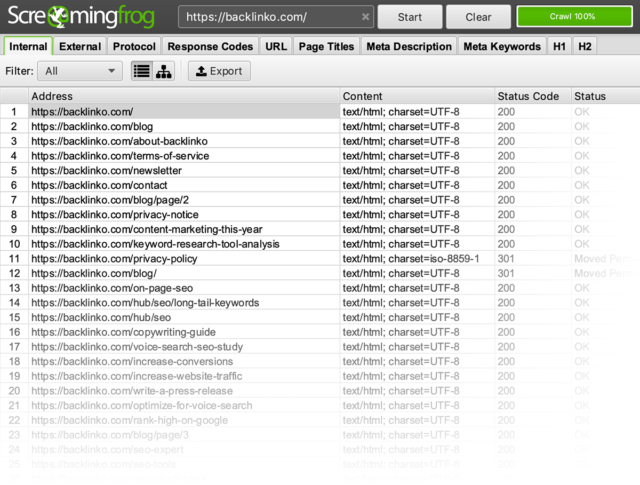

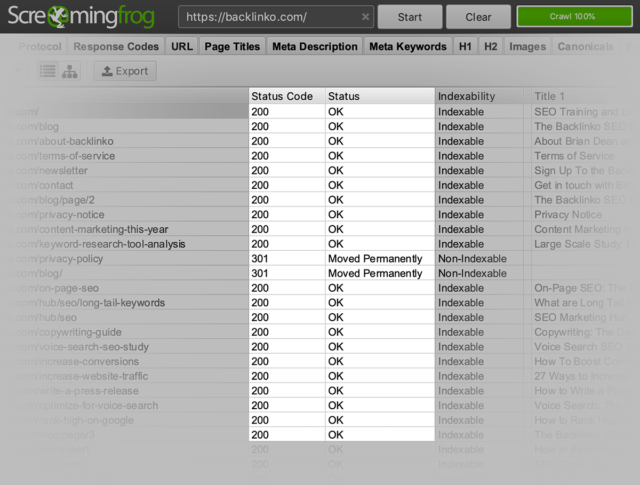

Самый известный инструмент, у которого есть свои роботы, наподобие поисковиков. Как только вы изучите отчет из панели вебмастера, запустите полный обход сайта в этом сервисе.

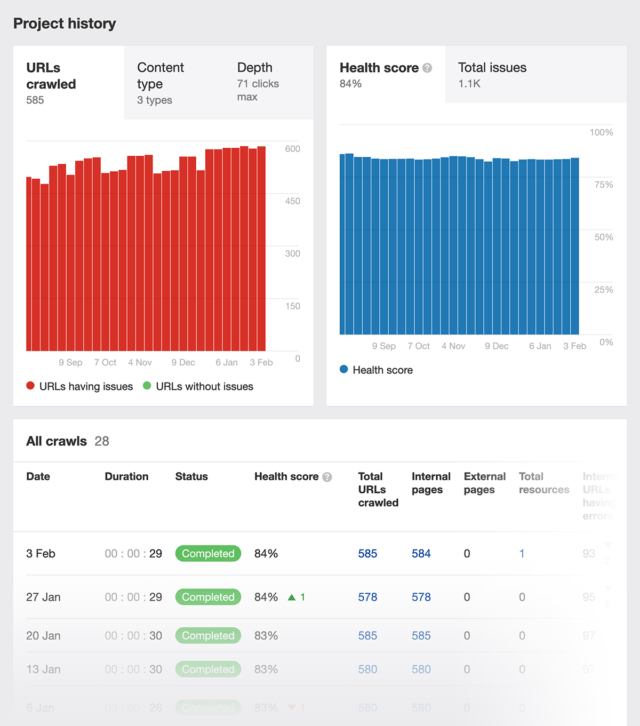

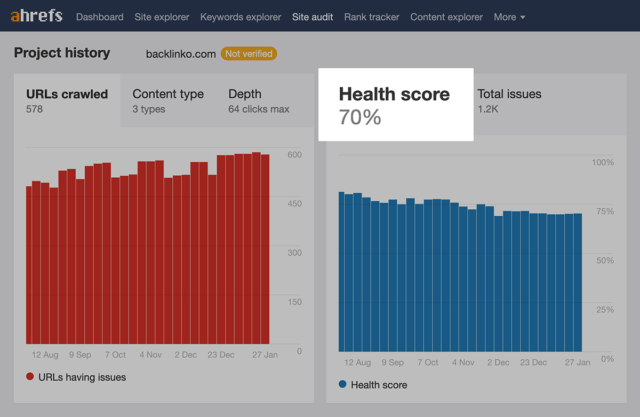

Способ 3. Через Site Explorer от Ahrefs

У Ahrefs есть хороший инструмент.

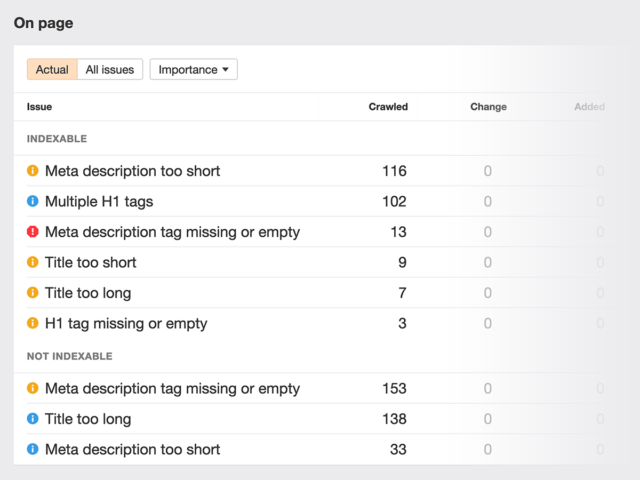

Вы получите информацию об общем техническом состоянии сайта.

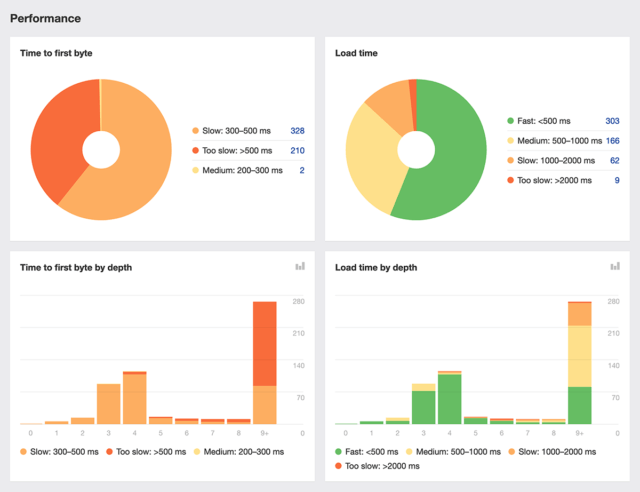

Кроме этого, увидите скорость загрузки страниц.

И проблемы с HTML-тегами сайта.

У всех трех вариантов есть свои недостатки. Если работает с большим сайтом, на котором больше 10 тыс. страниц, используйте все три инструмента. Так точно ничего не пропустите.

Внутренние ссылки на «далекие» страницы

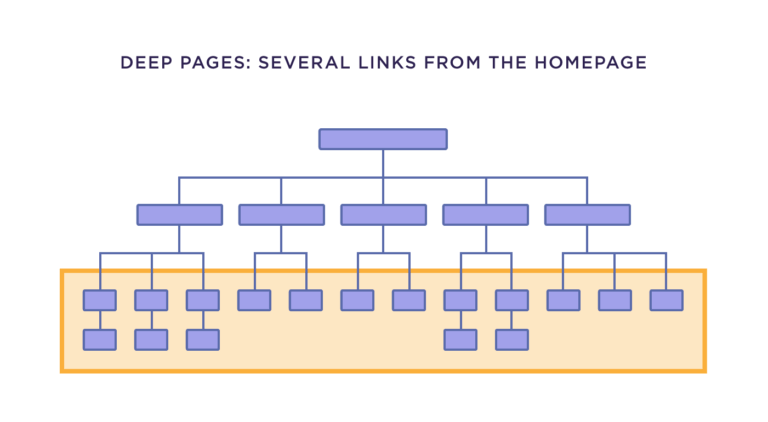

Обычно проблем с индексацией домашней страницы проблем ни у кого не возникает. Трудности появляются, когда речь заходит о далеких страницах, до которых можно добраться только за несколько кликов с главной.

Плоская архитектура обычно предотвращает эту проблему. Если у вас нет страниц дальше 4 кликов от главной, вам повезло.

В противном случае есть дедовский способ: старая добротная ссылка на эту страницу.

Особенно, если страница, с которой вы ставите ссылку, имеет высокий авторитет и ее часто сканирует поисковый бот.

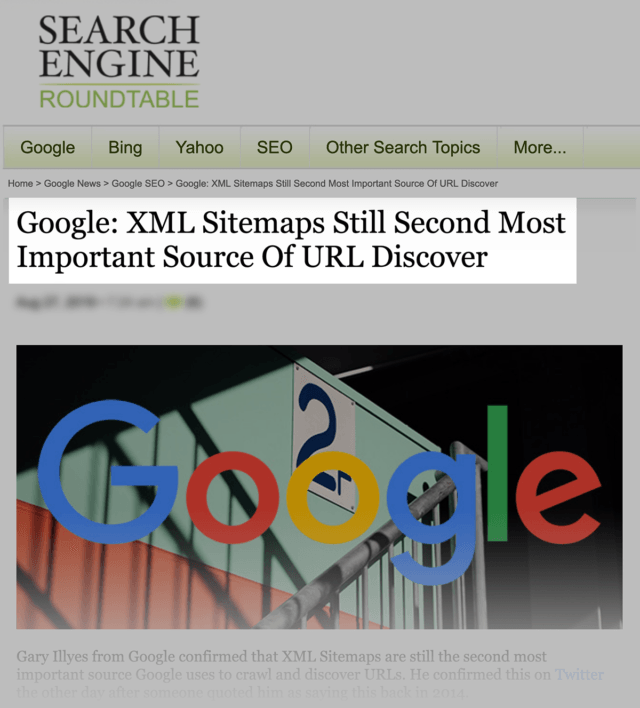

XML-карта сайта

Несмотря на мобильное индексирование, AMP-страницы, поисковикам все еще нужна карта сайта, чтобы найти все нужные адреса. Представитель Google рассказал, что карта сайта — второй по важности источник для поиска URL.

Кстати, про «первый» источник никто не сказал. Есть предположение, что это внутренние и внешние ссылки.

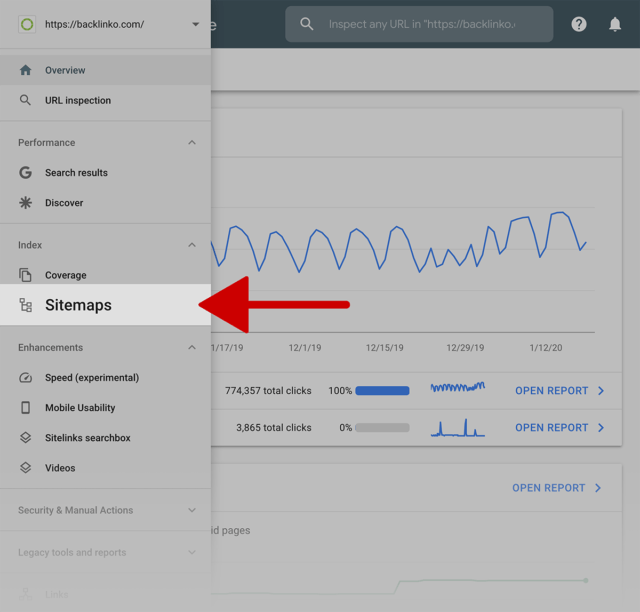

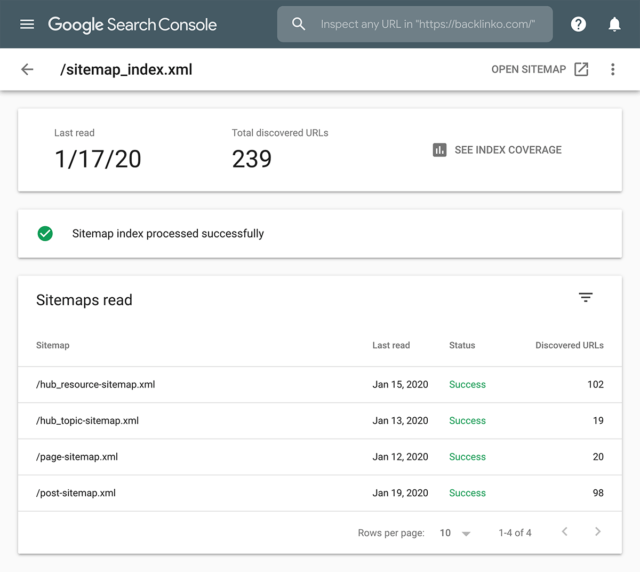

Чтобы проверить, все ли в порядке с картой сайта, зайдите в GSC и выберите отчет «Карта сайта».

Вы увидите ее так, как видит ее Google.

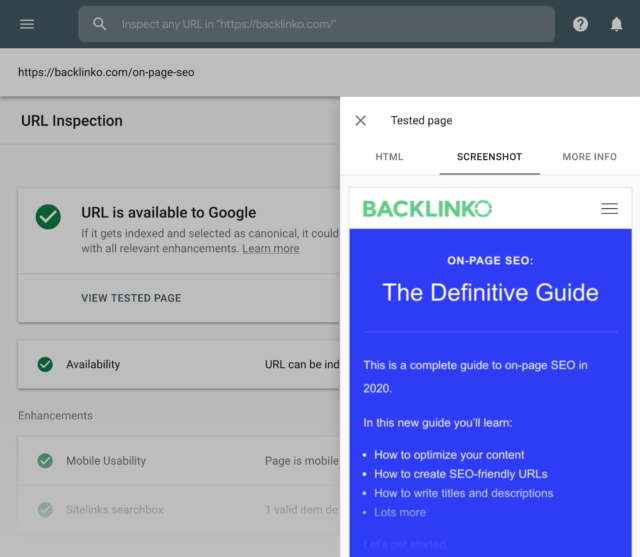

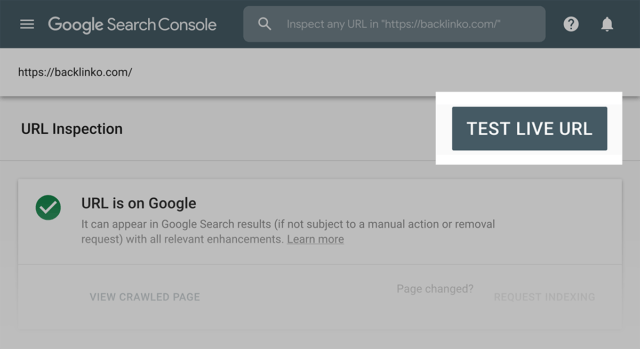

Инструмент проверки URL

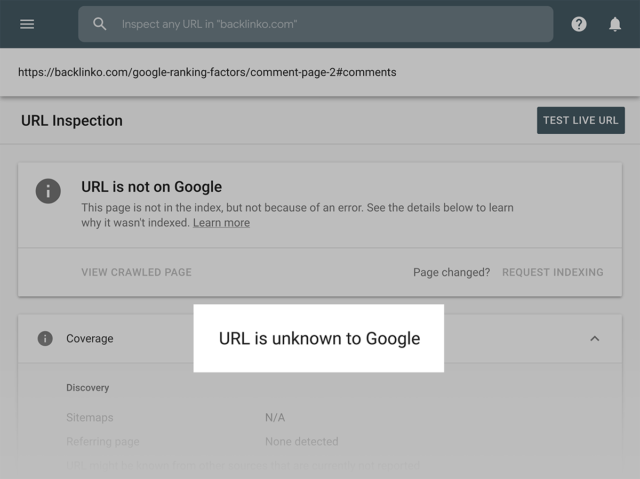

Этот инструмент поможет проверить, почему не индексируется тот или иной адрес страницы. При этом узнаете не только, почему не индексируется конкретная страница:

Но и увидите, как Google отображает уже проиндексированные страницы:

Вы можете дважды проверить, что Google просканировал весь контент на странице.

4. Некачественный или дублирующийся контент

Если вы пишете оригинальные и уникальные статьи, вероятно, вам не нужно беспокоиться о их качестве и возможных повторах.

Проблема дублирующегося контента может возникнуть на любом сайте. Например, если в CMS будет несколько копий одной и той же страницы по разным URL-адресам.

Аналогичная история с некачественным или неполным контентом. Для большинства сайтов это не проблема, но это может повредить рейтингу сайта. Так что нужно это находить и исправлять.

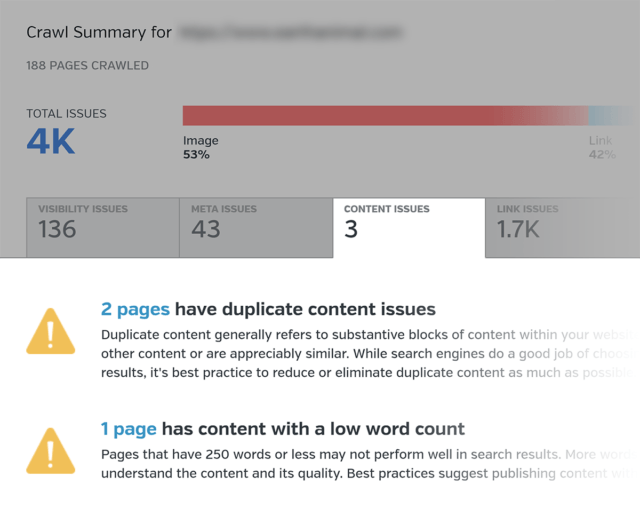

SEO Audit Tool для поиска дублирующегося контента

Два инструмента, которые помогут. Первый — Raven Tools, который сканирует сайт и ищет повторяющиеся или неполные статьи. Вы узнаете, что именно нужно обновить.

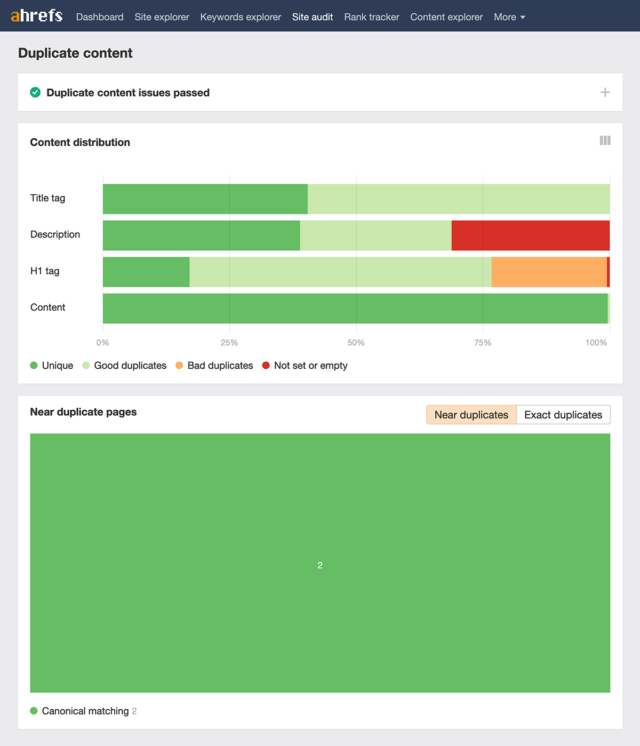

В Ahrefs есть раздел «Качество контента». Он показывает, есть ли на сайте страницы с повторяющимся контентом.

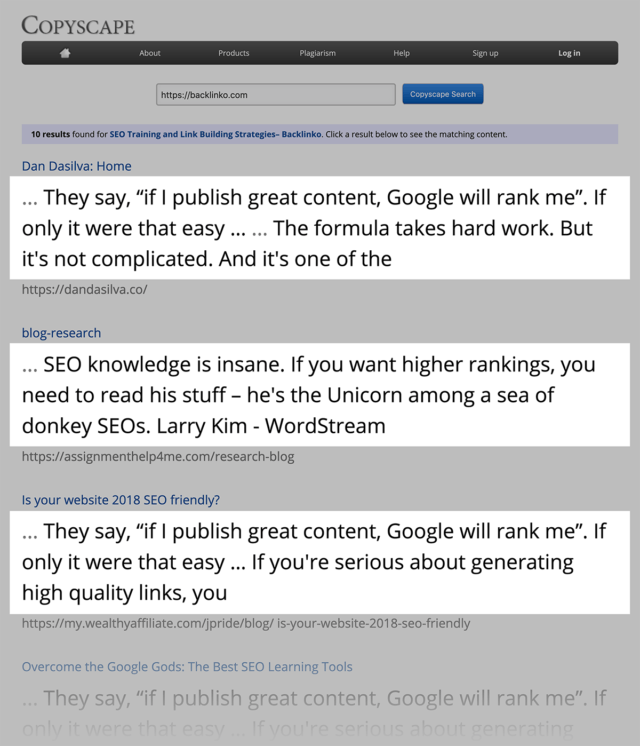

Эти инструменты делают отчет только по вашему проекту. Остался случай, при котором контент пересекается с другими сайтами. Тут поможет «Batch Search» от Copyscape.

Все просто: вводите список URL для проверки, видите страницы с таким же содержимым в интернете.

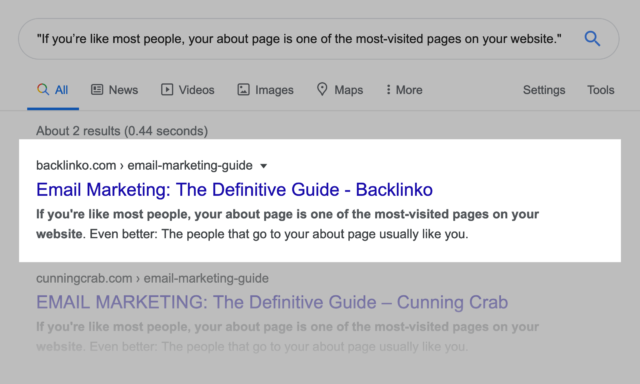

Если вы нашли текст, который есть и на другом сайте, введите его в строку поиска в кавычках. Если Google поместит ваш сайт сверху, бояться нечего — вас считают автором.

Если люди забирают себе ваши тексты, то неуникальность контента — их проблема, а не ваша. Заботьтесь только о вашем сайте, если вы копируете статьи с других источников и не пишете их самостоятельно.

Страницы без уникального контента

У большинства сайтов есть страницы с неуникальным контентом. Это нормально.

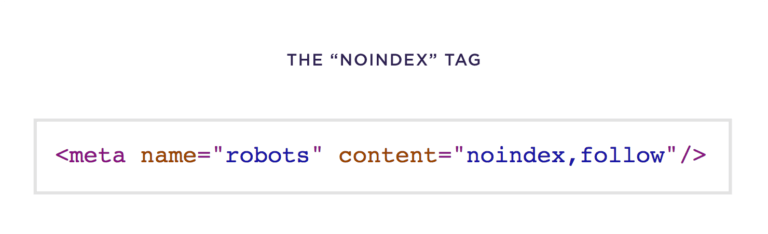

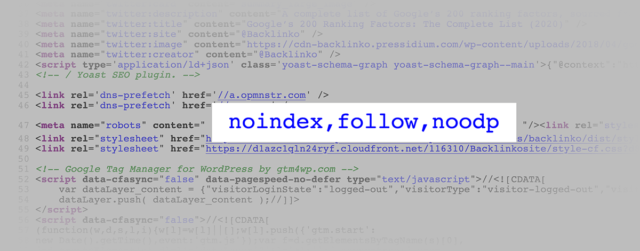

Если такая страница оказывается в индексе поисковика — тогда можно бить тревогу. Добавьте тег «noindex». Тогда системы не будет ее заносить в свой индекс.

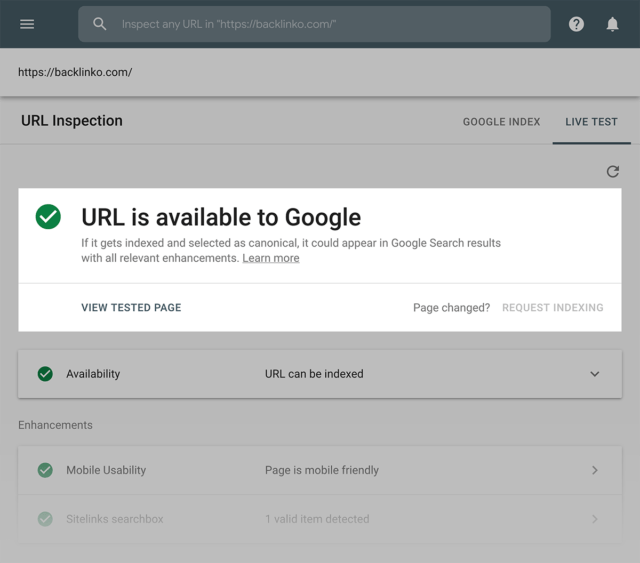

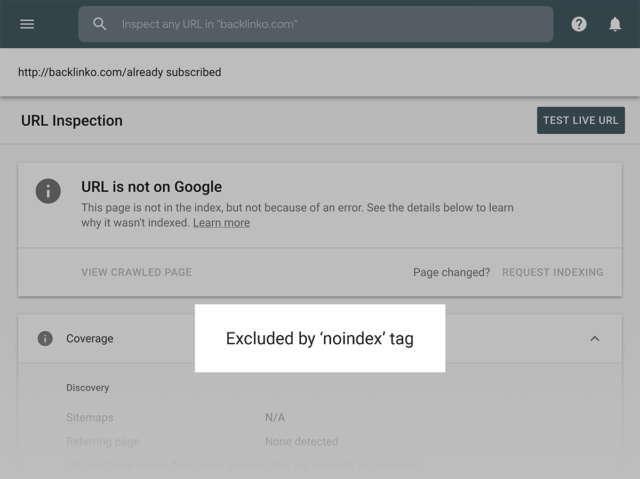

Вы можете дважды проверить , что тег прописан правильно. Воспользуйтесь инструментом для проверки URL в консоли Google.

Если Google по-прежнему может страницу просканировать, вы увидите сообщение, что адрес доступен для поисковика. Это значит, что вы неправильно написали тег.

Если вы видите статус «Исключено при помощи noindex» — все в порядке.

В зависимости от бюджета сканирования, Google может потребоваться несколько недель, чтобы переобойти ваш сайт и удалить из индекса страницы, которые вы пометите тегом.

Я рекомендую проверить вкладку «Исключено» в отчете по индексированию. Убедитесь, что все отмеченные страницы удалены из индекса.

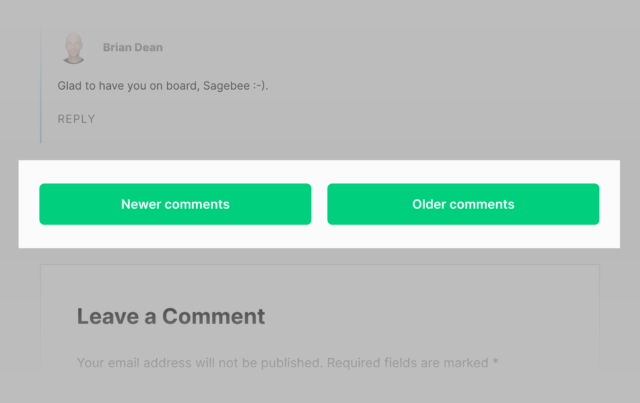

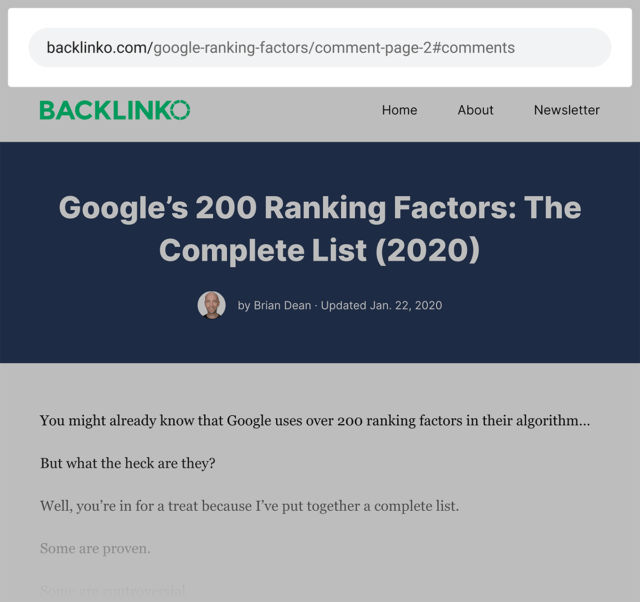

Например, некоторые статьи на Backlinko содержат несколько страниц комментариев.

Каждый отдельный комментарий доступен по ссылке.

Если бы эти адреса были в индексе Google, у нас возникла бы проблема с дублированием контента. Поэтому в таком случае noindex необходим.

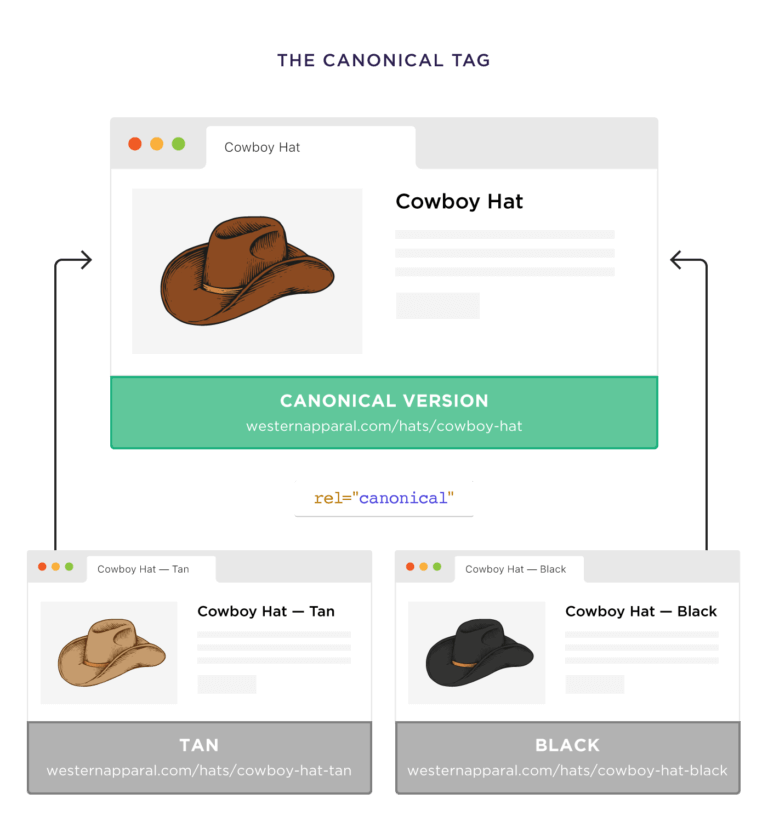

Канонические URL

Большинство страниц с дублированным контентом должны быть помечены специальным тегом. Другой вариант решения проблемы — заменить неуникальный контент уникальным.

Есть третий вариант — использовать канонические URL. Они идеально подходят для случая, когда у вас есть страницы с очень похожим содержимым.

Например, возьмем интернет-магазин со шляпами. Есть карточка товара «Ковбойская шляпа».

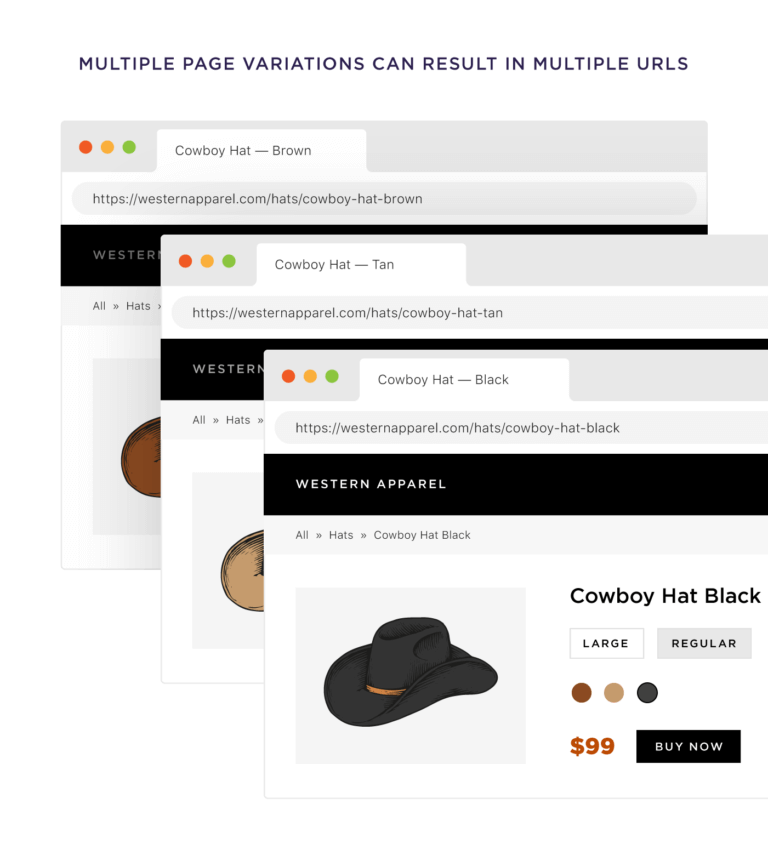

В зависимости от настроек сайта, каждый размер, цвет или вариация может располагаться на отдельном URL.

Вы можете использовать канонический тег, чтобы сообщить Google, что стандартный продукт — это оригинальная страница, а все остальные — ее вариации.

5. Скорость сайта

Напрямую влияет на ранжирование вашего сайта. Это не значит, что достаточно просто ускорить загрузку сайта и попасть в топ-1. Но это увеличивает трафик на ваш ресурс.

В этом разделе будут 3 простых способа повысить скорость загрузки и работы сайта.

Уменьшение размера страниц

Использовать CDN. Почистить кэш. Минимизировать код CSS. Вероятно, эти советы вы читали везде. Но вряд ли видели то, что действительно важно и напрямую влияет на скорость — вес страницы.

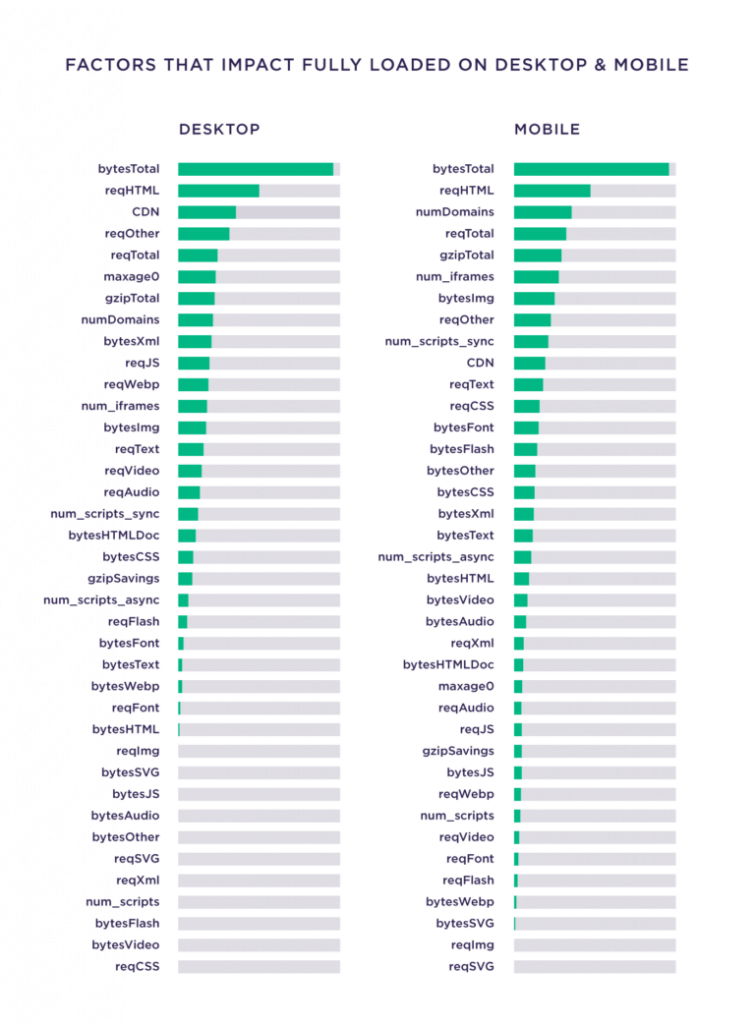

В исследовании скорости загрузки страниц есть вывод, что размер страниц коррелирует со скоростью их загрузки.

Вывод прост: можно сжимать картинки и урезать скрипты. Но если размер страницы остается большим, она продолжит долго грузиться у клиентов.

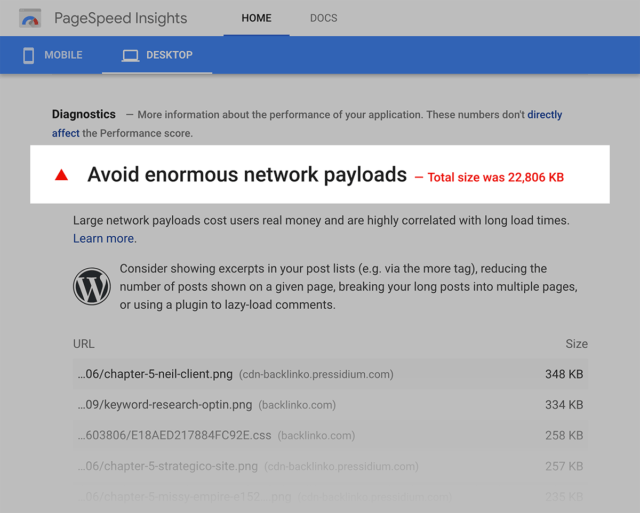

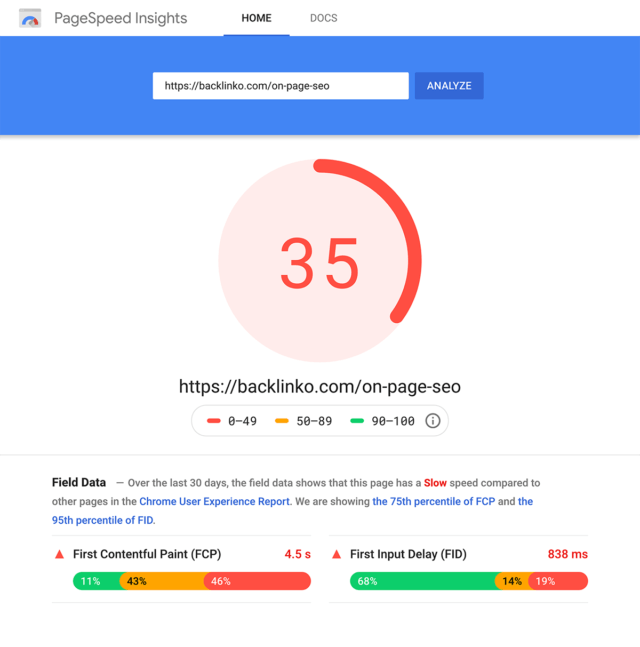

В Backlinko в каждой статье — много больших изображений. Как их ни сжимай, все страницы изначально очень тяжеловесны.

И здесь ничего не поделаешь, с этим придется жить. И в данном случае лучше красивая, но медленная страница, чем плохая, но быстрая. Вот, что говорит PageSpeed Insights.

Но если ускорить загрузку — приоритетная задача, придется жертвовать привлекательностью сайта.

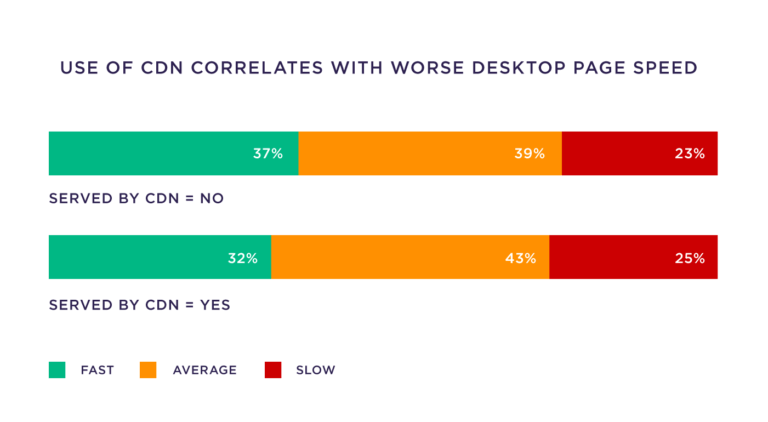

Эксперимент с загрузкой сайта с CDN и без

Из уже упомянутого исследования есть еще один вывод: использование CDN дает большее время загрузки сайта.

Вероятно, это связано с неправильной установкой и настройкой. Замерьте скорость сайта с CDN и без него через инструемент https://webpagetest.org/.

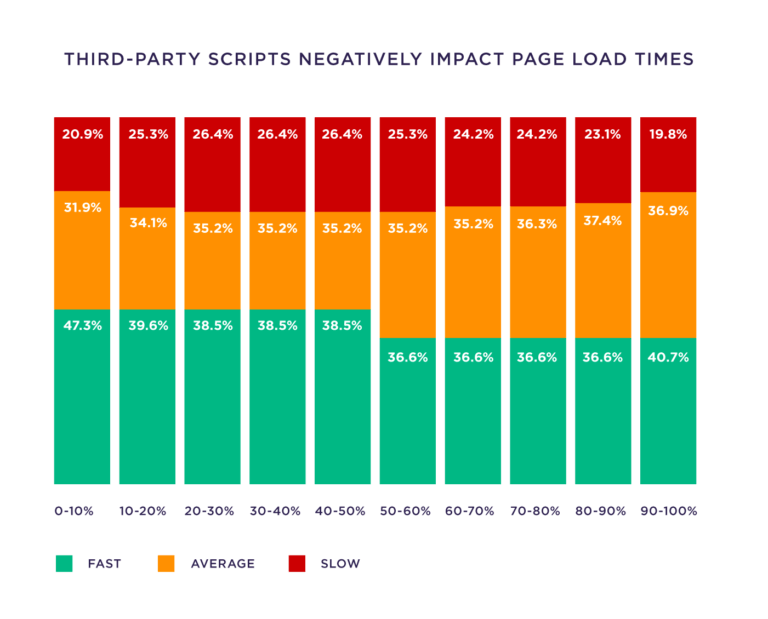

Лишние скрипты

Каждый сторонний скрипт замедляет загрузку сайта на 34 миллисекунды.

Некоторые удалять не стоит, например, скрипты для Google Analytics. Но никогда не будет лишним посмотреть страницы сайта на предмет ненужного кода.

6. Дополнительные фишки технической оптимизации

Тут несколько простых фишек, которые не относятся к предыдущим разделам.

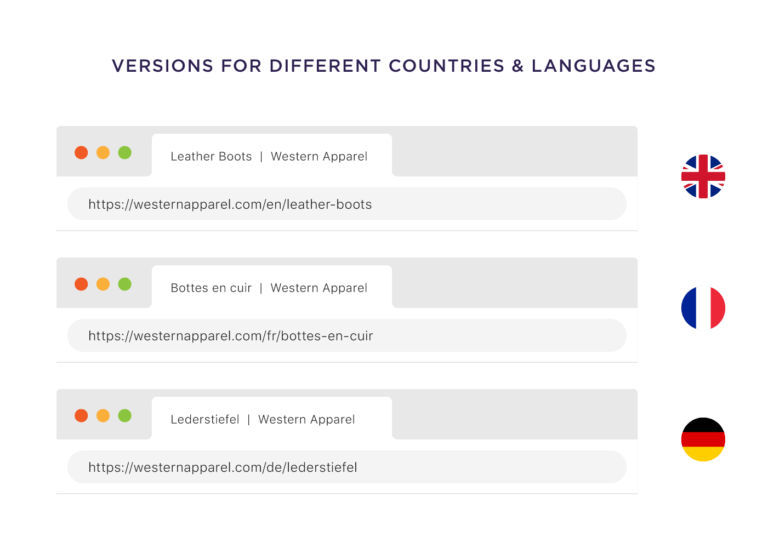

hreflang для международных сайтов

Поможет, если у вас есть несколько версий сайта для разных стран.

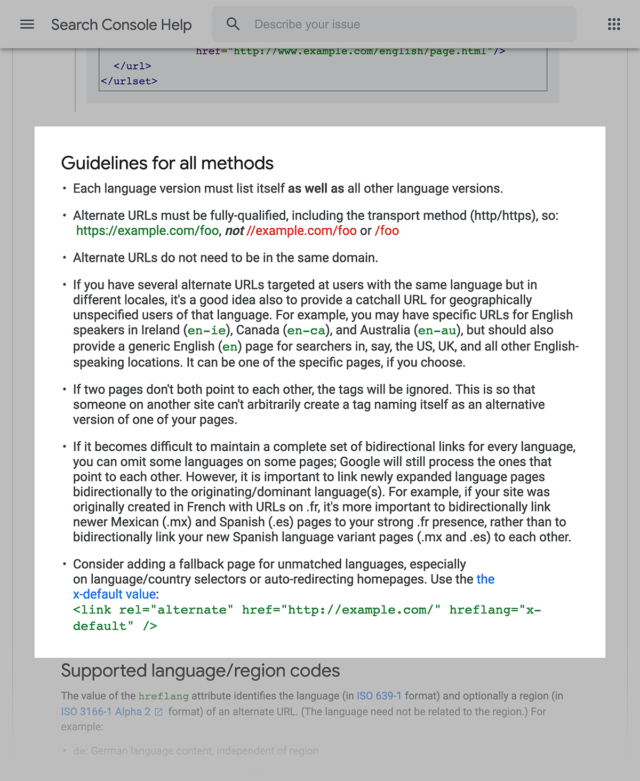

Единственная проблема — сложность настройки. Документация от Google помогает слабо.

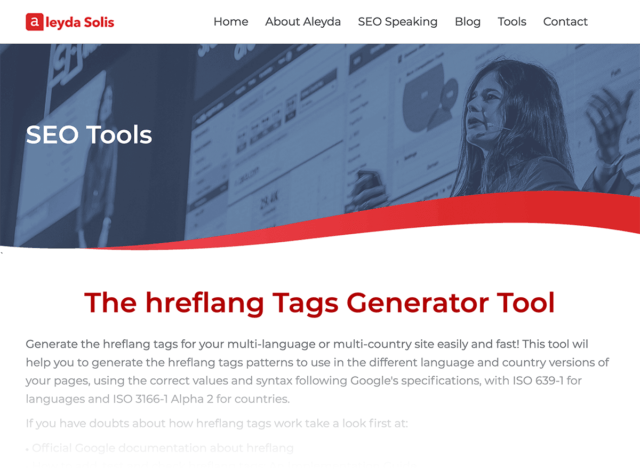

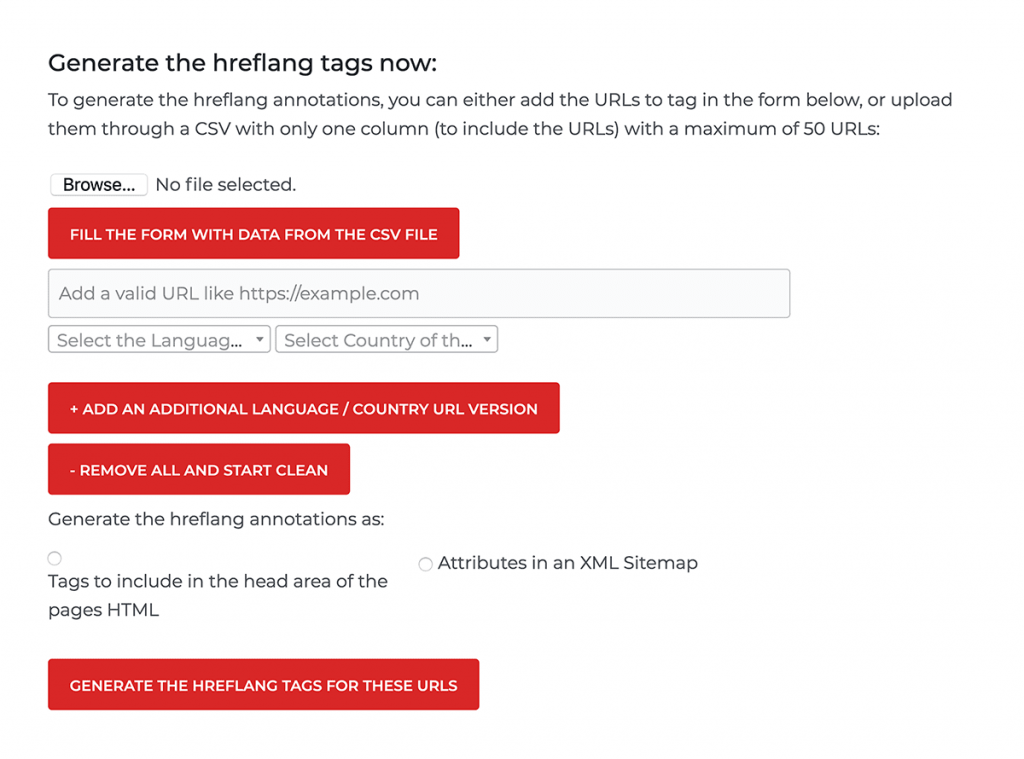

Заходим: Aleyda Solis’s Hreflang Generator Tool.

Инструмент автоматически создает правильный тег для нескольких стран, языков и регионов.

Битые ссылки

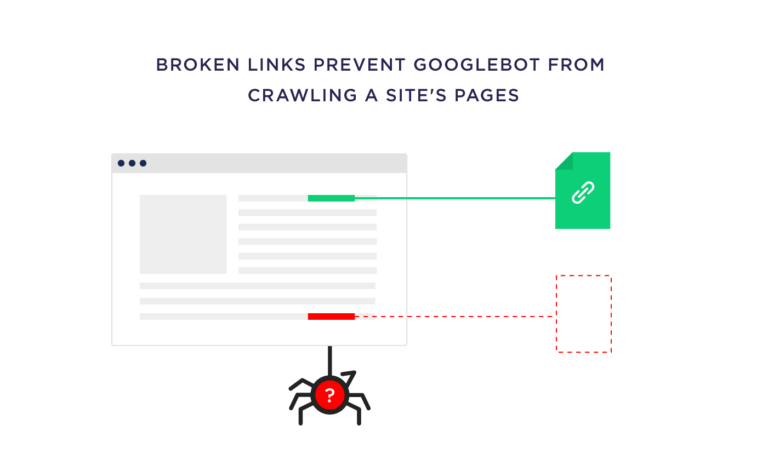

Иногда битые ссылки не проблема для Google, даже если их много. Трудности возникают, если сломаны внутренние ссылки. Тогда ботам поисковых систем будет сложно обойти сайт и проиндексировать страницы.

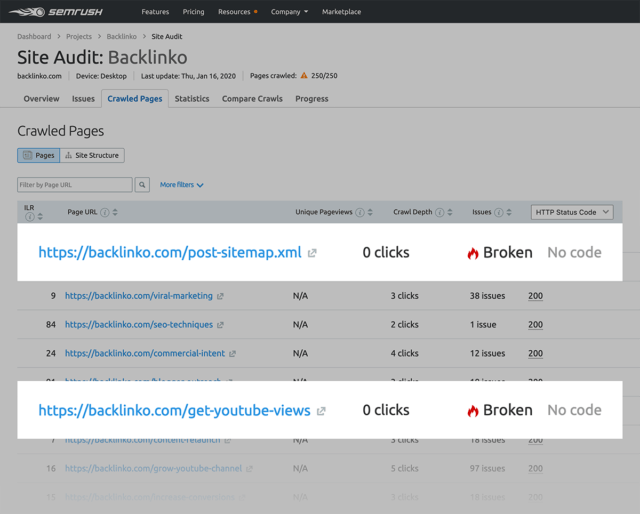

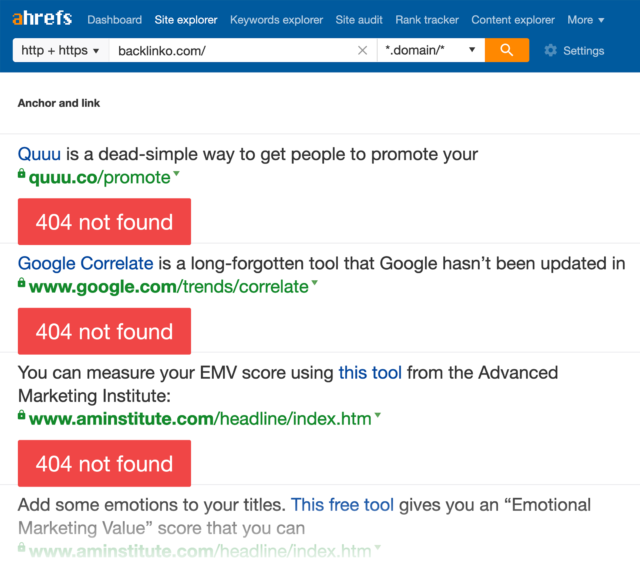

Раз в квартал проводите аудит битых ссылок. Подойдет любой инструмент — Ahrefs, SEMRush и прочие подобные.

Ahrefs:

Screaming Frog:

Структурированные данные

Об этом есть статья про расширенные сниппеты.

Теги Noindex и страницы категорий

Если сайт работает на WordPress, лучше закрыть страницы категорий от индексирования, если они не приносят трафика. Пользы посетителям сайта они не дают, а проблемы с дублированием контента вызывают.

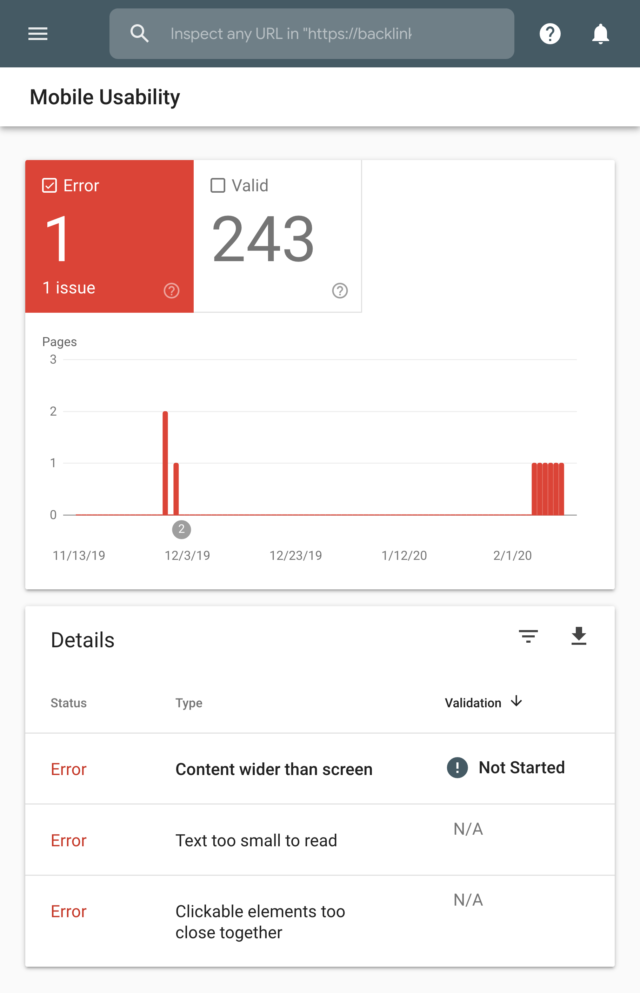

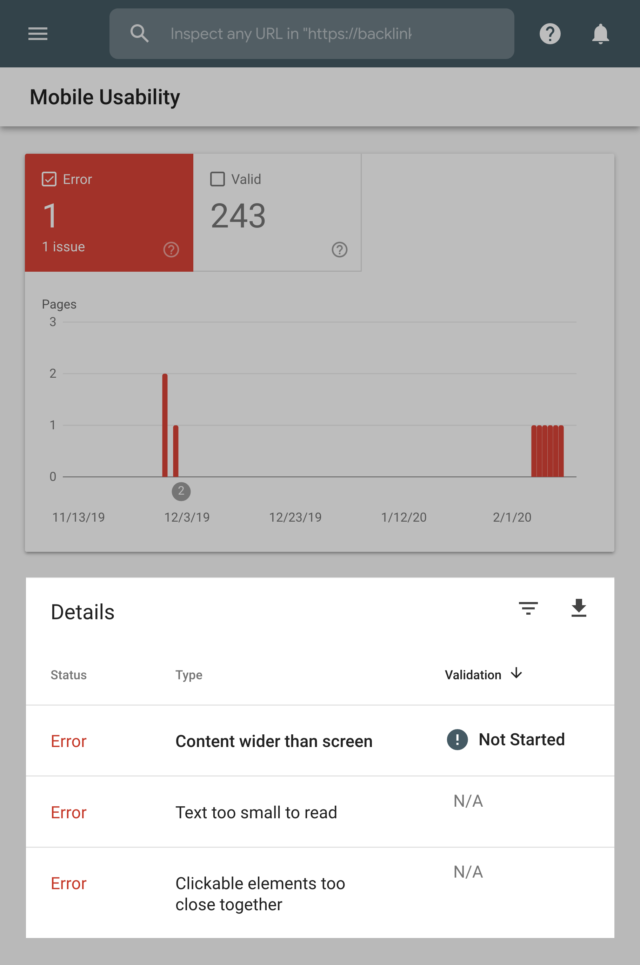

Мобильное юзабилити

Даже не нужно говорить, что адаптация под смартфоны важна.

Если вам кажется, что с мобильной версией сайта все хорошо, лучше еще раз проверить. Если у кого-нибудь возникнут сложности, вряд ли человек напишет вам об этом, и вы о проблеме просто не узнаете.

В GSC есть отдельный отчет о юзабилити мобильных версий страниц. Если система обнаружит, что страница не оптимизирована для смартфонов, вы увидите это в отчете:

И даст рекомендации, что исправить:

Бонус: техническое SEO на примерах с кейсами

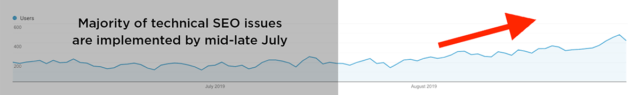

Как Felix увеличил на 250% органический трафик внутренней перелинковкой

Феликс Нортон провел аудит сайта одного из своих клиентов, то был шокирован: на сайте не было внутренних ссылок! Отсюда нет релевантных текстовых анкоров.

Несмотря на то, что в студии написали много качественных статей, которые обязаны были приносить трафик, результата не было в течение 3 месяцев. Контент не ссылался на важные продуктовые страницы, не было связан между собой.

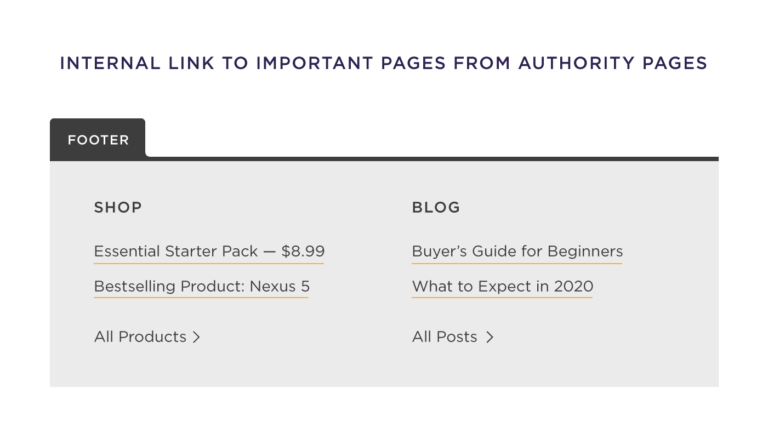

Решили заняться внутренним линкбилдингом. Ставили ссылки на ценные статьи:

На страницы услуг:

Сделали блок с дополнительными статьями по теме:

Трафик вырос на 250%.

Как Salman использовал микроразметку для удвоения трафика

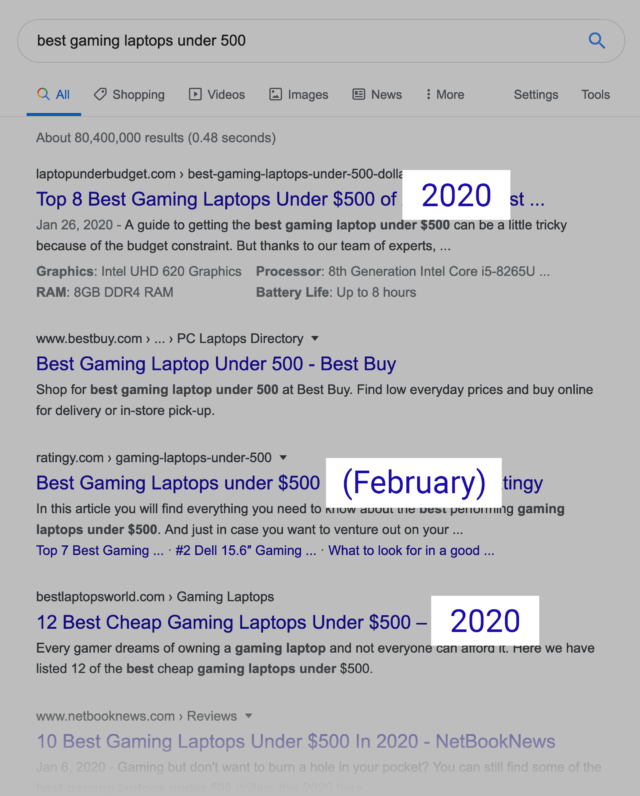

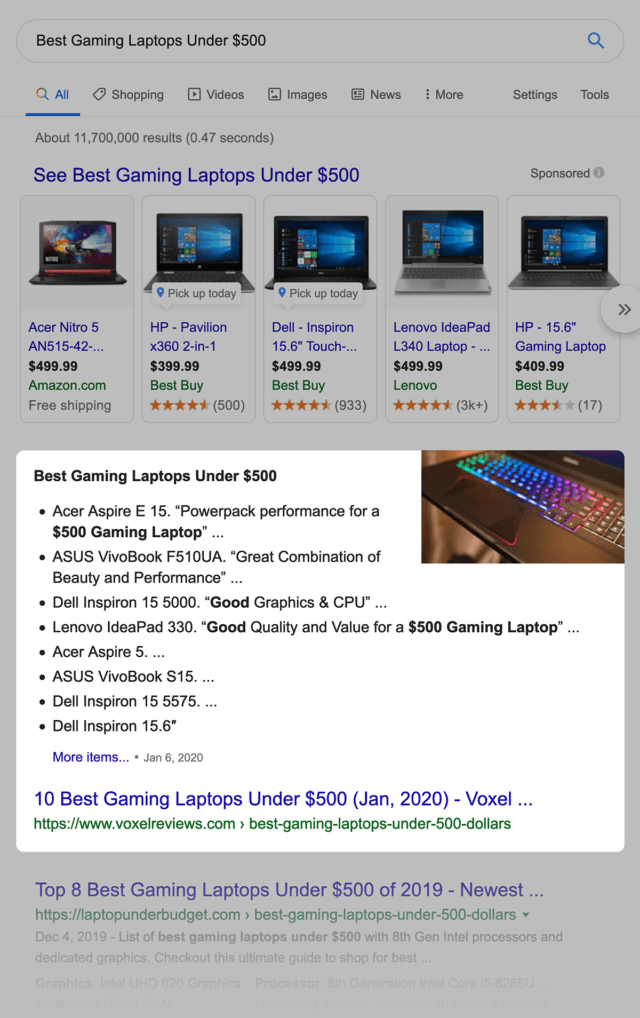

Читатель Backlinko Солман ведет свой сайт Voxel Reviews. Один из самых нужных запросов — «лучшие игровые ноутбуки до 500$».

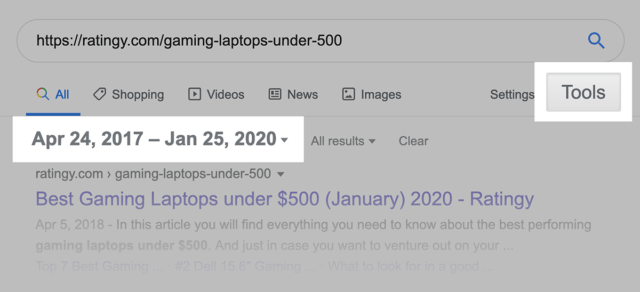

Это запрос с длинным хвостом и ярко выраженным поисковым интентом и высокой конкуренцией. Солман увидел возможность укрепить присутствие в выдаче. В выдаче почти на всех заглавиях был указан текущий год.

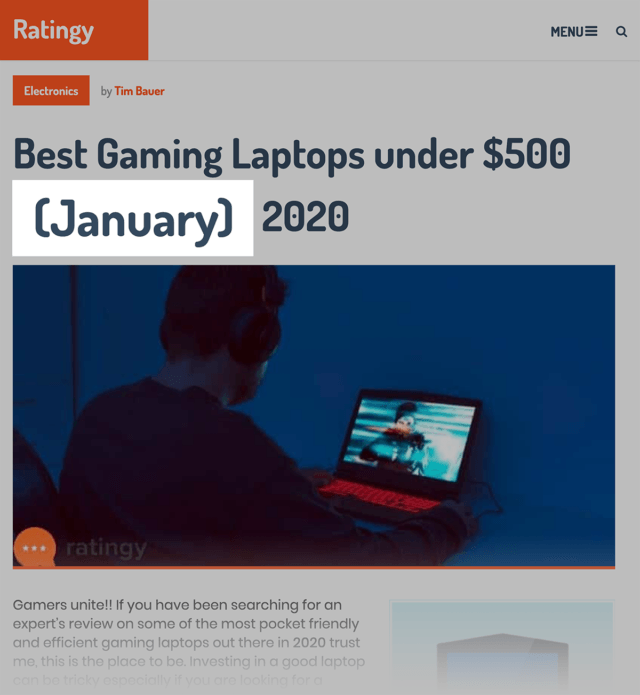

Но информация на этих страницах была неактуальна. Люди меняли год в заголовке, но не изменяли контент на странице. Например, эта страница просто автоматически подтягивает в заголовок текущий месяц:

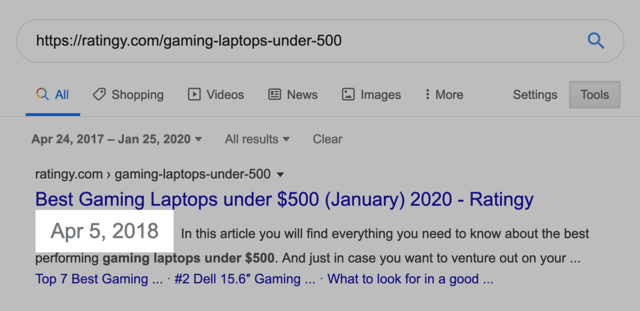

Но URL при этом не меняется:

И вот фактическая дата публикации статьи:

Солман мог бы просто добавить текущий месяц в тег заголовка, как у всех конкурентов в топе. Но если Google увидит, что страница законно обновлена, то Солман получит преимущество.

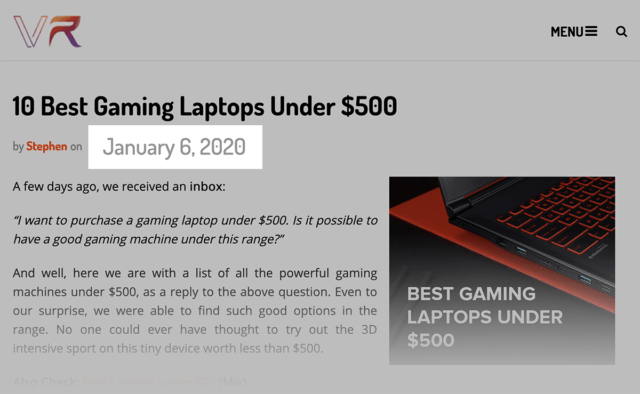

Он добавил дату в начало своей статьи:

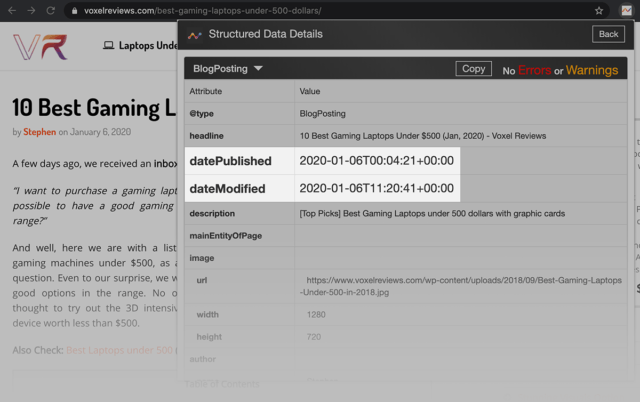

И обновил данные в микроразметке — изменил поля «datePublished» и «dateModified».

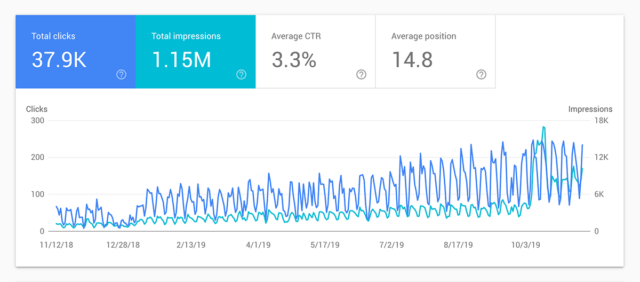

Это помогло Солману получить расширенный сниппет:

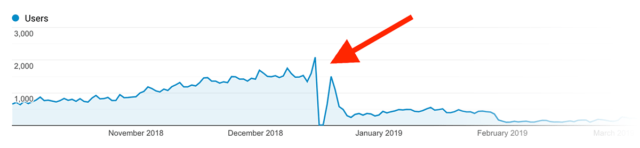

И увеличить трафик:

Как Нил обратил неудачный переезд сайта во благо

У клиента Нила резко упал трафик.

Это случилось из-за переезда на новую версию CMS Magento. При переносе сайта также внесли изменения в структуру URL, удалили много ссылок без анализа, как это скажется на трафике.

За два месяца трафик с 30 000 упал до 2 000 визитов.

Нил провел аудит, нашел проблемы:

- Были оторванные страницы, на которые не вела ни одна ссылка.

- Канонические страницы с noindex.

- Последовательный редирект на нескольких страницах одновременно.

- Неработающие внутренние и внешние ссылки.

- В карте сайта были адреса, которые не нужно индексировать.

- Неоптимизированные метатеги и описания.

После устранения проблем трафик начал снова расти:

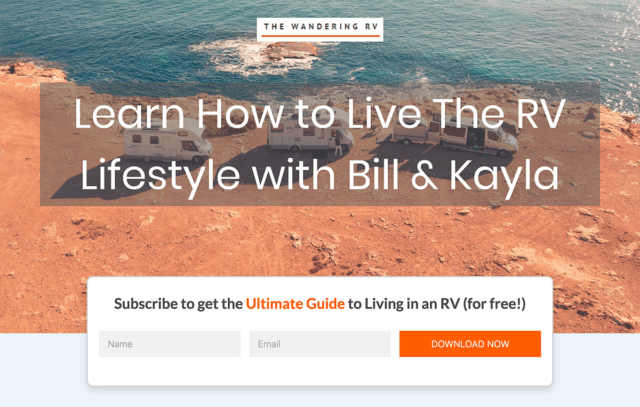

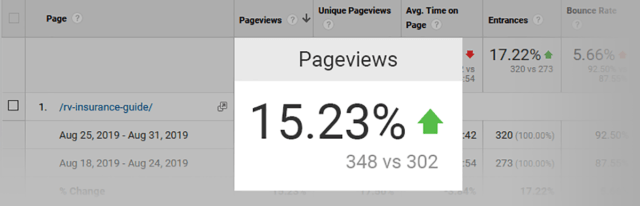

Как использование SchemaORG для FAQ увеличило CTR на 15.23%

Билл Уидмер ведет блог The Wandering RV.

Одна из самых важных страниц сайта — руководство по страхованию.

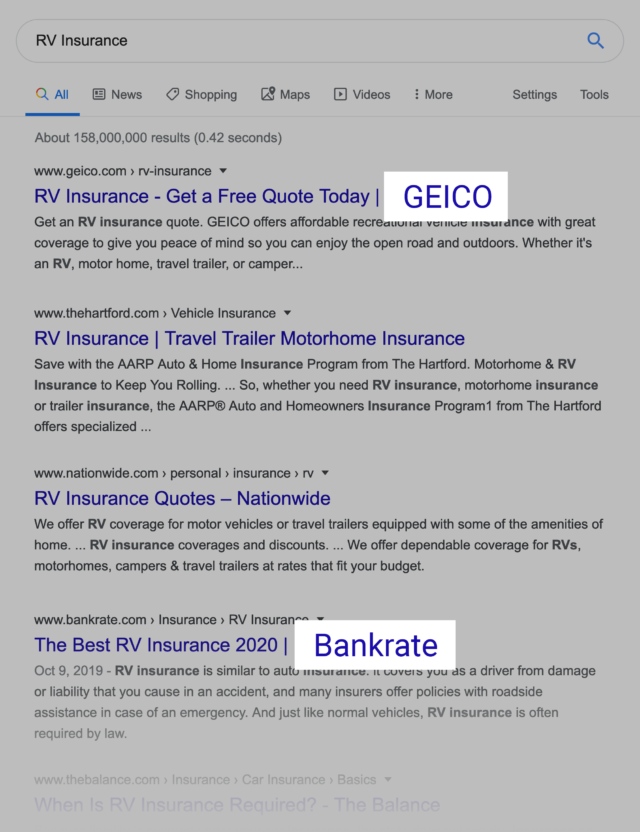

К сожалению, по релевантным запросам в выдаче были сильные бренды — Geico и Bankrate.

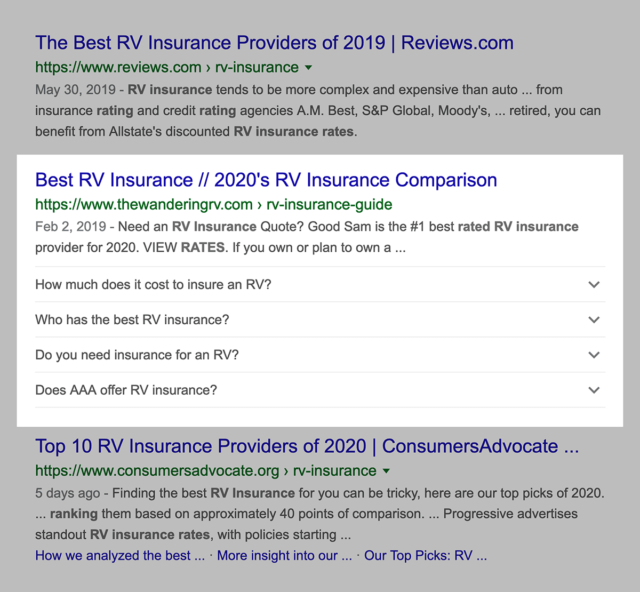

Шансы, что Билл сможет поднять сайт выше конкурентов, были весьма малы. Он решил использовать микроразметку для вопросов и ответов, чтобы увеличить количество переходов на сайт из расширенного сниппета.

CTR вырос:

Заключение

На этом все. Какой совет показался вам наиболее интересным и полезным? Что попробуете в первую очередь?