Когда поисковая система получает запрос на индексирование сайта, она ведет себя как банк, который получил заявку на кредит. Целая команда банковских служащих начинает проверку заявителя: работа, доходы, кредитная история, благонадежность, родственники и многое другое. Если вам удалось пройти фильтр банка и не попасть в черный список – вы получаете деньги. ПС в качестве бонуса предлагает позицию выдачи: чем лучше сайт, тем выше он стоит в результатах поиска.

Само понятие «фильтр» находится между терминами «алгоритм» и «санкции». Фильтр встроен в алгоритм системы и дает команду о «неправильности». Машина или человек на основании полученных данных принимают решение о наложении санкций (снижении позиций выдачи или отправке сайта в БАН).

Чтобы успешно продвигать ресурс, необходимо знать три вещи:

- Какие бывают фильтры.

- Каковы требования ПС к сайтам.

- Как избежать наложения штрафных санкций.

Будем говорить о двух крупнейших ПС, которые являются бесспорными лидерами в русскоязычном сегменте Интернет: Яндекс и Гугл.

Фильтр сайтов Яндекс

Наша родная поисковая система регулярно знакомит пользователей с новыми алгоритмами, которые появляются для проверки сайтов. Всю актуальную информацию можно узнать из блога.

Снежинск

Первым прорывом к «умному» поиску можно считать появление алгоритма «Снежинск», куда была встроена система машинного обучения «Матрикснет». Благодаря накоплению сопоставлений «запрос – переход на страницу – время визита и поведение» вычислялись не только прямые включения в текст страницы запроса пользователя, но и «рядом стоящие». Однако это работает только для высокочастотных запросов, то есть тех, которые часто задаются в поисковой системе. Низкочастотные запросы не дают возможности получить достаточный для анализа объем данных.

Палех

Следующим шагом стал алгоритм «Палех», основой которого являются нейронные сети. Он позволяет сопоставить релевантность заголовка и ключей.

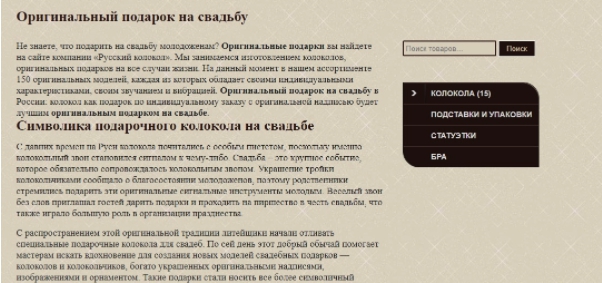

Большинство ограничений, связанных с вычислительными мощностями и работой самого алгоритма, были сняты в «Королев». Это уже искусственный интеллект, позволяющий оценить запрос и выдать релевантный ответ даже при отсутствии прямых ключей. Например, «русский комедийный сериал про врачей с Охлобыстиным». Уже на четвертой позиции видим то, что нам нужно.

В эти алгоритмы органично встраиваются фильтры Яндекса.

АГС

По номеру модификации добавляются еще и числа. Расшифровывается аббревиатура как «АнтиГ**ноСайт». Фильтр актуален по сей день, так как найти адекватную информацию в сети становится все труднее и труднее.

Санкции накладываются за:

- сео ссылки на другие ресурсы;

- плохой контент (нерелевантный, неуникальный, нечитабельный);

- проблемное юзабилити и некачественный дизайн;

- нарушение технических требований Яндекса.

Баден-Баден

Этот фильтр стал страшным сном всех старых рптимизаторов. Раньше для быстрого продвижения сайта было достаточно набить его ключами и закупить тонну ссылок.

Баден-Баден накладывает санкции за переоптимизацию. Это значит, что тексты с огромным количеством некорректно встроенных ключей попадают под фильтр.

Администрация Яндекс утверждает, что имеет механизмы, отличающие переоптимизированный контент от «естественного» текста, автор которого не имеет ни малейшего понятия о плотности и тошноте. Однако имеются случаи жалоб на санкции для таких текстов.

Есть и обратный пример качественно написанного текста с высокой плотностью ключей.

Сайт находится в первой позиции.

Так что не все так однозначно с этим фильтром. Если текст качественный и авторский, то скорее всего Баден-Баден не будет на него действовать.

Накрутка поведенческих метрик

Поведенческие факторы включают в себя:

- переход по ссылке;

- время нахождения на сайте;

- время нахождения на каждой странице;

- переход по внутренним ссылкам;

- выполнение целевых и других действий.

Есть много платных сервисов, которые предлагают услуги по реализации всех этих действий. Если работает автомат, то вы почти наверняка попадетесь. Когда накрутку осуществляют живые люди, вероятность бана меньше, но все равно есть. Ведь учитываются не просто факты нажатия на кнопку или время на странице. Все оценивается в комплексе, например, хаотическое перемещение по ссылкам воспринимается ПС как отсутствие корректной навигации.

Минусинск

Этот фильтр связан со ссылочным продвижением. Большое количество внешних ссылок, ведущих с некачественных и нерелевантных сайтов приведут к наложению санкций. А если учесть, что Яндекс больше не учитывает ссылки и они не влияют на вес сайта, то ссылочное продвижение становится бессмысленным.

Аффилиаты

Некоторые предприниматели пытаются продвинуть не один сайт, а сразу несколько, по одной и той же тематике, и одинаковым ключам. Если при этом владелец у сайта один, совпадают контактные данные, то Яндекс не допустит все ресурсы в ТОП. В выдачу попадет произвольно выбранный из всех имеющихся. Поэтому если вы хотите продвигать таким способом, меняйте ключи и предлагайте разные услуги. Например, «Обучаем SЕО», «Продвинем Ваш сайт» и «Обеспечим любой сайт качественным контентом» для одной и той же организации, занимающейся продвижением. Тогда вы не забьете первую страницу своими ссылками, «выдавив» конкурентов, но будете мелькать перед глазами пользователя по разным запросам.

Как не попасть под фильтрs Яндекса

Полный перечень требований Яндекса можно найти здесь.

- Самое главное требование – создавайте для людей. Это значит что нужно большое внимание уделить юзабилити и контенту.

- С технической точки зрения обзаведитесь файлами robots.txt и sitemap.xml.

- Заполните мета-теги, используйте канонические URL

- Не забывайте про редирект 301.

- Следите за валидностью HTML разметки.

- Не используйте навигацию JavaScript и фреймы.

- Вместо заглушек ставьте страницу ошибки 404.

Вывод из-под фильтра Яндекса

Система единичных устранений недочетов для вывода из-под конкретного фильтра больше не работает. Сейчас очень трудно понять, из-за чего именно были наложены санкции, только если не пришло письмо от Платона Щукина. Тревожными звонками являются:

- Снижение позиции в выдаче.

- Отсутствие индексации или медленная индексация новых страниц.

- Приток посетителей с Яндекса резко уменьшился.

Если вас уличили в накрутке поведенческих факторов, то вы получите письмо с сообщением.

Еще одним признаком бана является отсутствие вашего сайта в выдаче по адресу. То есть, вы вводите URL в поисковую строку, а страница не найдена.

Общего рецепта для снятия санкций не существует. Можем дать только общие рекомендации:

- Пересмотр маркетинговой стратегии. Перестаньте пользоваться старыми методами – они не работают. И тем более не используйте черное СЕО.

- Полная проверка юзабилити и обновление контента. Не обязательно переписывать все тексты. Перепроверьте их, обновите фотографии. Сделайте удобную навигацию.

- Почистите все технические баги. Добейтесь валидности сайта, заполните мета теги, заголовки. Оптимизируйте видео- и графический контент.

- Постарайтесь избавиться от внешних ссылок, которые система считает неестественными. Это самое трудное, так как зависит не от вас, а от владельцев доноров. Особенно сложно, если вы купили домен, который продвигался ссылками.

В любом случае вывод из бана занимает месяцы. Нужно набраться терпения и продолжать работать с ресурсом.

Фильтры Google

Алгоритмы Гугл проще, чем у Яндекс, зато именно они придумали первыми PageRank – учет внешней ссылочной массы. Сейчас это уже не актуально, а в 2000 году было прорывом. С 2003 года Гугл наказывает за нерелевантные анкоры и переспам. В компании тщательно скрывают информацию об алгоритмах, зато про фильтры знают все.

Панда

Этот “зверь” следит за качеством контента и оценивает сайт по следующим критериям:

- уникальность;

- пиратский контент;

- повторяющиеся страницы (продвигаемые по одним ключам);

- юзабилити;

- реклама.

Пингвин

Фильтр, связанный со ссылочным продвижением. Отслеживает искусственное наращивание ссылочной массы, нерелевантные ссылки, некачественные анкоры. Санкции накладываются за покупку линков, ссылочный спам на форумах, маскировка под гостевой постинг и т.д.

В бан сайт не отправляется, но ссылки не участвуют в ранжировании, и позиции выдачи снижаются.

-5, -30, -950

Официального подтверждения наличия этих фильтров в алгоритме нет. Но опытным путем было замечено снижение позиций за черную оптимизацию (дорвеи, клоакинг), редиректы на JavaScript, некачественный сайт.

Санкции заключаются в снижении позиций на указанное число.

Дополнительные результаты

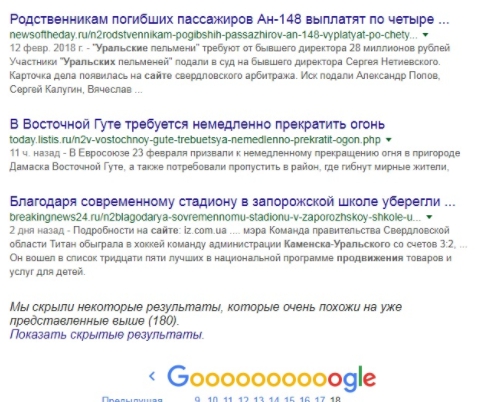

Похожие сайты, которые по мнению ПС не несут никакой ценности для пользователя, но продвигаются по введенному ключу, попадают в раздел supplementary results. Сюда же иногда размещают и молодые сайты, а также ресурсы с техническими проблемами.

Социтирование

Когда на ваш сайт ссылаются из других источников, или вы вставляете внешние ссылки – оцениваются все участники. И в таком случае под санкции тоже попадают все. Если анкор не соответствует теме статьи, или на вас сослались с некачественного ресурса – вы попадете под этот фильтр.

Слишком много ссылок

Если ссылочная масса резко увеличилась за короткий промежуток времени – значит ссылки покупные. Будет применен этот фильтр.

Слишком много страниц

Аналогично и с новыми страницами. Создавайте новый контент аккуратно и постепенно, тогда сайт не попадет под санкции.

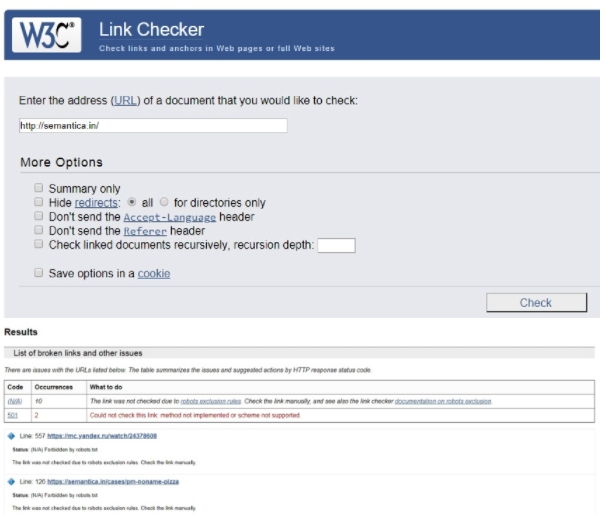

Битые ссылки

Большое число линков, ведущих «в никуда», снизит позиции в выдаче. Для проверки воспользуйтесь сервисом Link checker.

Оптимизация под мобильный трафик

Позиции снижаются для сайтов, верстка которые не оптимизирована для гаджетов. Этот фильтр обещают сделать одним из основных, поэтому рекомендуется предусмотреть мобильные версии сразу. Все остальные фильтры стали частью Панды: медленная загрузка, переоптимизация, дублированный и ворованный контент.

Как не попасть под фильтры Гугла

Полный перечень требований к сайту, который устроит поисковую систему, можно найти здесь.

В целом, общие принципы те же самые, что и у Яндекс:

- Сайт для людей.

- Хорошее юзабилити.

- Не используйте JavaScript навигацию.

- Исключите фреймы и Flash.

- Заполните мета теги.

Если вы все еще являетесь сторонником методов продвижения 10-ти и 20-тилетней давности, пора переориентироваться. Не используйте черное СЕО и искусственные методы. Больше работайте с контентом и следите за состоянием сайта.

Вывод из-под фильтра Google

Признаками попадание под фильтр являются резкое снижение количества посетителей и падение позиций выдачи. В некоторых случаях Гугл предупреждает о наложении санкций письмом.

Для отдельных фильтров используются свои подходы. Например, избавьтесь от неработающих ссылок и уменьшите число покупных. На время, пока работаете со ссылками, воспользуйтесь инструментов отклонения ссылок Google. В нем вы можете указать перечень линков, которые не следует учитывать при индексации. Это не значит, что на этом можно успокоиться – ссылки из списка все равно надо постепенно удалить.

Исправьте контент, если он переоптимизирован по ключам. Не манипулируйте выдачей, используя сервисы накрутки и линкаторы. Избавьтесь от чужого контента или ставьте ссылку на первоисточник. Закройте от индексации дублируемые страницы.

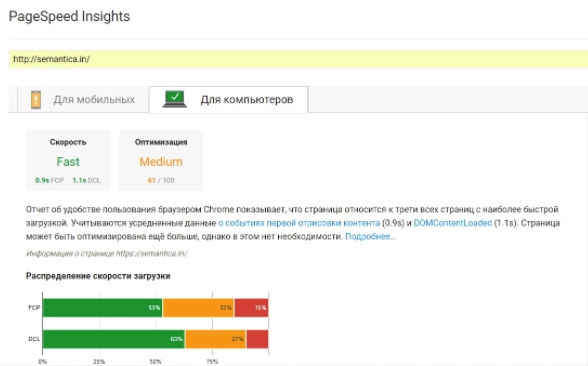

Проверьте скорость загрузки сайта на сервисе PageSpeed Insights.

Очень трудно понять, под какой именно фильтр попал сайт, поэтому придется проводить комплексную работу.

Инструменты, которые помогут

Прежде всего создайте аккаунт и подключите свой сайт ко всем сервисам поисковых систем:

- Google Analytics;

- Google Search Console;

- Яндекс.Метрика;

- Яндекс Вебмастер.

Они помогут вам отслеживать все изменения, связанные с посещением, поведением пользователей, узнать статус индексирования и многое другое.

Воспользуйтесь сервисом Fruition, чтоб проверить не попал ли сайт под фильтры Гугл.

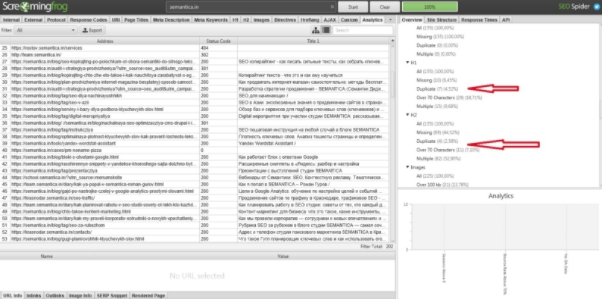

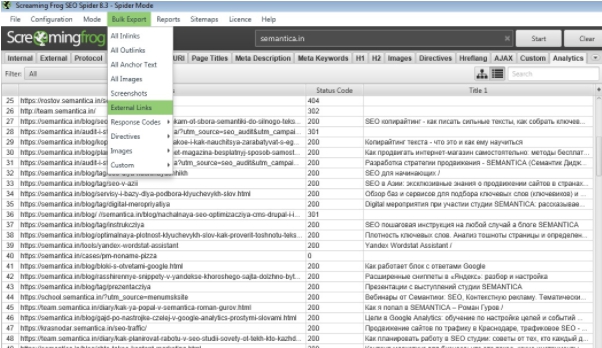

Для анализа мета-тегов и поиска дублирующихся страниц скачайте приложение SEO Spider Tool.

Повторяющиеся заголовки и Title могут означать наличие дублей.

Здесь же можно проанализировать ссылки.

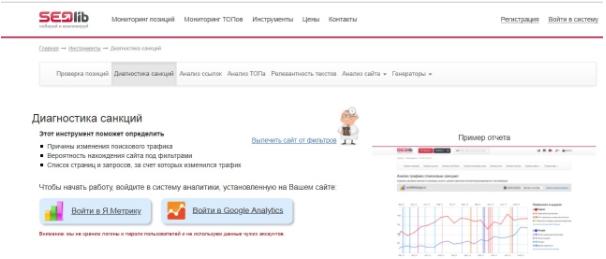

Сервис Seolib поможет проанализировать изменение трафика после обновлений алгоритмов обеих поисковых систем.

В среде оптимизаторов часто можно услышать жалобы на коммерциализацию поисковых систем. Многие считают, что развитие алгоритмов и фильтры ПС предназначены для одной цели – усложнить продвижение настолько, что без покупки рекламы обойтись становится невозможно.

Главная задача ПС – поиск наиболее подходящих результатов. Они точно также борются за своих посетителей, как и веб-разработчики. И заинтересованы в усовершенствовании методов поиска.