В одном из прошлых постов на Moz мы говорили, что в течение нескольких минут после повторного попадания статьи в индекс, может увеличиться органический трафик.

- Как все работает

- Шаг 1. Находим первичные ключи

- Шаг 2. Фильтруем ключи по частотности

- Шаг 3. Фильтруем запросы по сложности

- Шаг 4. Фильтрация для блоговых статей (опционально)

- Шаг 5. Выбираем релевантные ключи

- Шаг 6. «Каннибализации здесь не место»

- Шаг 7. Обновляем и отправляем на переиндексирование

- Шаг 8. Смотрим на результат

- Заключение

Почему это происходит? Вероятно, из-за сочетания нескольких факторов:

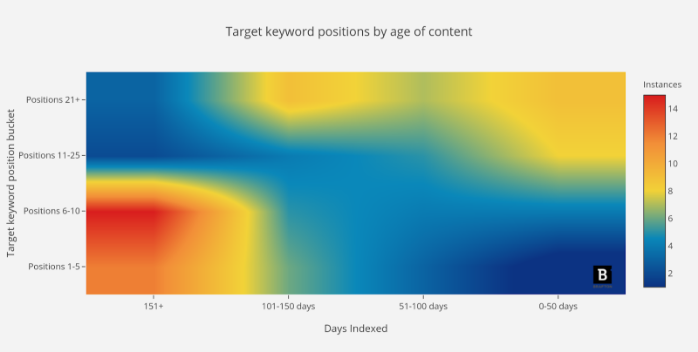

- Возраст. В предыдущем исследовании мы наблюдали связь между временем нахождения страницы в индексе и эффективностью ключевого слова / URL (при отсутствии обратных ссылок).

- Полнота контента. Предположительно, при повторной оптимизации контента вы добавляете глубину раскрытия темы, а также контекстную широту. На данны й момент Google понимает, когда контент полностью покрывает тематический кластер.

- Ценность. Если оптимизировать и без того ценный контент, его выгоды для сайта будут увеличиваться кратно.

В этом руководстве я расскажу, как найти тот контент, который нужно переоптимизировать, чтобы увеличить его эффект.

Как все работает

Сайт Brafton — площадка, для нашей маркетинговой команды, где мы пробуем и обкатываем новые решения. Это имеет смысл: если что-то идет не так, мы не тратим клиентские деньги.

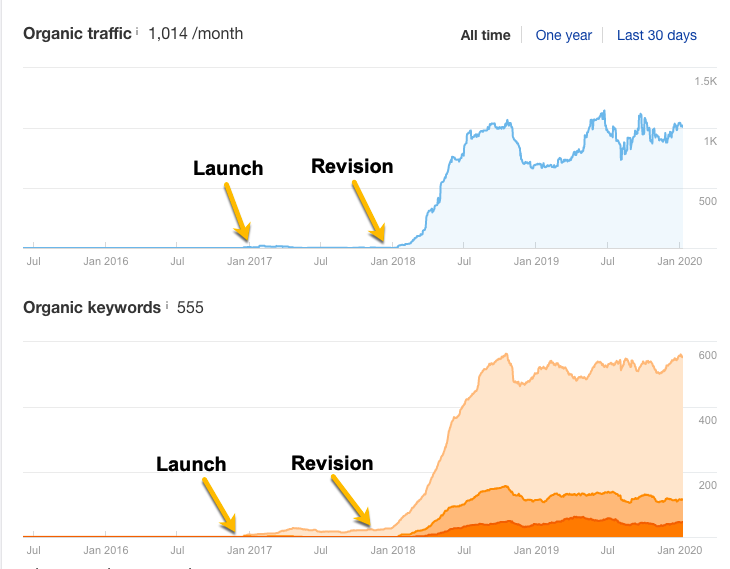

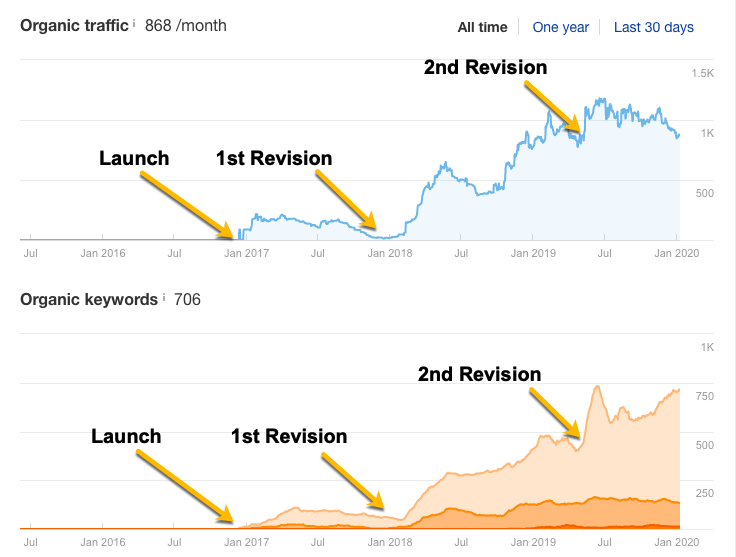

Именно на нем мы применили стратегию переоптимизации контента, о которой я буду рассказывать. Она приносит непосредственно выгоду. Вот одна из статей, которую мы повторно оптимизировали. Посмотрите на трафик из поиска:

Вот еще пример:

Во многих случаях повторная оптимизация контента — это не случай «сделал и забыл». Мы часто сталкиваемся с ситуациями, когда это превращается в гонку вооружений. Мы оптимизируем статью, но она теряет рейтинг через некоторое время в ПС. Приходится делать еще одну итерацию. На второй картинке изображен как раз такой случай.

Шаг 1. Находим первичные ключи

Если контент не присутствует в выдаче по целевому ключу, от него нет смысла.

Нам нужно выяснить, какие ключи нужны для вывода уже существующей статьи в топ. Т. е. мы ищем худшие ключи. Но чтобы не брать запросы с совсем низкой частотностью, установим ограничение на их рейтинг в выдаче.

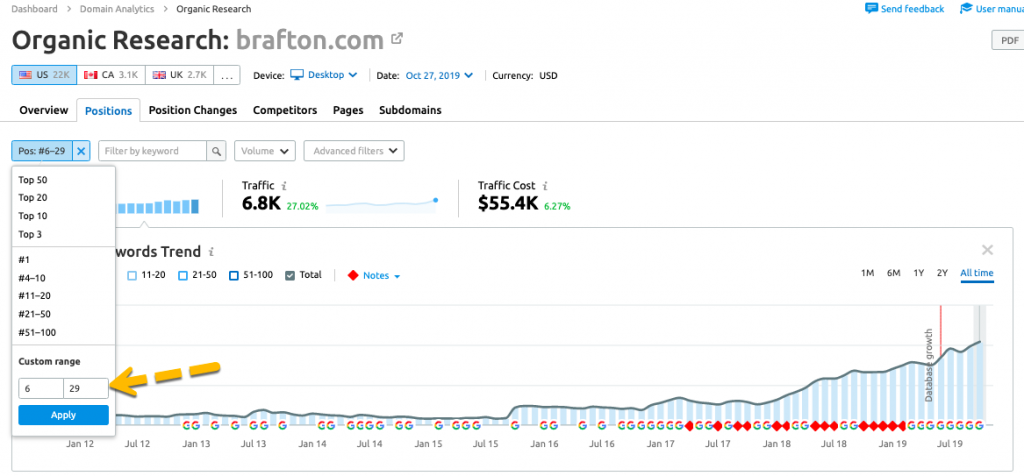

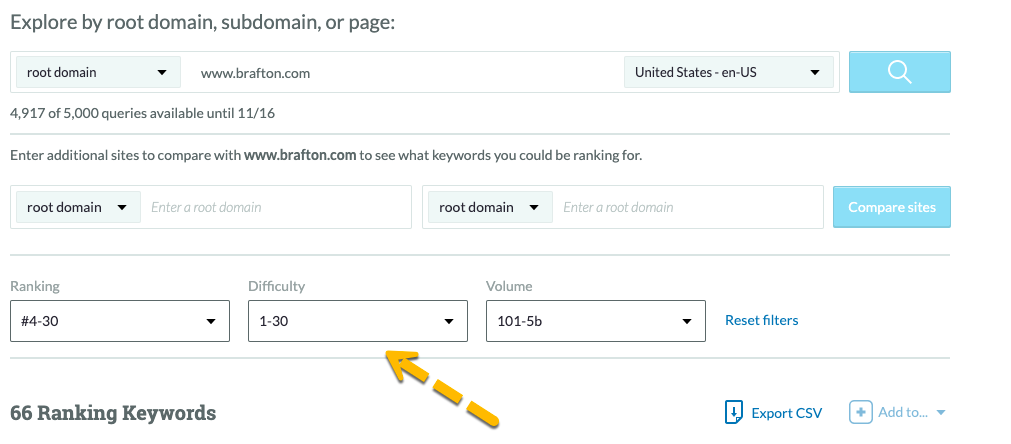

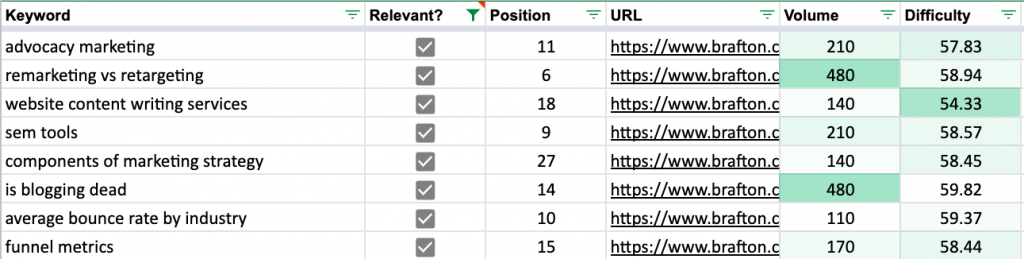

Таким образом, мы отсекаем ключи с 11 страницы выдачи, например. Так, для нашего тестового ресурса такой порог — от 6 до 29 позиции на SERP.

Для этой операции подходит любой SEO-инструмент. Просто выгрузите список всех запросов своего сайта, отфильтруйте таким образом, чтобы видеть интересующие позиции (в нашем примере — от 6 до 29).

Вот как это может выглядеть:

Шаг 2. Фильтруем ключи по частотности

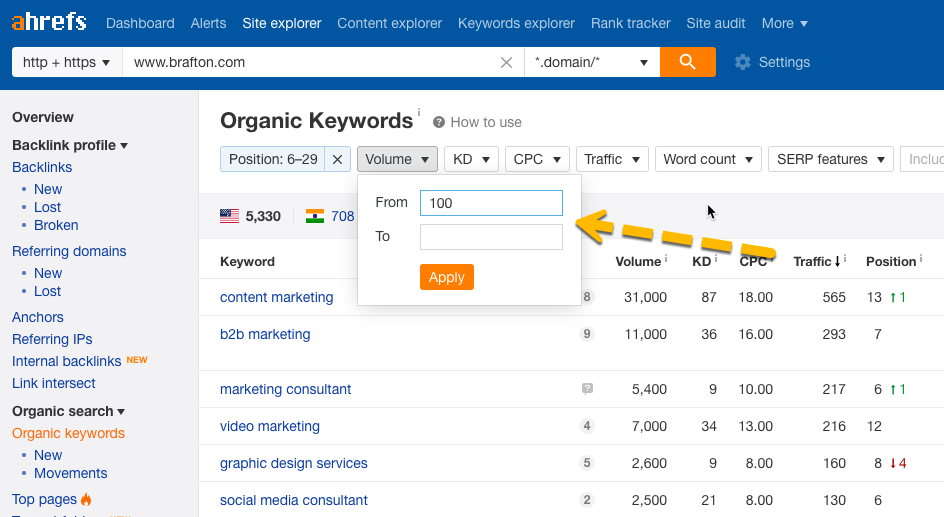

Нет смысла оптимизировать контент под запрос с нулевой частотностью. Нам нужны только частотные запросы, которые указывают на вероятность успеха.

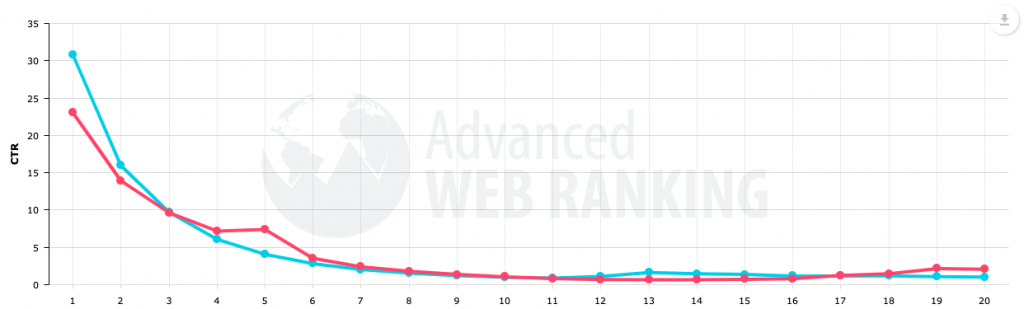

Я беру ключи с минимальной частотностью 100. Я выбрал именно такое значение, потому что в лучшем случае (при достижении первой позиции) я получу ~31 визит по этому запросу при условии отсутствия расширенного сниппета. В конце концов, написание статей стоит денег, и мне нужно оправдать эти вложения в контент.

Теперь у нас есть в списке только ключи с достаточной частотностью. Их уже можно использовать для переоптимизации.

Шаг 3. Фильтруем запросы по сложности

Лучший вариант, когда вы возьмете в работу высокочастотные ключи с низкой конкурентностью. Я всегда ищу быстрые варианты побед с наименьшими затратами.

Однако, сделаю отступление. Если вы у вас на предыдущем шаге в список попали высококонкурентные запросы, которые вы ну уж очень хотите использовать, вам придется дополнить стратегию весьма агрессивным линкбилдингом. Также можно превратить страницу в «столп контента».

Как установить границы по частотности и конкурентности

Сложность в том, что у разных инструментов — свои алгоритмы подсчета конкурентности — или «сложности» — запросов. И в разных сервисах отличаются параметры того или иного ключевого слова.Но вот несколько рекомендаций, которые помогут вам разобраться. Подойдут в случае доменов с рейтингом от 30 до 55.

В качестве примера возьму Moz Keyword Explorer. У инструмента есть предопределенные диапазоны, поэтому точных лимитов мы не достигнем, но будем достаточно близки к ним.

Итак, на этом шаге в нашем списке должны остаться только ключевые слова с достаточной частотностью и разумными показателями конкурентности.

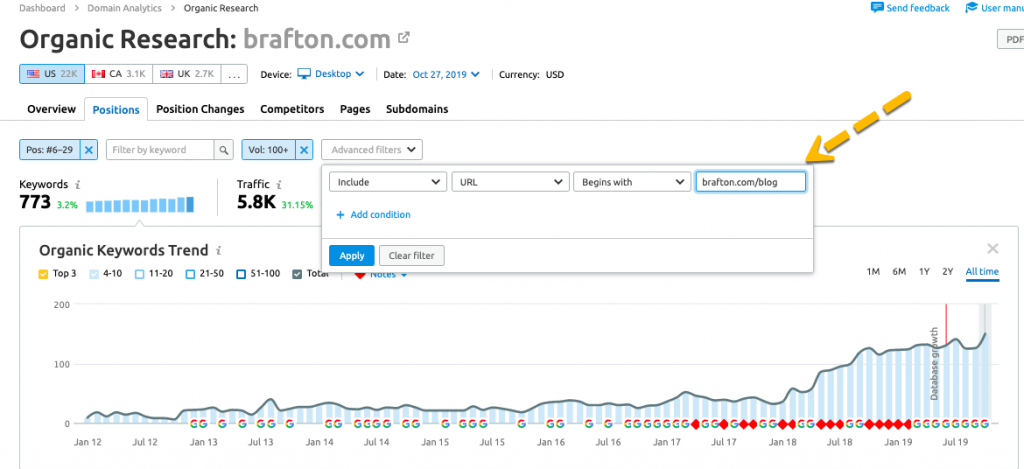

Шаг 4. Фильтрация для блоговых статей (опционально)

По своему опыту скажу: обычно блоги растут быстрее, чем посадочные страницы. Хотя описываемый мною процесс можно применять для любого типа страниц, я хочу рассказать именно про информационный контент.

Если сайт подчиняется определенной структуре, статьи на нем находятся в подкаталоге “/blog”. Это позволяет легко сегментировать запросы.

Получим список запросов, которые подойдут для оптимизации информационного раздела сайта.

Шаг 5. Выбираем релевантные ключи

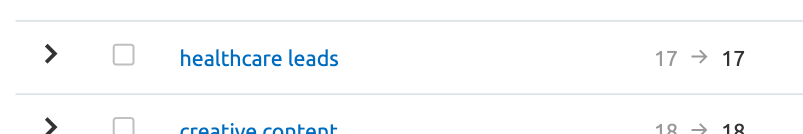

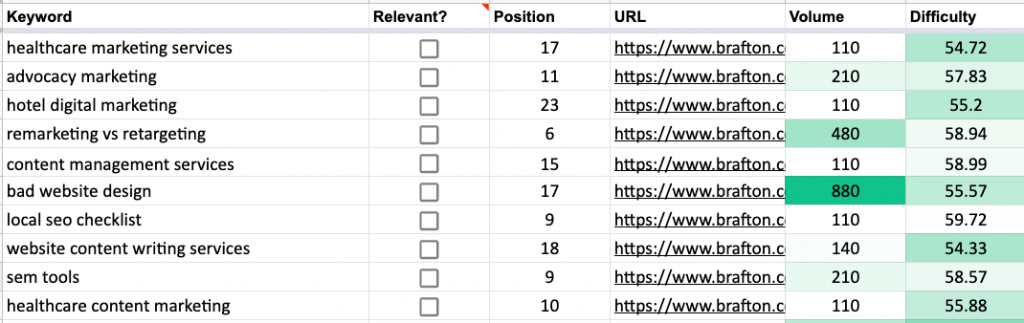

Важный вопрос, который также нужно решить перед началом переоптимизации контента — определение релевантности запросов. Каждый сайт ранжируется по релевантным ключам, а вместе с ними — и по некоторым нерелевантным запросам. Вот пример:

Я рекомендую экспортировать список в таблицу, чтобы сразу сортировать запросы.

Просто оцените список и решите, что нужно, а что — пустая трата времени.

Теперь, когда у нас список релевантных ключевых слов, мы должны быть уверены в том, что каждый запрос имеет достаточную частотность и адекватную степень конкурентности, при этом подходит в качестве темы для статей в блог.

Далее — очень важный параметр, которым должны обладать запросы. К сожалению, многие специалисты забывают про каннибализацию ключевых слов.

Шаг 6. «Каннибализации здесь не место»

Специалист может забыть, что URL обычно ранжируется по нескольким ключевым словам. Если не собрать их все, вы можете повторно оптимизировать запрос с низким потенциалом и убить весь органический трафик по ценным ключам.

Некоторые инструменты дают рекомендации по изменению тех частей контента, которые не нужно трогать вообще. Поэтому перед началом работы нужно составить представление: что изменить нужно, а что лучше не трогать.

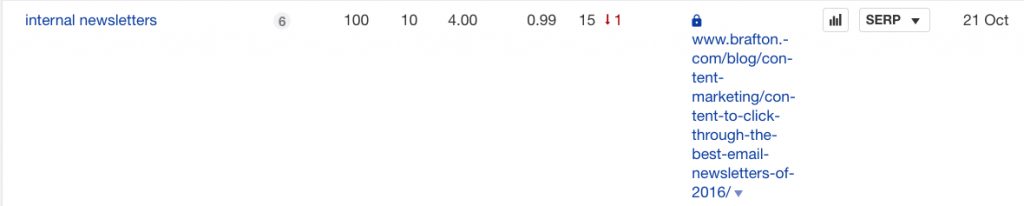

Вот пример. Страница есть в поиске, к ней идет рекомендация улучшить часть контента для запроса “internal newsletter”.

Вроде рекомендация выглядит адекватной. Но давайте проверим, нанесем ли мы ущерб повторной оптимизацией под этот запрос.

Конечно, мы занимаем первую позицию по этому запросу. При этом, прогнозируемый месячный трафик — от 501 до 850 в месяц. Я вообще не хочу этот ключ трогать.

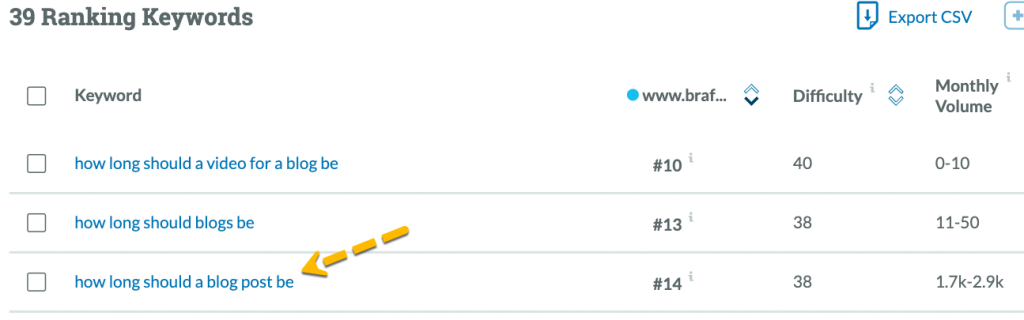

С другой стороны, этот же инструмент рекомендовал мне повторно оптимизировать статью “How long should a blog post be”. Я зашел в инструментарий Moz, и увидел, что в этом случае повторная оптимизация нужна.

Поэтому проверяйте все собранные запросы заранее, а только потом отдавайте в работу именно те ключи, ситуацию с которыми действительно нужно улучшить.

Шаг 7. Обновляем и отправляем на переиндексирование

У вас больше шансов на ранжирование по целевому ключу, если вы увеличите широту и глубину того раздела контента, к которому запрос относится. Есть много инструментов, которые решают эту задачу.

В Brafton мы используем MarketMuse, Ryte и Clearscope.

Что делать по шагам:

- Обновите контент в вашей CMS.

- При этом сохраните исходный URL, иначе вся работа пойдет насмарку.

- Обновите дату публикации. Теперь это новый контент, который нужно переиндексировать. Можно воспользоваться ODF.

- Отправить запрос в Google на переиндексацию, чтобы не ждать естественного обхода.

Шаг 8. Смотрим на результат

Приятно опережать конкурентов в выдаче, не правда ли?

Обычно я смотрю на эффективность проделанной работы несколькими способами:

- Количество посещений страницы в Search Console — ведущий индикатор..

- Инструмент мониторинга ключевых слов на странице — смотрите за состоянием переоптимизированных ключей в панели мониторинга позиций.

- Мультивариантность ключевых слов. Если добавите контента глубину, есть хороший шанс ранжироваться по большому количеству вариантов одного запроса.

Заключение

Повторная оптимизация контента — одна из тактик, которая поможет получить больше органического трафика. Если вы сделаете все согласно алгоритму и отсечете ненужные запросы для переоптимизации, вы точно увидите рост посещаемости повторно оптимизированных страниц.

Вот алгоритм:

- Собрать первоначальную семантику, по которой вы продвигаетесь, но пока не вышли в топ.

- Отсечь ключи с низкой частотностью, которая вам не подходит.

- Убрать ключи с высокой конкурентностью.

- Можно выделить только информационные запросы, если оптимизируете только старые статьи.

- Взять только релевантные запросы.

- Проверить, стоит ли брать запросы в работу: не случится ли так, что вы только нанесете вред трафику (если страница уже находится в топе по какому-либо другому запросу, например).

- Обновить контент, отправить запрос на его переиндексацию.

- Отследить результат.