Вы просыпаетесь утром и видите, что трафик на сайт упал. В консоли — куча красных предупреждений. Все просто: ночью произошло обновление поискового алгоритма, и теперь сайт не удовлетворяет критериям.

К сожалению, если такое происходит, вы не сможете быстро все поправить и вернуть, как было. Лучшее, что можно сделать — подготовиться к следующему обновлению.

Даже если ваш сайт никогда не попадал под санкции, лучше подготовиться заранее. Будьте на шаг впереди. Как это сделать, я расскажу на примере одного из проектов моего агентства.

- Вызов: пережить “медицинский апдейт”

- Вопрос: санкции от алгоритма или понижение сайта?

- Пациент: о сайте нашего клиента

- Как восстанавливали сайт

- Восстановление, оптимизация и внедрение

- Результат: последствия апдейта ликвидированы

Вызов: пережить “медицинский апдейт”

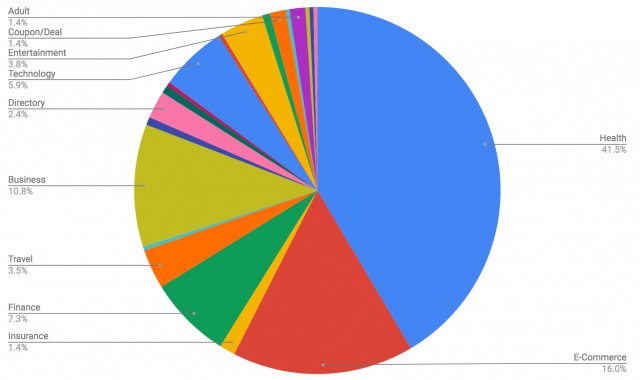

1 августа 2018 года произошло большое обновление, которое оптимизаторы назвали “медицинским апдейтом”. Оно затронуло много сайтов, связанных со здоровьем и медициной.

Начнем с нескольких фактов.

#1. Google постоянно проводит поисковые эксперименты

Цитата: “В 2018 году мы провели более 654 680 экспериментов, в которых участвовали асессоры. В результате мы внесли 3234 улучшения в алгоритм ранжирования”.

Еще цифры:

- 595 429 тестов на качество поиска. Некоторые из них имели концептуальный характер, но алгоритмически оказались неэффективными, поэтому не прошли на следующие этапы тестирования.

- 44 155 совмещенных экспериментов. Это эксперименты внутри компании. Команда оценки качества поиска одновременно просматривает выдачу для старого и нового алгоритма. Основная задача — оценить качество изменения алгоритма. Некоторые варианты отсеиваются, остальные переходят на следующий этап.

- 15 096 экспериментов с трафиком. Google выкатывает изменения и начинает оценивать, как аудитория на них реагирует. Опять же, некоторые изменения отсеиваются, как непригодные.

- 3 234 релизов. Финальная стадия, когда все прошедшие тестирование изменения алгоритма реализуются в алгоритме ранжирования.

#2. Алгоритм получает улучшения каждый день, а несколько раз в год обновляет свое ядро

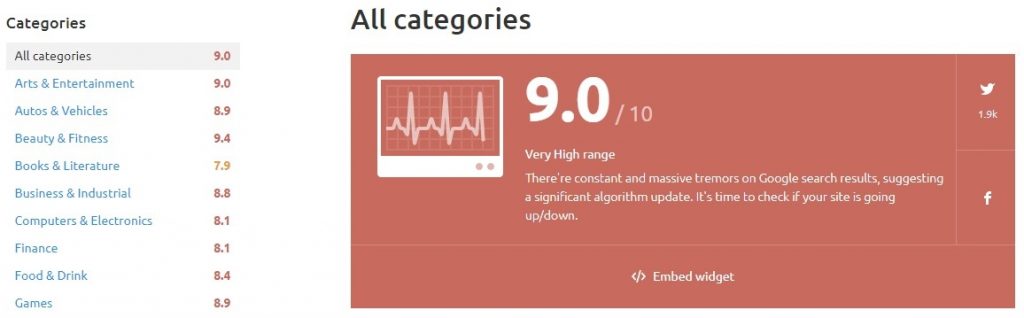

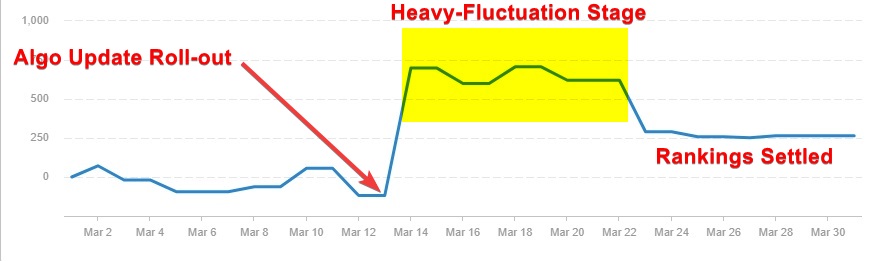

Нехитрая математика нам подсказывает: если в год алгоритм получает 3 234 улучшения, то в день их случается примерно 8. Если вы подозреваете, что что-то происходит, всегда можно посмотреть, что творится в выдаче:

В течение этого времени выдачу штормит, но в конечном итоге все выглядит так:

Я считаю, что на этапе сильного шторма Google вносит коррективы в только что внесенные изменения алгоритма.

#3. Вначале — шум, потом — результат

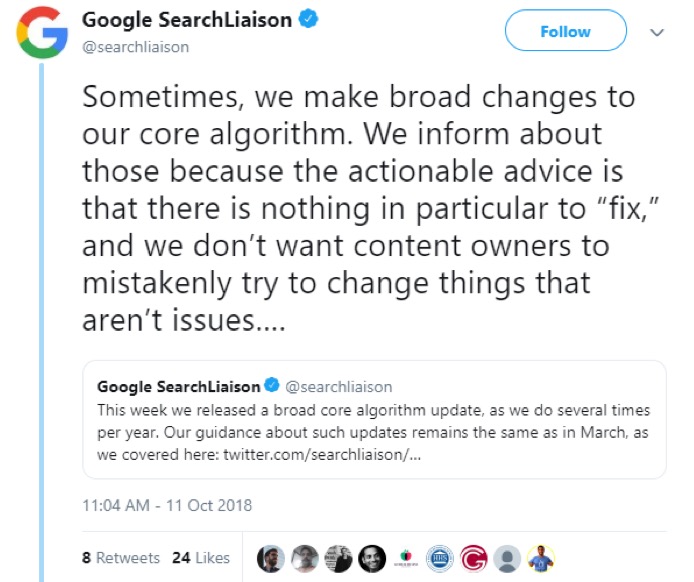

Как только система обновляет алгоритм (особенно после официального подтверждения), вокруг появляются сообщения, что же именно теперь изменилось. Но давайте не будем лезть поперек батьки.

У нас, как у владельцев сайтов, есть сильная сторона: нас много, мы в тельняшках. Мы получаем много данных друг от друга, и почти всегда в точности понимаем, какие изменения нужно внести на сайт, чтобы он вновь хорошо ранжировался.

Здесь старайтесь отличить зерна от плевел. Следите за тем, кто о чем пишет. Найдите, кому довериться. Вокруг крайне много людей, которые просто хотят похвастаться.

Вопрос: санкции от алгоритма или понижение сайта?

Если после обновления алгоритма у вас дела идут плохо, обычно все говорит о санкциях. Я не согласен с такой терминологией. Предлагаю следующее:

- Санкции — это наказания, когда вы игнорируете требования и условия Google.

- Понижение сайта — сопровождает качественное обновление или широкое изменение алгоритма. Влияет на позиции сайта долгий период времени.

Так или иначе, попадание под алгоритм означает, что Google обесценил ваш сайт в поиске. Вы не одиноки, и вместе с вашим сайтом миллионы других ресурсов получили понижение.

Но вы можете извлечь выгоду даже из этой ситуации и подготовиться к следующему обновлению.

Как понять, что вы пострадали от обновления алгоритма

Обычно основной признак — снижение трафика из органики. Но вернемся к этому чуть позже.

Вообще, если трафик изо дня в день снижается, зайдите в инструменты мониторинга позиций, а еще почитайте группы оптимизаторов на Facebook.

Инструменты мониторинга:

Полезные группы на Facebook:

- The Lab (англ.)

- Ahrefs Insider (англ.)

- Inside Search (англ.)

- Новости SEO (рус.)

Пациент: о сайте нашего клиента

Клиент обратился к нам после релиза медицинского апдейта в конце октября. Имел место апдейт, и на тот момент никто не был уверен в его специфике.

У клиента был авторитетный сайт. В индексе более 700 страниц. Ниша — здоровье, питание, диеты и добавки для похудения.

Симптомы

Индустрия все еще горячо обсуждала алгоритм, быстрых решений не было. Поэтому вот единственное, что у нас было:

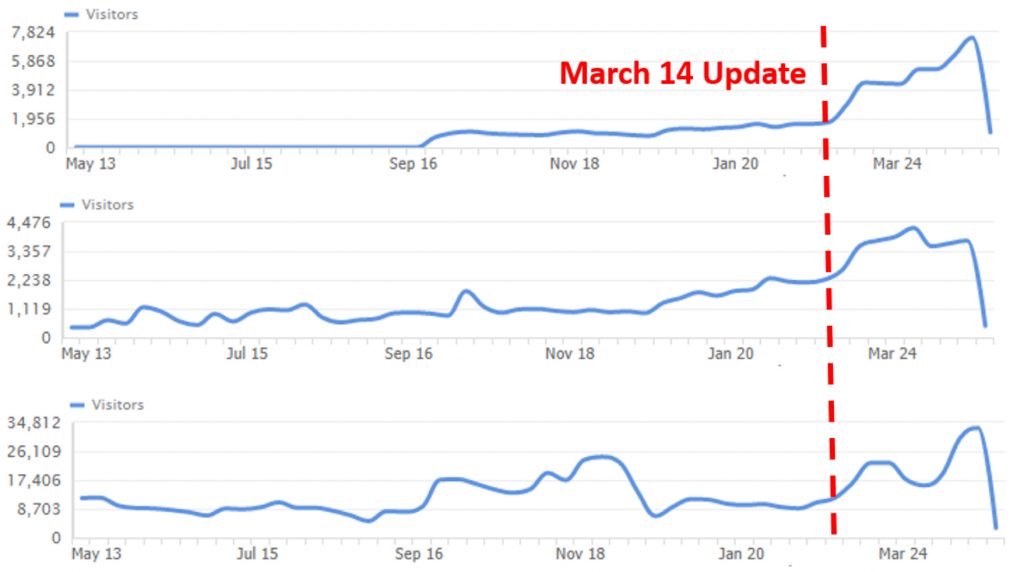

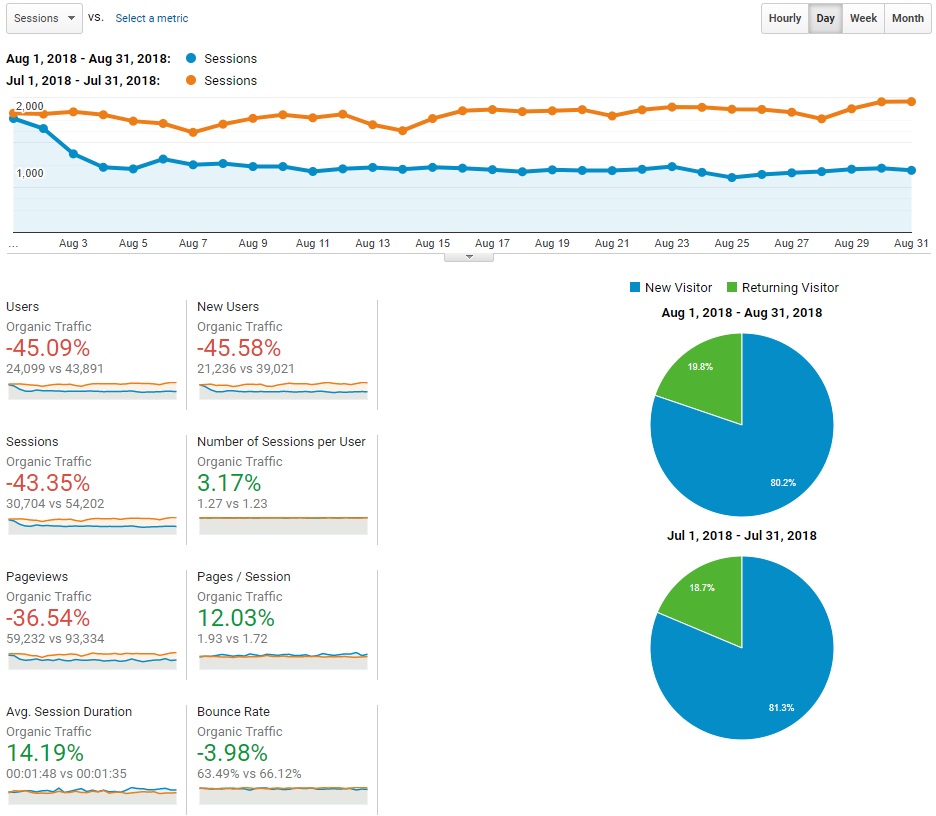

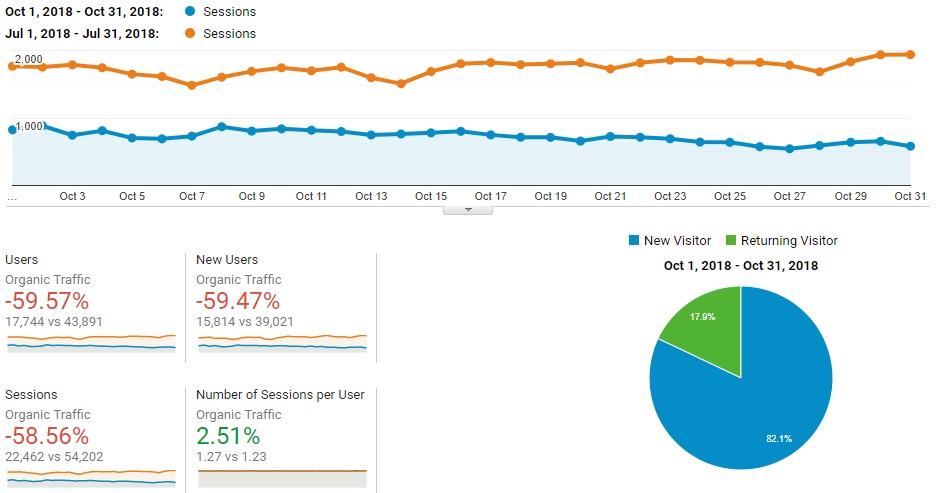

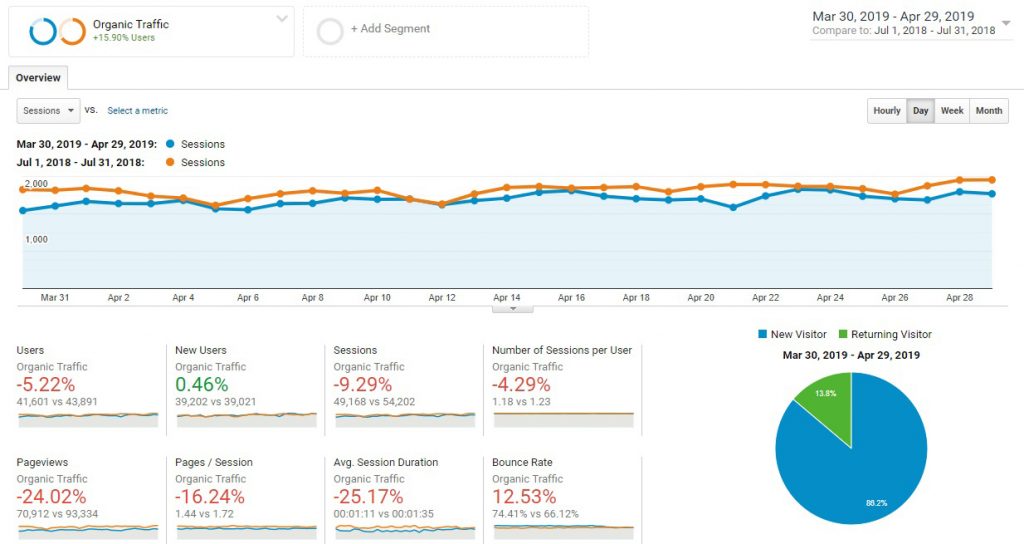

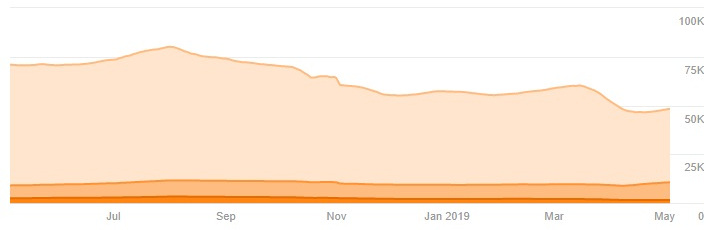

В июле-августе сайт потерял 45% трафика. Т. е. половина пользователей ушла за неделю. В октябре все стало еще хуже:

У нас: медицинская тематика, ухудшение с середины лета. Вывод: медицинский апдейт.

Кратко о том, что знали тогда и что знаем сейчас.

Тогда:

- Думали, что все пониженные сайты были в медицинской тематике.

- Серьезно снизился рейтинг ресурсов.

- Рейтинг затронул первую страницу выдачи.

- Понижение получили даже авторитетные сайты. Мы предположили, что в Google просто ошиблись.

Сейчас:

- Обновление затронуло разные тематики.

- Особенно сильно влияние ощутили сайты медицинской тематики с неподобающей авторитетность. и сигналами доверия.

- Некоторые считают это изменение преднамеренным шагом, о котором Google впервые упоминал в YMYL в 2013.

- Апдейт случайно совпал с обновлением Руководства Google по оценке качества сайтов.

- Особое внимание было обращено на контент, в частности, на каннибализацию.

- Откатов не было, значит, обновление должно остаться в релизе.

Возможность быстрого восстановления

“Быстро включить” рейтинг нельзя.

Алгоритмическое понижение сайтов в выдаче основано на данных, которые система получает от сайтов. Это значит, что то, что вы делали ранее, теперь не считается ответом на поисковые запросы пользователей.

Давайте обсудим, что же теперь нужно людям.

Инструменты для проведения аудита

Вообще проведение аудита — процесс, состоящий из нескольких итераций:

- Собрать данные.

- Внести изменения.

- Понять влияние изменений.

- Собрать данные.

- Внести изменения.

- …

Специальные инструменты просто необходимы, когда у вас нет четкой проблемы. Вот подробнее, с чем мы работали.

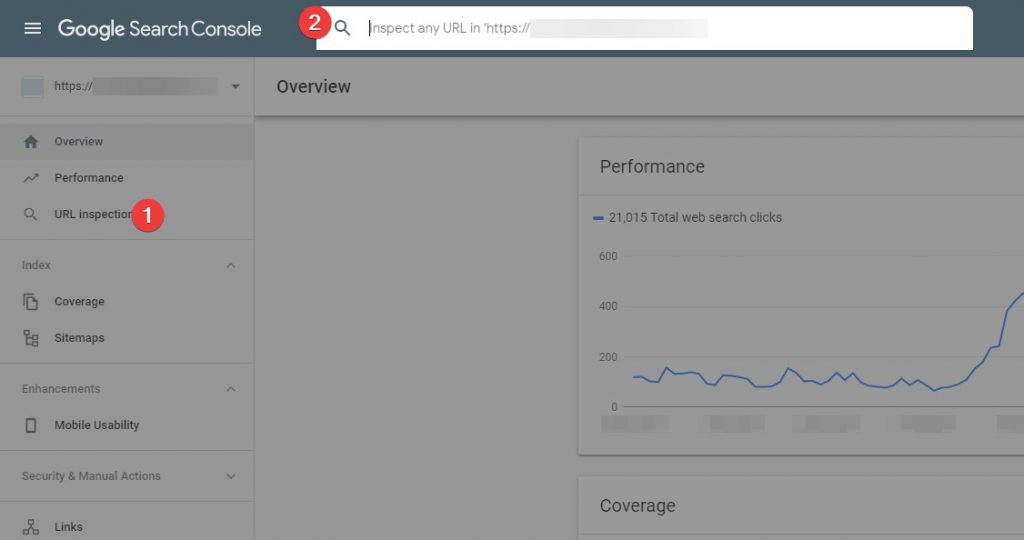

Google Search Console (куда уж без нее)

Наш лучший друг.

Вы можете одну за одной проверить все страницы и найти проблемы.

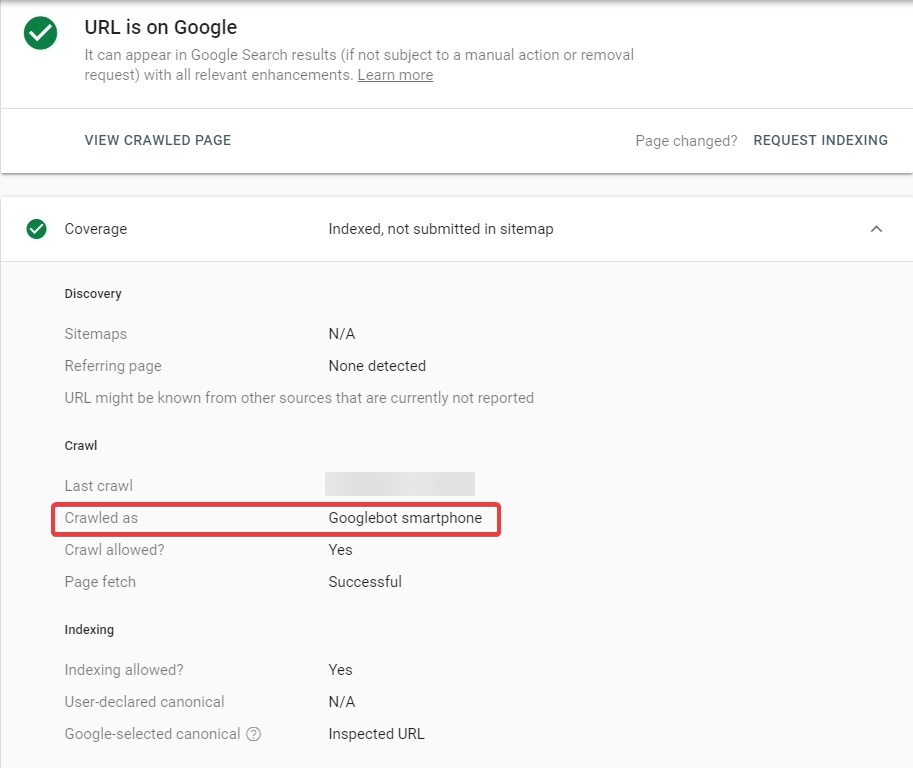

Или узнать, переведен ли сайт на мобильную индексацию.

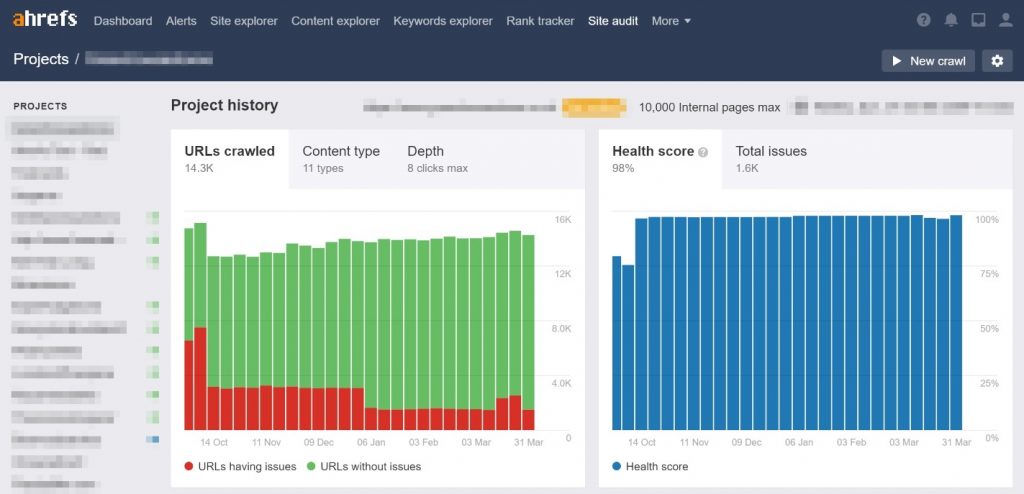

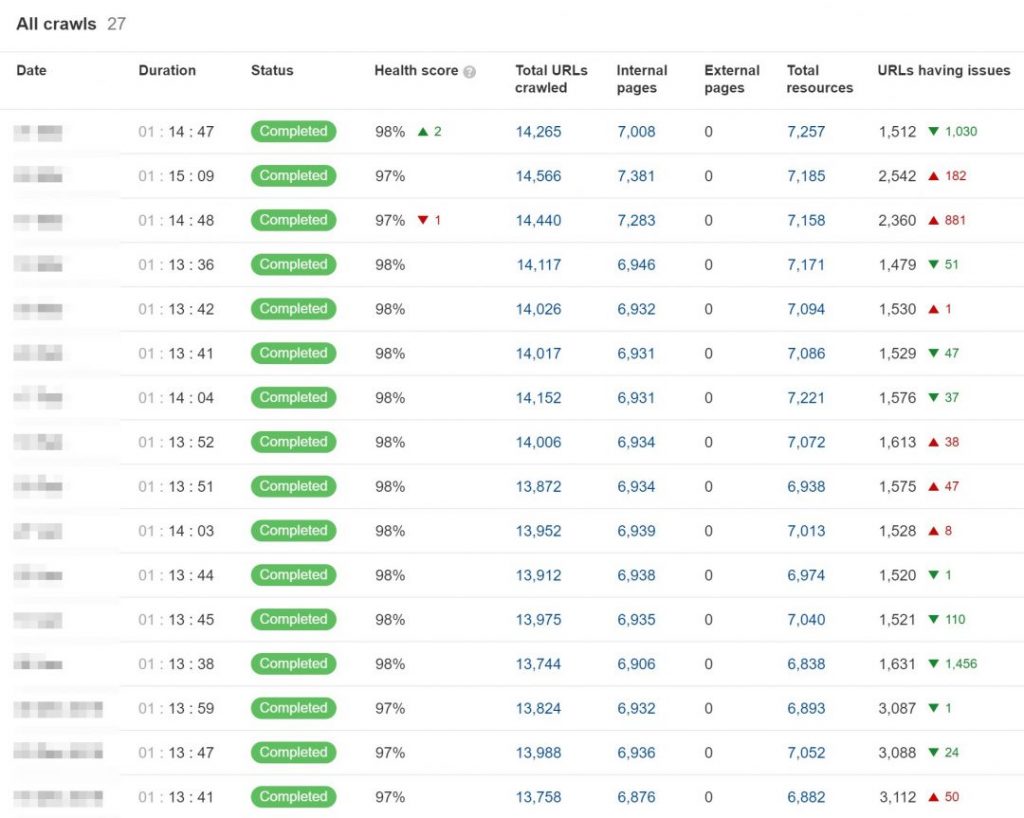

Ahrefs (The Ninja)

У ребят есть новый инструмент для аудита сайта. Основные проблемы, которые можно узнать здесь: скорость загрузки, оптимизация картинок, внутренние ошибки 4хх и 5хх, внутренние анкорные ссылки и т. д.

Вы можете поставить сканирование сайта на расписание, например, раз в неделю. Ниже — пример плановых аудитов. Для всех сайтов мы стараемся поддерживать уровень здоровья выше 95%.

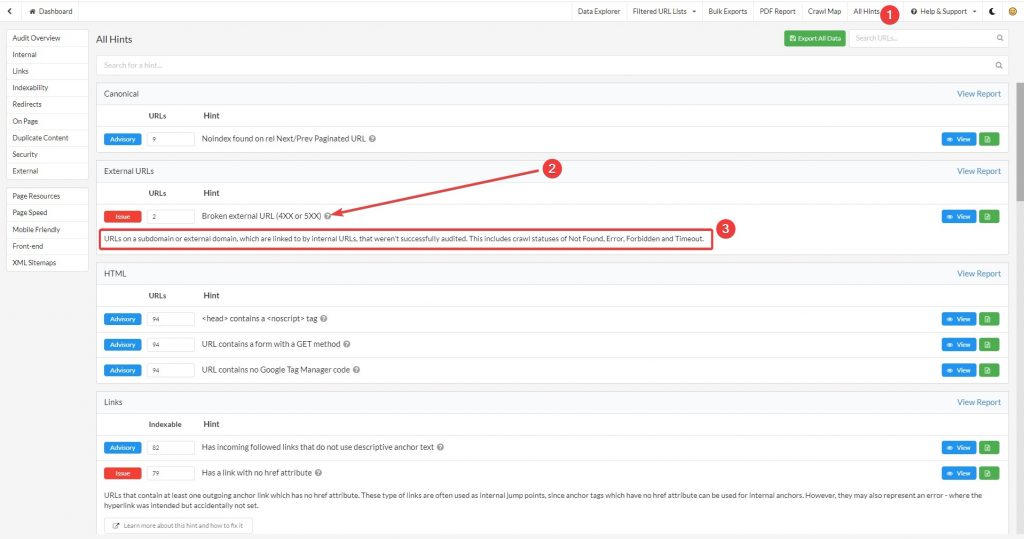

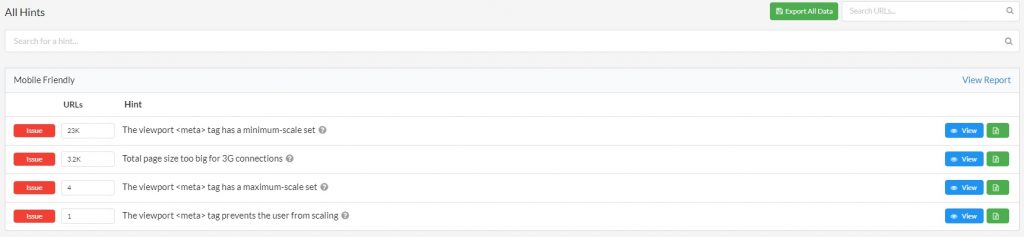

Sitebulb

Инструмент, который хорошо показывает все проблемы сайта. Что он делает:

- Проверяет дублирующиеся урлы.

- Показывает дубли контента.

- Проблемы с URL с HTTP и HTTPS.

- Показывает наличие безанкорных ссылок.

- Проверяет отсутствие ссылок на пагинацию.

- Наличие URL, для которых есть follow и nofollow ссылки.

- Ищет страницы со слишком большим размером для 3G.

- Проблемы с файлами CSS.

- Замеряет время ответа от сервера, пинг.

- Проблемы с редиректами (есть ли зацикливания).

- Смешанный контент (загрузка HTTP с адресов на HTTPS).

Эти подсказки помогут получить информацию, которая объединяет мелкие проблемы с основной. Вы исправляете сразу все, а не по отдельности.

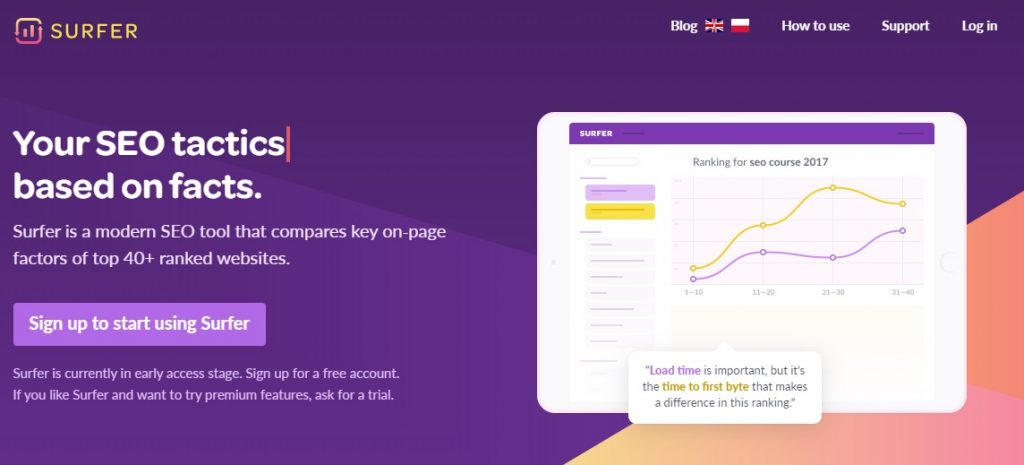

Surfer SEO

Я очень люблю этот инструмент. Вскоре вы узнаете, как его использовать для оптимизации контента.

Восстановление, оптимизация и внедрение

Контент

Мы знали, что обновление сильно затронуло именно контент. Поэтому изучили каждую страницу сайта.

Удаление лишнего

Наши исследования показали, что самая большая проблема — каннибализация контента.

Вот 10 распространенных решений, которые мы нашли после медицинского обновления:

- Упоминание персонажей, которых нелегко отследить.

- Обеспечение понятной, древовидной навигации по сайту.

- E-A-T — это не просто имя автора. Google нужны подтверждения всего, о чем вы пишете на сайте. Имени автора поста тут не достаточно.

- Не пишите о том, в чем не разбираетесь.

- Не размещайте объявления на сомнительных сайтах, а также не покупайте ссылки на помойках.

- Планируйте дальнейшие публикации.

- Избегайте каннибализации контента.

- Избавьтесь от ненужных страниц.

- Посмотрите на процесс индексации страниц сайта.

- Экономьте бюджет на обход поисковыми ботами вашего ресурса.

Имея в виду пункт про каннибализацию, мы начали проверять буквально каждую статью на сайте и заново структурировать контент. Можно сделать двумя способами.

Первый — консолидация страниц. Находите несколько страниц на одну тему и объединяете их. После этого настраиваете редирект со страницы с меньшим числом ключей на страницу с высоким.

Второй — удаление ненужного контента. Находите страницы, которые:

- получили минимум трафика за последний период;

- нет обратных ссылок;

- не нужны;

- не ранжируются по запросам, которые вам нужны;

- старше 6н месяцев (не удаляйте новый контент!);

- невозможно обновить (или нет нужды).

Страницы, которые нашли, можно спокойно удалить.

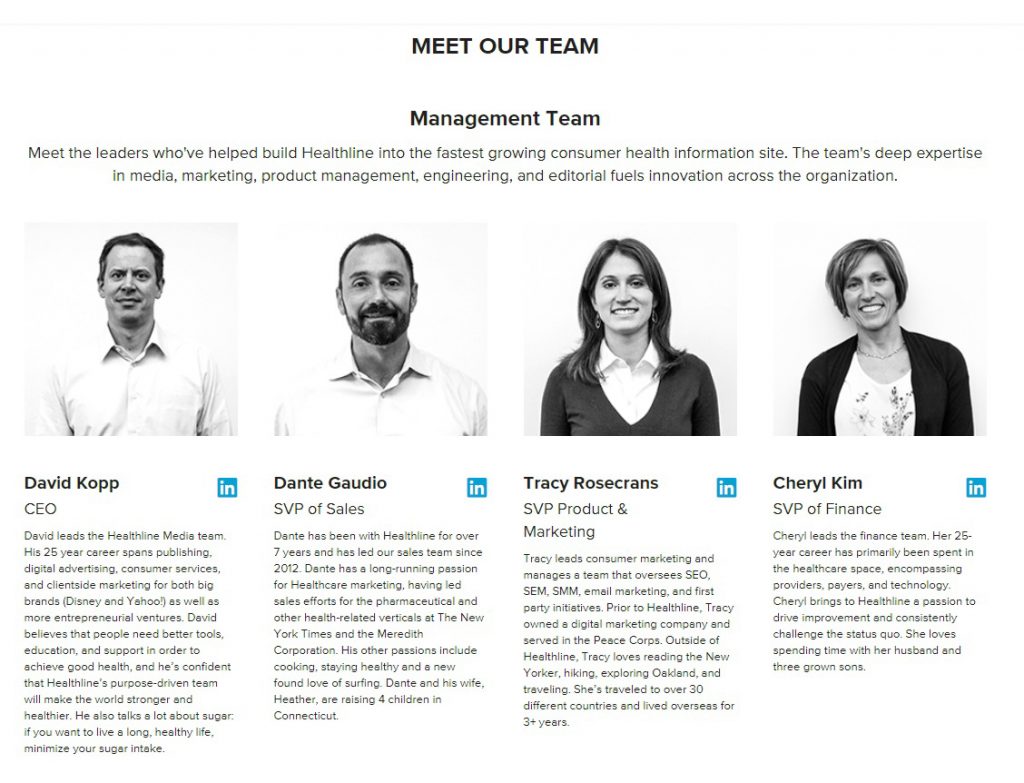

E-A-T

Вы могли слышать выражение E-A-T — Экспертиза — Авторитетность — Надежность.

Google действительно ценит уникальный, качественный контент, написанный авторитетным экспертом. Он также умеет определять авторитетность и качество наряду с другими сигналами релевантности.

Мы предполагаем, что алгоритм может воспринимать некоторые сигналы E-A-T:

- Специальная разметка для социальных сетей.

- Небольшая длина абзацев, верное форматирование.

- Нет перегруза CTA-элементами.

- Используйте личности. Создание авторитетности вокруг имени автора помогает не только ему, но и сайту в целом.

- В меню сайта добавьте пункт “О нас”.

- Сделайте страницу “О нас” так, чтобы она подтверждала вашу экспертность.

- Сделайте страницу с контактами.

- Сделайте доп. страницу с отказом от ответственности. Она связана с подвалом сайта. Упоминайте ее там, где необходимо.

- Улучшите персональные страницы авторов.

- Повышайте качество контента

Теги заголовков

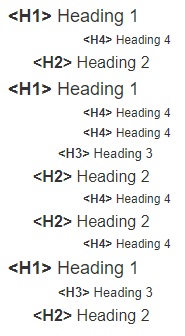

На сайте нашего клиента была проблема с заголовками — нарушена иерархия. Напомню.

Неверно:

Верно:

Также поддерживайте чистоту в коде. Это реально помогает Google понимать контент сайта, выстраивать семантическую иерархию.

Улучшение контента

Здесь, как всегда.

Ваша задача — создать что-то лучшее, что сейчас есть в топе. А значит, нужно постоянно проводить аудит, т. к. выдача на первой странице постоянно меняется.

Я выше говорил про Surfer SEO. Он помог нам провести глубокий анализ, притом весьма быстро.

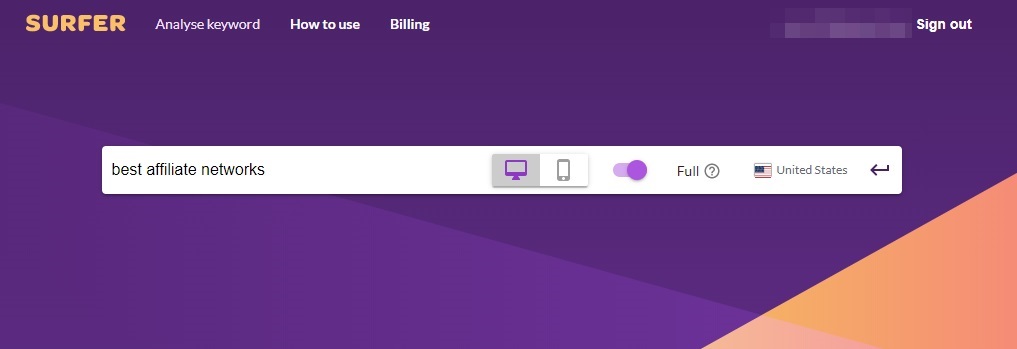

Для примера возьмем ключ “best affiliate networks” с частотность 800 запросов в месяц. Мой сайт находится по нему в топ-10, но не занимает верхних позиций.

Запустите инструмент, установите регион.

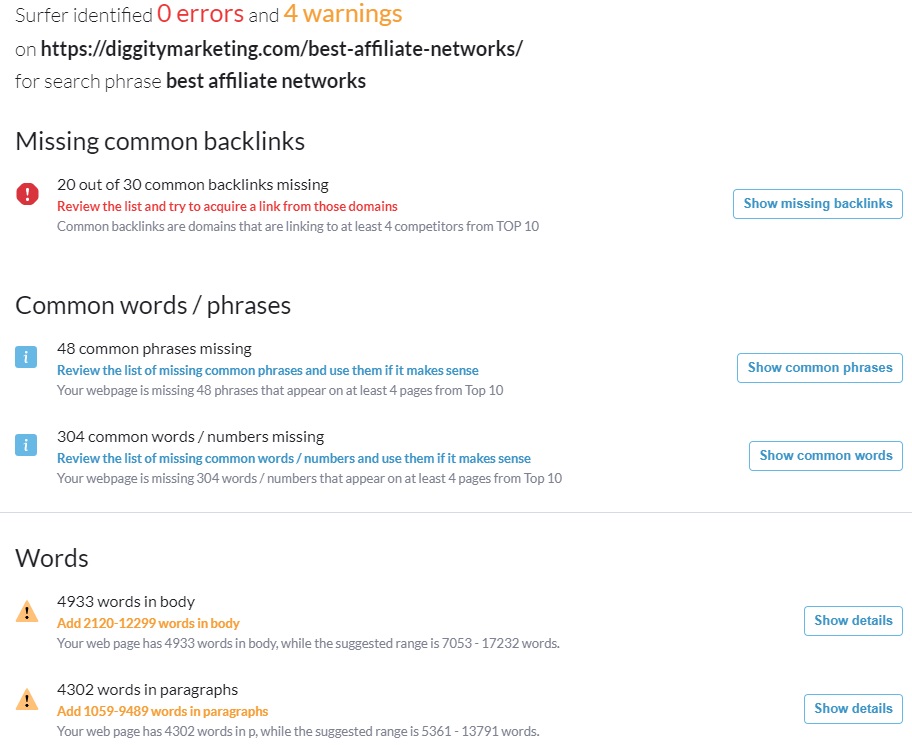

Анализ займет минуту. Вот отчет:

Что мы видим:

- Факторы ранжирования — от количества слов до числа заголовков на странице оценивается каждый фактор. Вы можете увидеть, какое значение они имеют для высоких позиций. Surfer автоматически рассчитывает корреляцию каждой метрики, высокое значение говорит о том, что этот фактор важен для ранжирования.

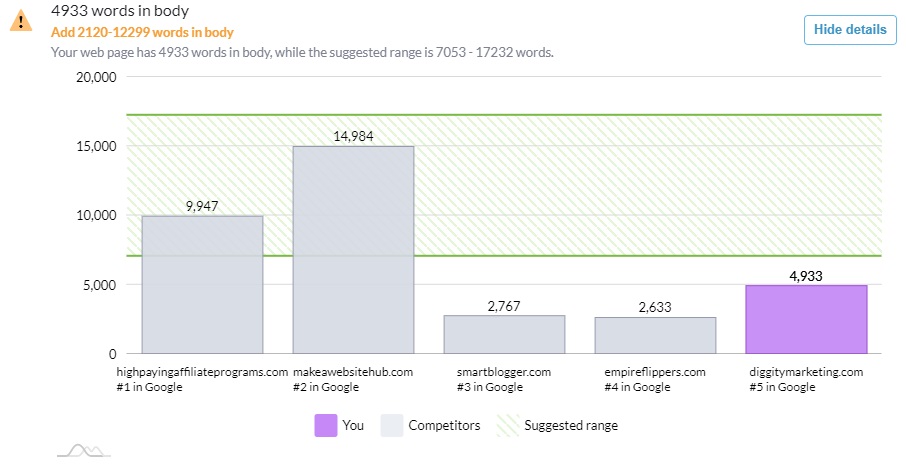

- Диаграмма для выбранной метрики — в нашем случае видим количество слов в тексте. Так, контент на первых 3 позициях содержит гораздо больше слов, чем наш.

Еще одна мощная фишка — Surfer может проверить сайт с учетом 5 конкурентов вашего ресурса. Вы увидите все факторы, по которым проигрывает каждая страница сайта.

Как выглядит отчет для страницы “Best Affiliate Networks” на моем сайте:

Посмотрим на рекомендации:

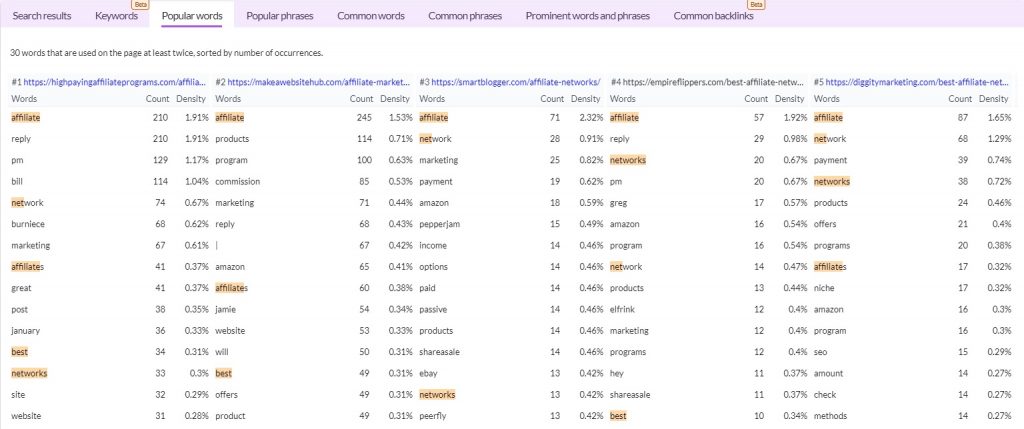

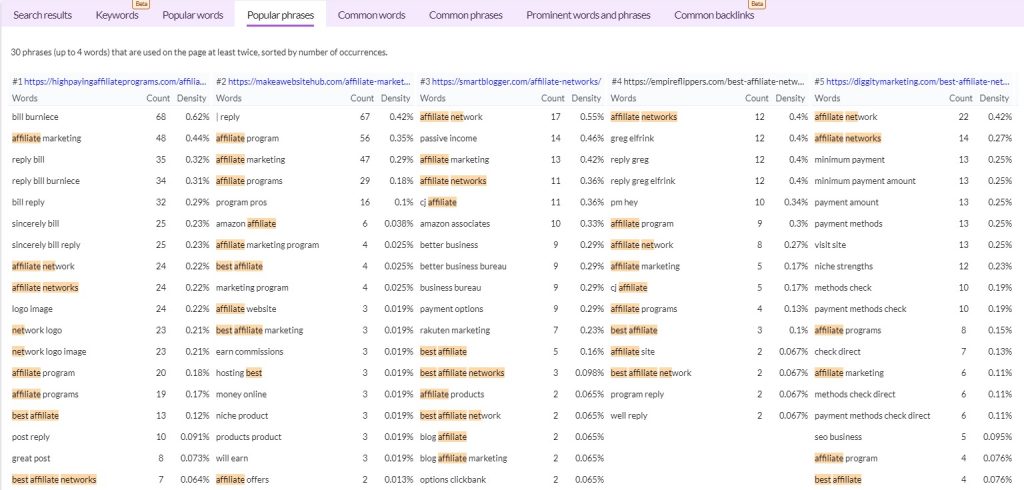

На первых двух страницах более длинные статьи. Поэтому вначале надо расширить текст на странице. А для этого нужно проверить, все ли ключевые слова я использую из тех, которые есть у конкурентов.

Видим:

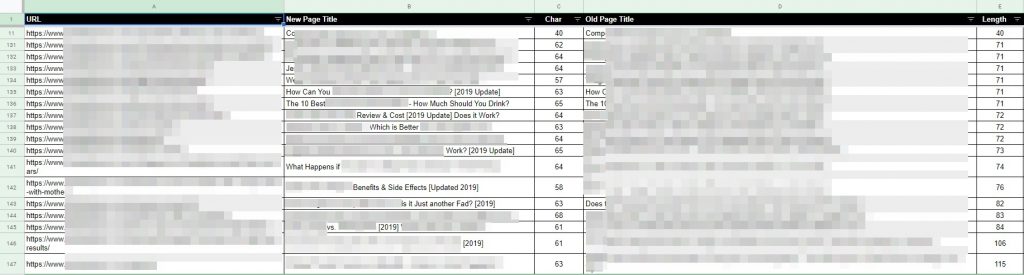

Title и Description

Оптимизируйте метатеги:

- Используйте основное ключевое слово.

- Используйте короткие и точные названия.

- Добавьте элементы, которые повышают CTR.

- Если добавляете даты, поддерживайте их актуальными.

- Не уходите в кликбейт.

- Следите за уникальностью.

- Не спамьте.

Обязательно исправьте случаи, если мета тегов нет совсем, они слишком короткие или длинные.

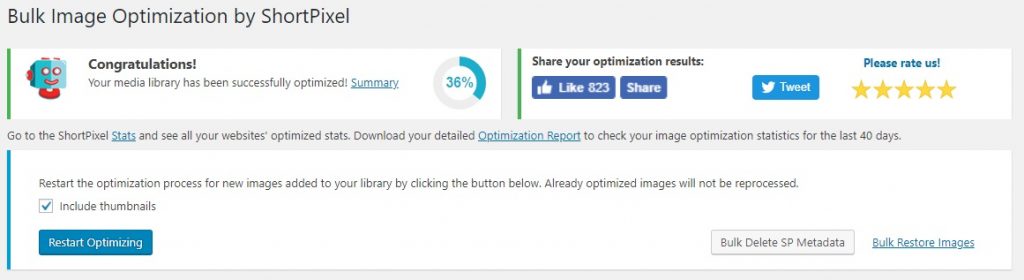

Оптимизация изображений

Все важные изображения должны быть не более 100 кбайт. Я пользуюсь инструментом ShortPixel:

Не забывайте про альтернативный текст. Он не только помогает поисковой системе понять, что показывает картинка, но и дает сигналы релевантности вашему контенту.

Мы добавили больше описательных, естественных альтернативных тегов. Убедились, что все изображения их имеют.

Оптимизация структуры сайта

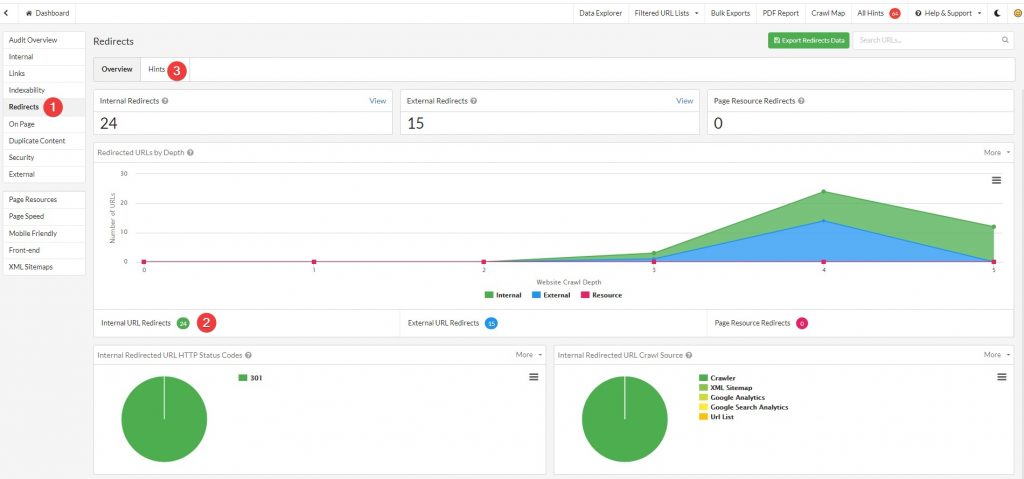

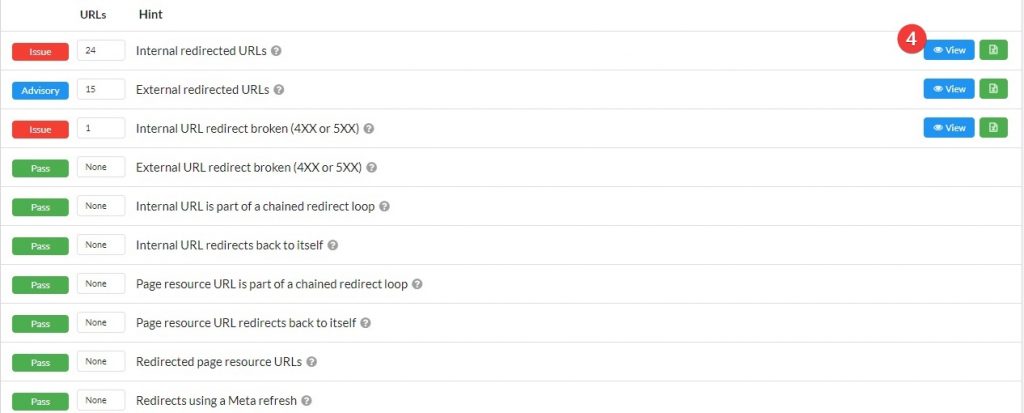

Восстановление внутренних ссылок

Мы нашли много внутренних битых ссылок. Возможно, ранее они вели на страницы с 301 редиректом (иногда по нескольку раз). Или вообще на 404ю.

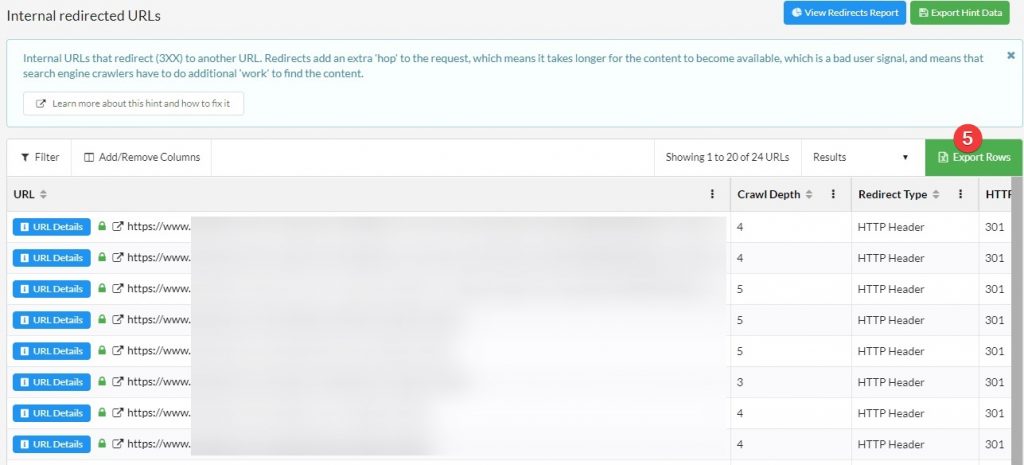

Воспользовались Sitebulb, чтобы найти все битые ссылки.

- Audit > Redirects.

- Смотрим количество внутренних редиректов.

- Открываем “Hints”.

- Видим все внутренние перенаправления.

- Экспортируем данные в эл. таблицу.

Далее исправляем все нерабочие ссылки. Обновляем их, чтобы все вели на правильные страницы.

Восстановление внешних ссылок

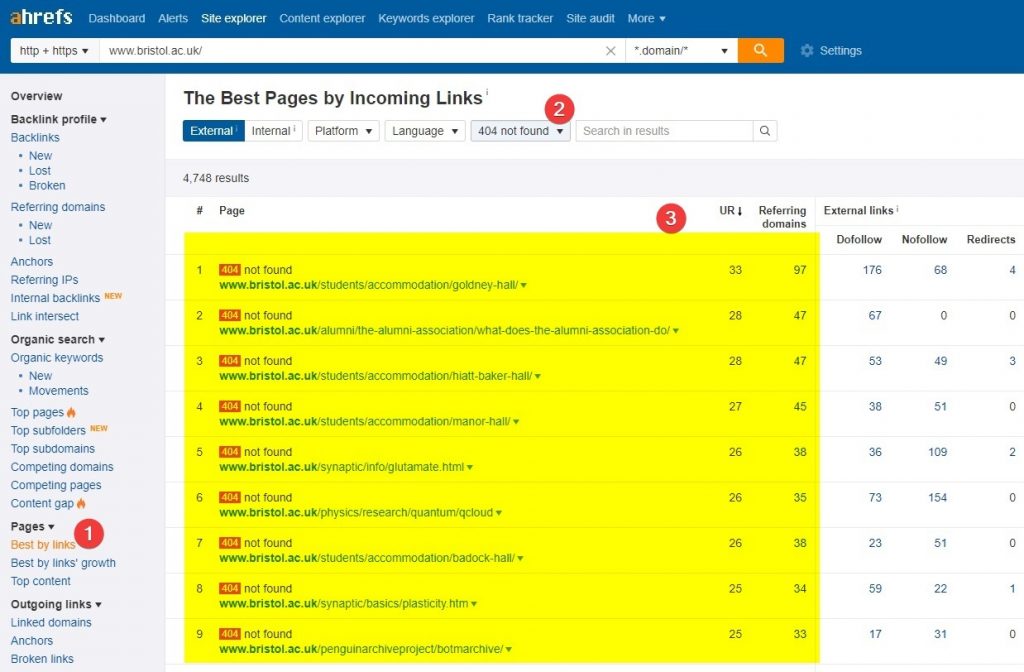

Мы нашли нерабочие URL, на которые вели естественные ссылки.

В случае страниц с кодом 404 ссылка является тупиковой. Она не передает никакой авторитетности реальным страницам. Как их найти через Ahrefs:

- Pages > Best by Links.

- Выберите нужный код ответа (в нашем случае — 404).

- Список готов.

Отсортируйте по количеству доменов, чтобы найти приоритетные:

После этого создайте карту редиректов с наиболее подходящими пунктами назначения и перенаправьте их (301), чтобы восстановить всю цепочку.

Техническое SEO

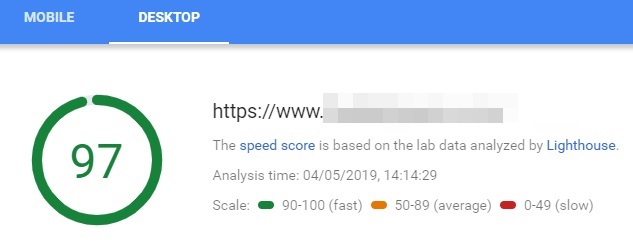

Скорость загрузки страниц

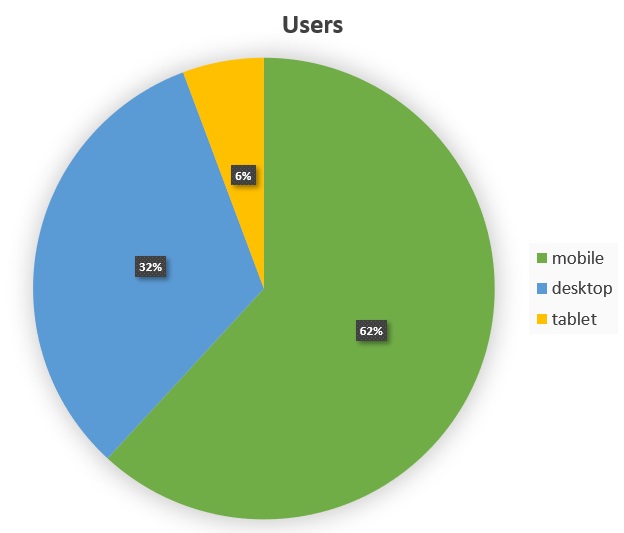

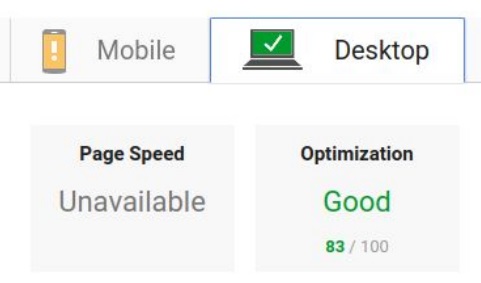

Наши источники трафика:

Понятно, что нужно делать.

Результаты до:

Результаты после:

На вопрос: “Что вы сделали?” Отвечу: “Все!”

- Уменьшили Javascript.

- Уменьшили CSS.

- Уменьшили HTML.

- Ввели отложенную загрузку картинок, видео и фреймов.

- Скомбинировали небольшие CSS и JS для экономии.

- Улучшили time-to-first-byte.

- Оптимизировали картинки.

- Ввели форматы .webp для изображений, где возможно.

- Ввели асинхронную загрузку внешних ресурсов.

- Статический HTML кэш.

- Ввели CDN.

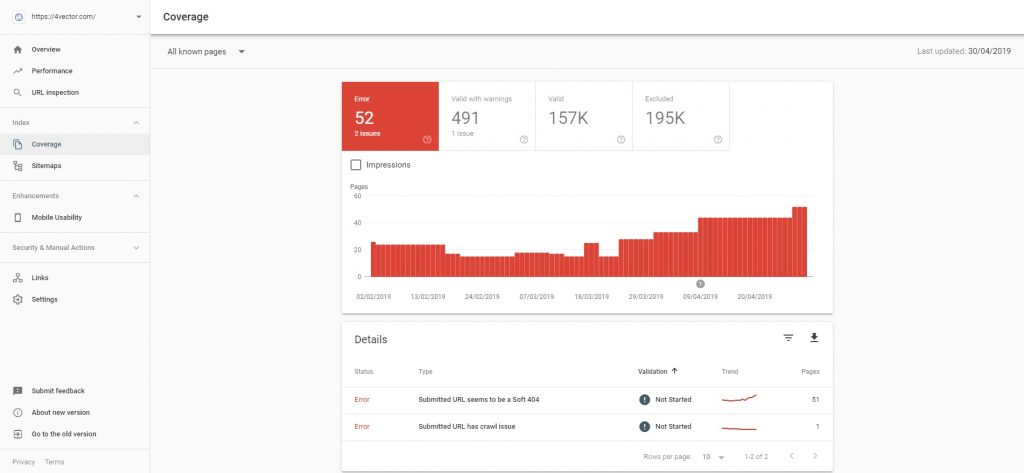

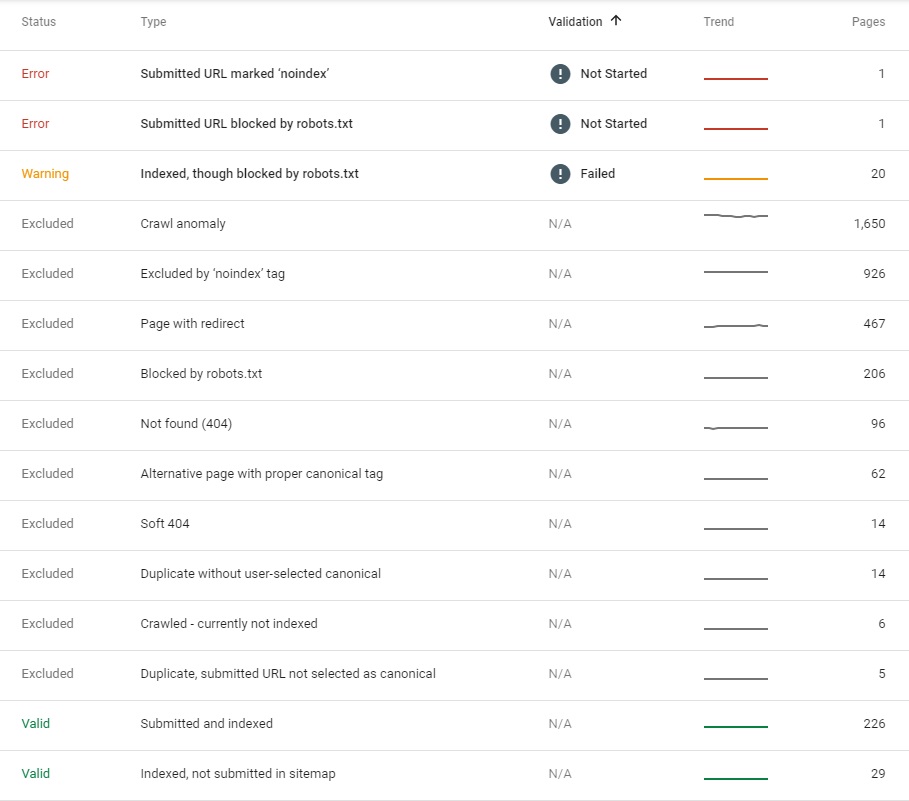

Покрытие индекса Google

Есть 2 подхода:

- Удаление нежелательных урлов из индекса.

- Просмотр всех ошибок, предупреждений и списков исключений в консоли.

У системы вообще есть достаточно приличное руководство по всем вопросам, которые показаны на скриншоте:

Вам нужно отработать все ошибки и предупреждения. Исправить их не так просто. Мы особое внимание уделили следующим:

- Автономность краулеров — URL не проиндексированы из-за кода ответа, который Google не ожидал. Он не понимает, откуда они взялись, значит, не разбирается в структуре сайта. А отсюда проблемы со сканированием и индексацией.

- “Мягкая 404” — обрабатываются также, как и обычные 404, но не возвращают соответствующего кода. Часто случается с коммерческими страницами. Если это произошло, обязательно выясните, в чем причина.

- Дубль без user-selected canonical — страницы, которые Google пометил как дубли. Вам нужно настроить каноническое перенаправление 301 или просто обновить контент.

- Crawled — currently not indexed — страницы, которые обошел робот, но которые пока не попали в индекс.

Есть много причин:

- На страницах нет внутренних ссылок.

- Система ставит индексацию в приоритет.

- На сайте много страниц, а в индексе нет места.

Для небольшого сайта (до 1 000 страниц) эта категория должна быть пустой.

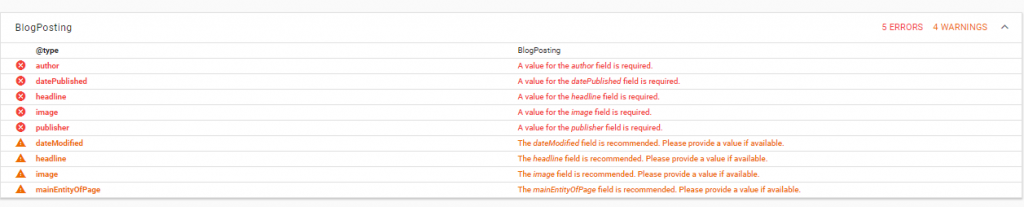

Структурирование данных

У нас были проблемы с существующими микроданными. Вы можете это понять в Structured Data Testing Tool:

Для исправления мы удалили некоторую разметку из header.php в WordPress. Также мы удалили разметку для комментариев — их все равно не было. Кроме этого, мы ввели специальную разметку JSON-LD для страниц с обзорами.

Юзабилити

Здесь речь про адаптивные элементы дизайна. Вы можете их устранить простым перемещением элементов или изменением их размера.

Возможность сканирования

Все страницы и разделы, которые сканировать не нужно, мы заблокировали.

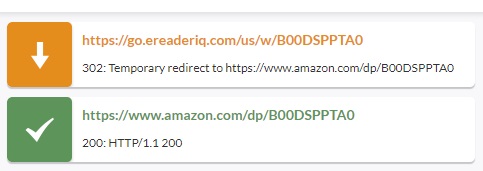

Столкнулись с проблемой: все партнерские ссылки использовали 302 редирект. Вот как это выглядит в Chrome с использованием расширения Redirect Path для случайного сайта:

Если вы занимаетесь разными партнерскими программами, то знаете, что сокращенные ссылки работают немного лучше, чем “уродливые”. Кроме того, такие сайты всегда используют своего рода редиректы, чтобы установить cookie для подтверждения, что человек пришел от вас.

Что хочу сказать: никогда не используйте 302 редиректы! Google приписывает контент, с которого вы устанавливаете редирект к той странице, на которую вы его устанавливаете. Получается, что контент вашего сайта считается дублем.

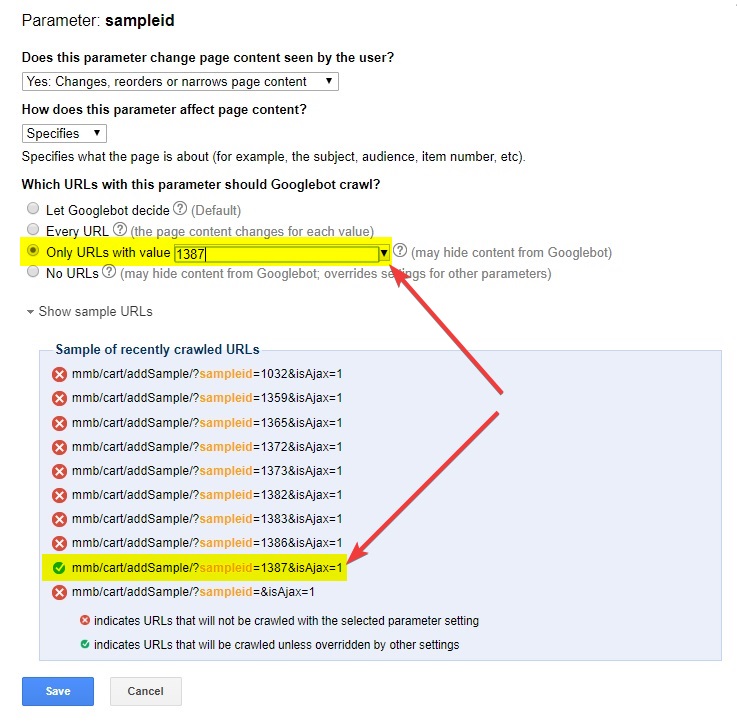

Переконфигурация URL в консоли

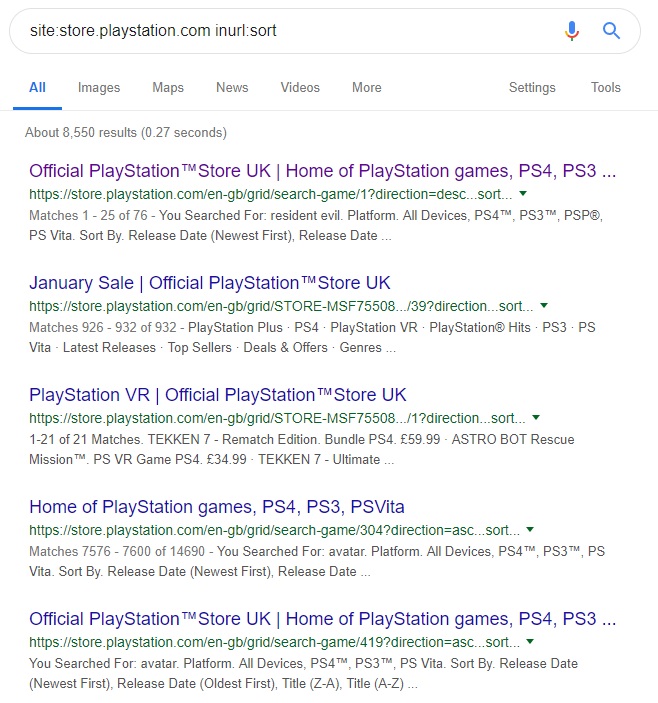

Настройте параметры URL-адреса, чтобы Google узнал, что происходит на вашем сайте.

Например, у вас интернет-магазин. Ваши категории используют параметр sort для определения фильтра — самые популярные товары, новые, в алфавитном порядке и т. д. Как здесь:

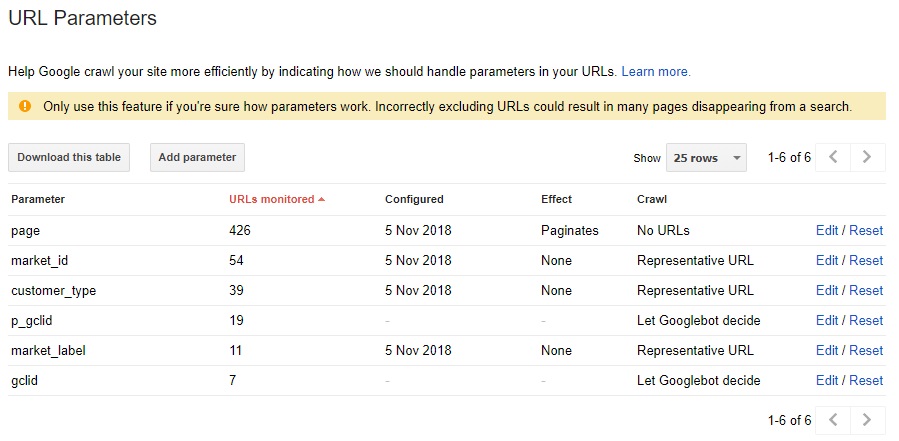

Вы можете запретить системе их индексировать. Для этого зайдите в GSC > Crawl > URL Parameter:

Нажмите на “Изменить”. Увидите окно:

Доступные параметры:

- Изменяет ли параметр контент страницы, который видит пользователь?

- Да: изменение порядка или сужение страницы.

- Нет: никак не влияет на содержимое страницы.

- Как влияет на контент страницы?

- Сортирует.

- Указывает.

- Определяет.

- Переводит.

- Разделяет.

- Другое.

- Какие адреса с этим параметром должен сканировать Google-бот?

- На усмотрение робота.

- Каждый URL.

- Только URL со значением.

- Никакой из URL.

Не забудьте посмотреть на примеры адресов, которые Google отслеживает по каждому параметру. Изменения, которые вы выберете, будут отражать, какие URL проиндексируются, а какие — нет.

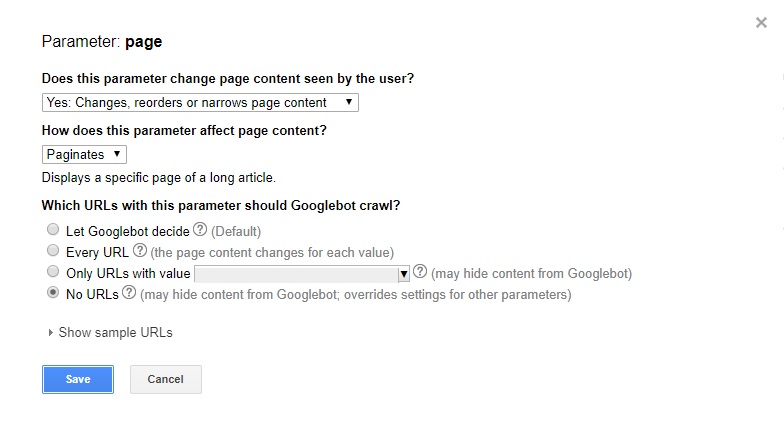

Вот пример, где нам нужно индексировать только одно конкретное значение параметры sapleid:

Ввод в действие

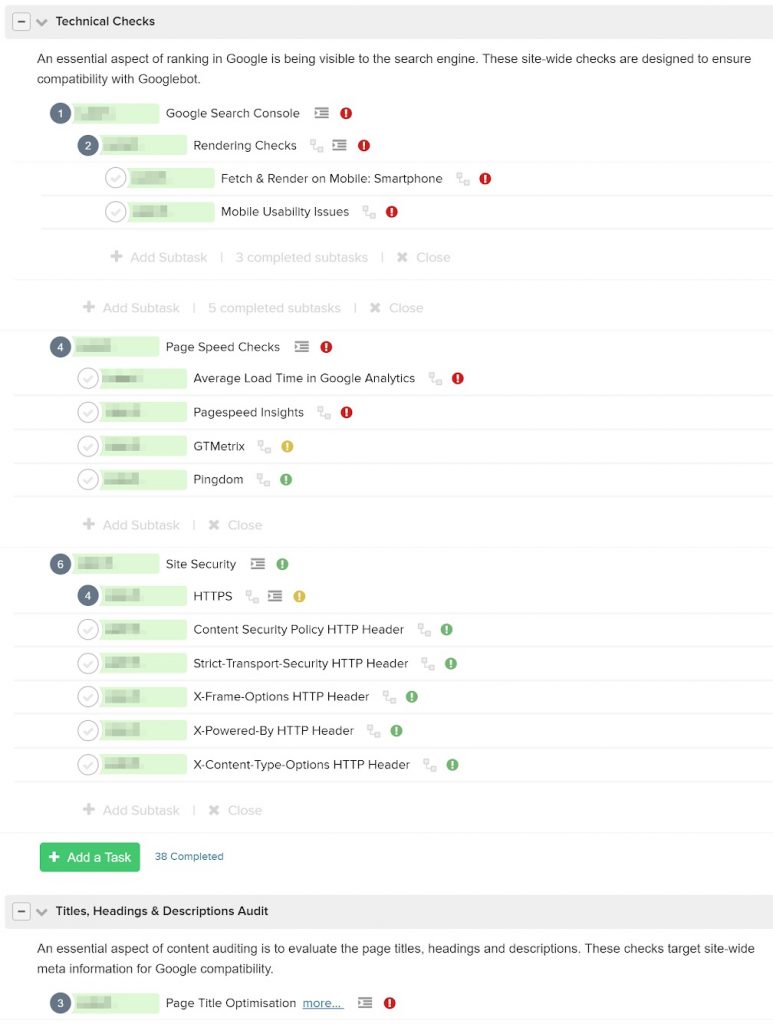

Список всех изменений — внушительный. Мы разбили план работ на несколько частей, организовали общий процесс для нескольких специалистов. Вот, например, как выглядит наш планировщик задач:

Когда речь об аудите и внедрении, ключ к успеху — наличие высоких стандартов. Решить проблему из-за неверно выполненных работ гораздо труднее, чем правильно решить менее важную проблему.

Результат: последствия апдейта ликвидированы

Как выглядит возвращение в выдачу?

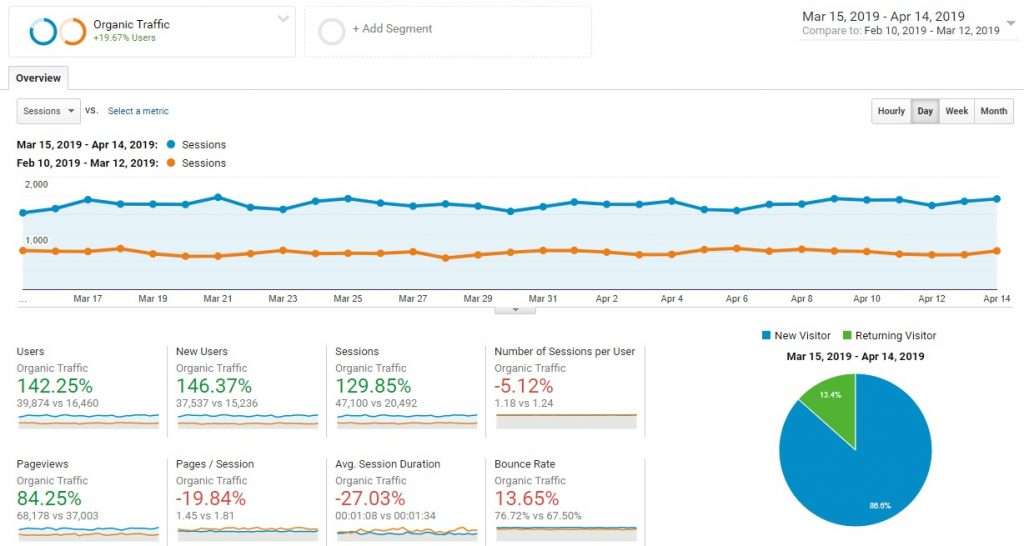

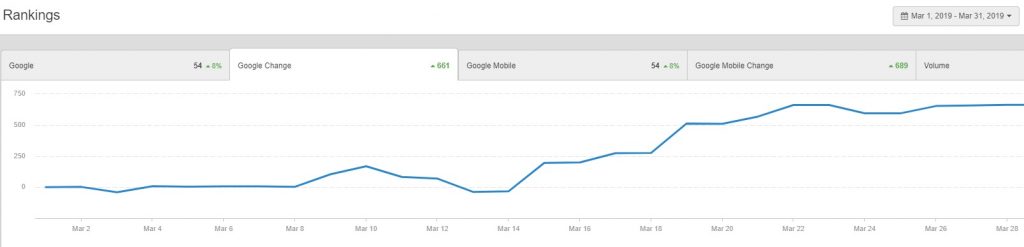

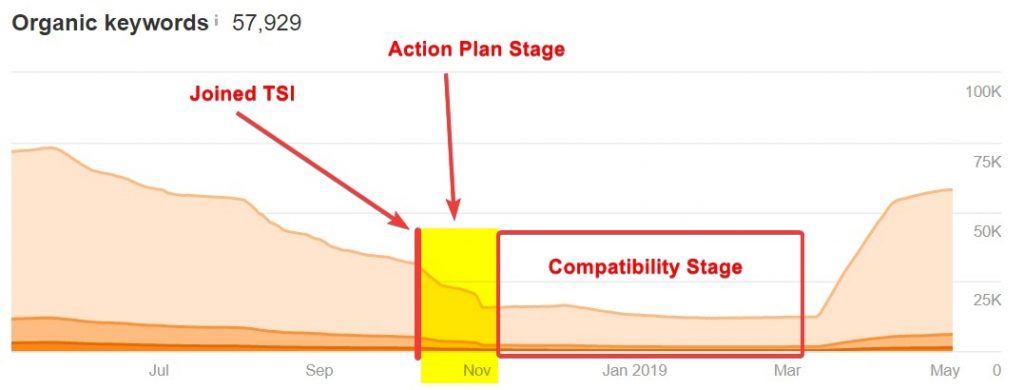

После серии итераций мы подготовили сайт к следующему апдейту:

Увеличение ключевых слов в течение недели:

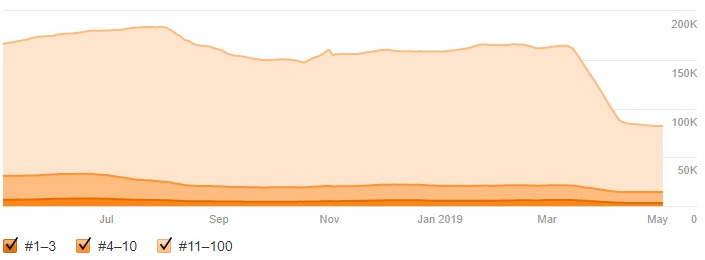

И мы увидели повышение рейтинга по всем направлениям — ключи вышли на первые позиции, новые начали ранжироваться гораздо лучше…

Вот сравнение трафика сразу после апдейта летом и в марте 2019:

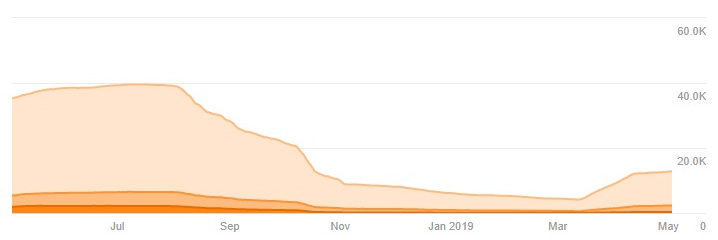

А вот, что произошло с конкурентами, которые не делали ничего:

По мере того, как Google развивается, такие апдейты будут неизбежны. Они будут регулярны. Здесь мы рассказали, как настроить свой сайт, чтобы получить выгоду от обновлений алгоритмов.

- Вы узнали, что Google постоянно что-то меняет, улучшает и обновляет.

- Также вы узнали о различных этапах процесса аудита и улучшения сайта.

- Увидели, что тяжелая работа, тщательный анализ и работа на перспективу всегда окупаются.