Иногда вы можете достигнуть цели не создавая новое, а убирая старое. Когда 10 лет назад я начал заниматься SEO, меня научил ментор: "Держи как можно больше страниц в индексе Google". Сейчас это не работает.

Алгоритмы Google, включая Панду, научили нас, что играть следует не на количество, а на качество. Лучший подход к поддержанию высокого качества — SEO-прунинг. Это удаление страниц с низкой производительностью чтобы повысить ранжирование всего сайта сразу.

Идея удаления страниц для лучшего SEO

Концепция такая же, как при выращивании деревьев бонсай. Они растут к вершине: внешние ветви увеличиваются пропорционально, а внутренние отмирают. Обрезка позволяет получить красивое дерево нужной формы. Она отвечает за равномерное распределение роста.

В SEO тот же принцип.

Большинство сайтов имеют лишь несколько страниц, которые получают большую часть трафика. Это неплохо, но результат не очень хороший: вы получаете много страниц, которые не получают достаточного количества посещений. Это — трухлявые ветви. Оптимизатор хочет наилучшего соотношения количества проиндексированных страниц с теми, которые находятся в ТОП-10. Чем меньше у сайта страниц, которые не получают много трафика, тем выше он поднимается в топ.

Мы не знаем точную формулу, как это вычисляется. Есть предположение, что эта механика учитывает оптимизация расходов на обход страницы роботом: оценку качества контента, учет пользовательского опыта. Первоначально идея оценки качества происходит из платного поиска, но она применима и к органике. Для контента Google измеряет качество всех страниц в своем индексе и начисляет его на "оценку качества домена".

Вопрос в том, как обрезать сайт и какие инструменты использовать?

SEO-прунинг с использованием SEMRush

Цель этого пошагового руководства — создать электронную таблицу, в которой вы сразу увидите те URL-адреса, которые не получают трафик, а значит, не нужны вашему сайту. Я покажу все на примере моего личного сайта в Германии.

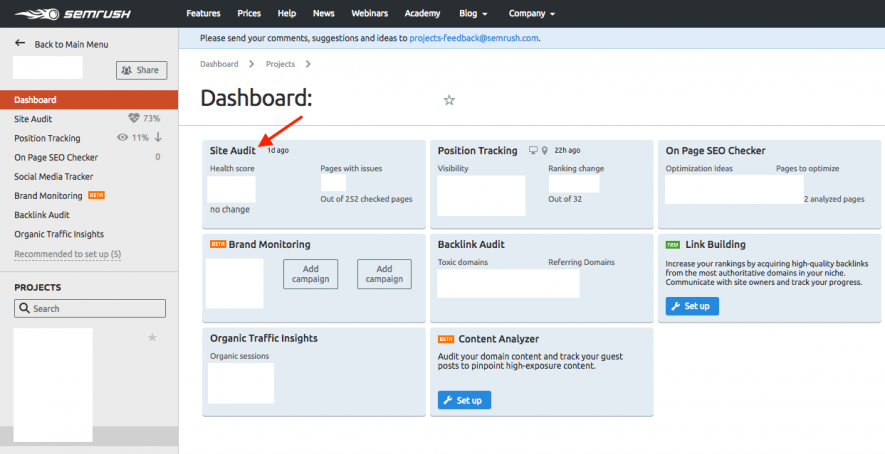

Прежде, чем начинать, проверьте, подключены ли Google Search Console и Analytics к SEMRush, есть ли отдельный проект для вашего сайта.

Шаг 1. Сканирование сайта

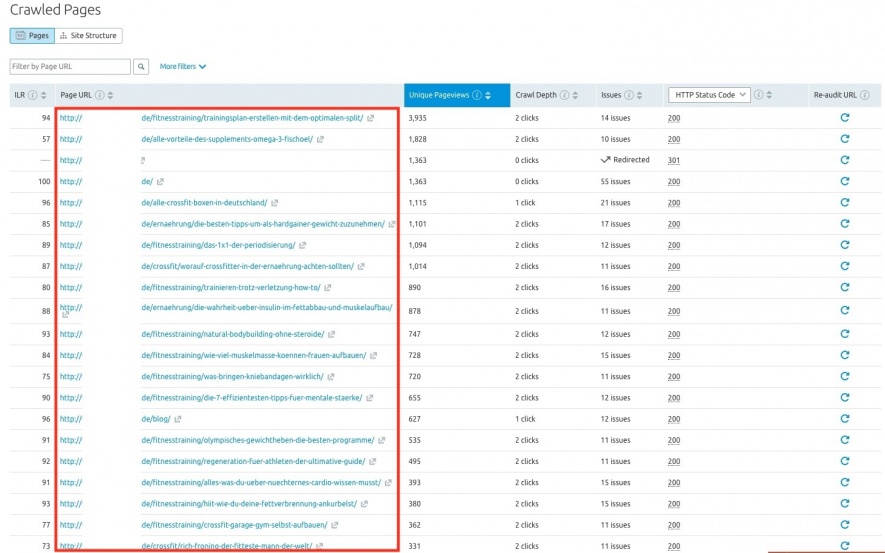

Заходим в раздел Site Audit, выбираем сайт в проектах и запускаем анализ сайта.

По завершении вы получите отчет, который позволит выгрузить обойденные страницы.

Сохраните данные.

Шаг 2. Извлечение данных о поведении пользователей и обратных ссылках

У нас есть основной набор страниц, но не хватает данных, чтобы понять, какие страницы нужно обрезать. Мы можем использовать следующие критерии:

- переходы из поиска;

- процент отказов;

- общее количество просмотров или сессий;

- количество и качество обратных ссылок;

- частота обхода роботом;

- количество ранжируемых ключей;

- CTR;

- обратные ссылки;

- расшаривания в социальных сетях.

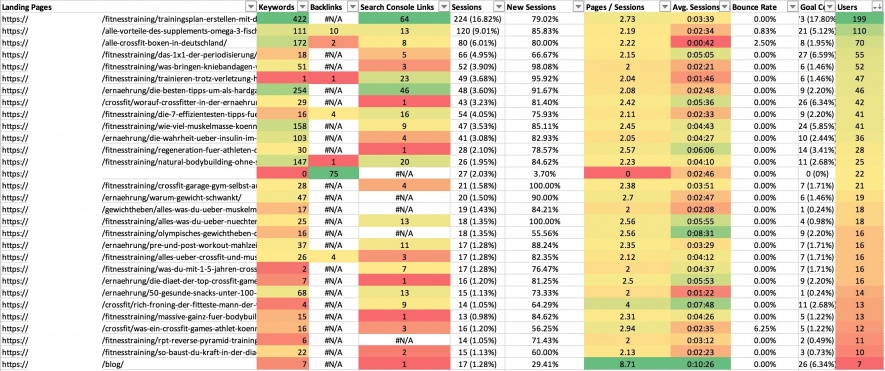

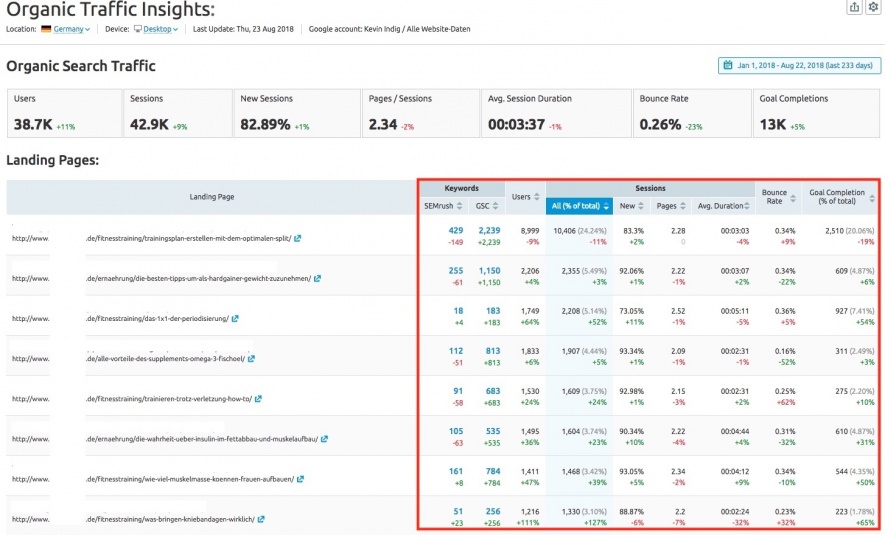

В своем примере я буду использовать ранжируемые ключи и данные об обратных ссылках (из SEMRush и Search Console), поисковый трафик и данные пользовательского опыта. Все эти данные также есть в Organic Traffic Insights.

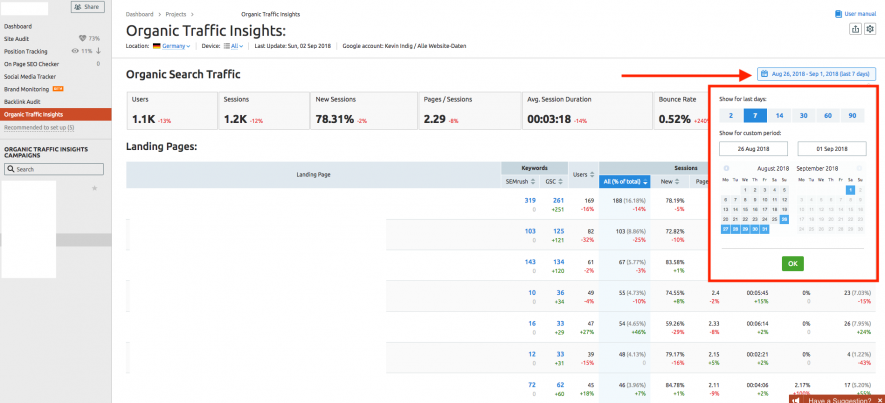

Не забудьте указать временной диапазон. По умолчанию он составляет 7 дней. Для некоторых сайтов нужно брать больший период — 3-6 месяцев.

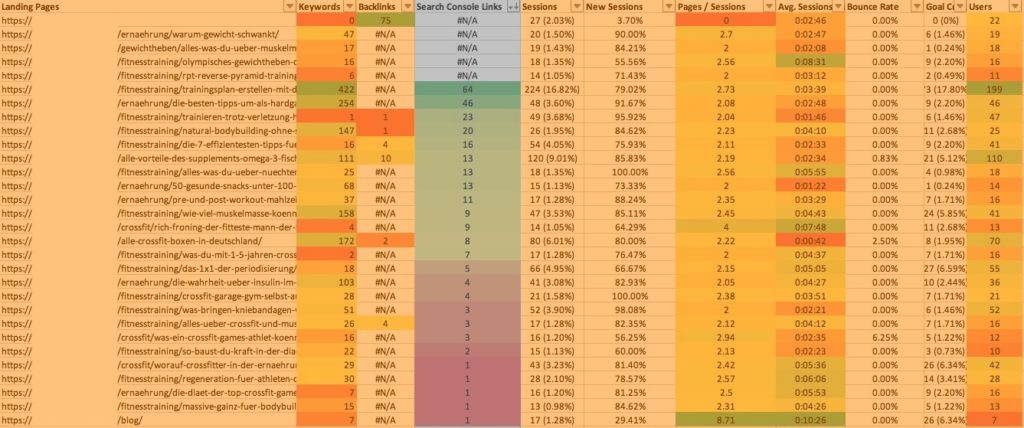

Вот, что вы получите:

Это усредненные показатели поведения пользователей на вашем сайте, которые удобно сравнивать. Также для каждого URL увидите все ключевые слова, по которым ранжируется страница. Вы можете создать сводную таблицу и проверить, ранжируются ли несколько страниц по схожим ключам — заодно предотвратите каннибализацию.

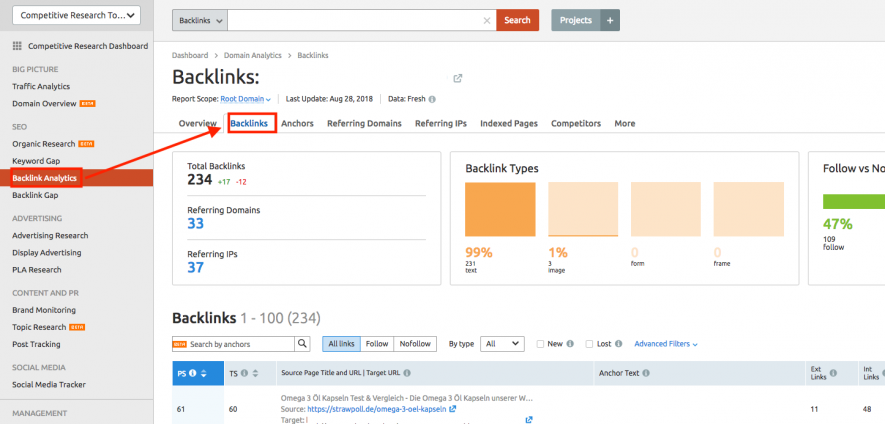

Также нам потребуется выгрузить обратные ссылки. Заходим: Backlinks Analytics > Backlinks и экспортируем данные. Посмотрите, не попали ли в выборку битые и потерянные ссылки.

Вы также можете добавить данные из любого сервиса, которым пользуетесь. Например, из Search Console. Наша задача на этом этапе — для каждого URL-адреса получить список обратных ссылок и показатель качества каждой.

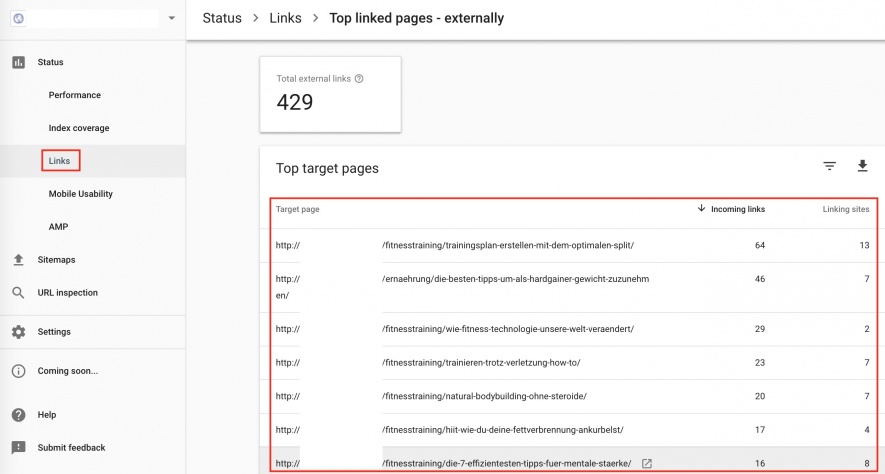

В Search Console: Links > Top Linked pages — externally и выгружаем список.

После того, как вы выгрузили все данные, вставьте их в таблицу, созданную на первом шаге. Дальше используем функцию VLOOKUP (или ВПР в русском варианте), чтобы сгруппировать данные для каждого URL. Создайте сводную таблицу для данных по обратным линкам, в которой будет вычисляться ценность ссылок для URL.

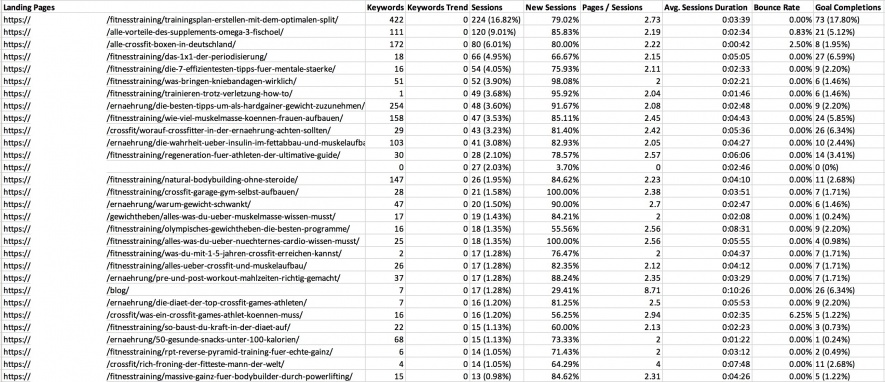

Теперь у вас должен быть список URL-адресов с информацией об эффективности их ранжирования, трафике и поведенческом факторе. На скриншоте я указал, какие данные брать из SEMRush оранжевым цветом, а из Search Console — серым.

Шаг 3. Находим неподходящие страницы

Дальше начинается магия Excel.

К каждому столбцу применим условное форматирование, отсортируем по полю с трафиком и узнаем, почему некоторые URL не работают. Иногда у страницы может быть высокий показатель отказов, в другом случае — мало ссылок, в третьем — отсутствует оптимизация под ключевой запрос.

Разделим теперь весь наш список на 3 группы.

- Производительные (с ними ничего не делаем). Такие страницы хорошо ранжируются по запросам, приносят трафик, нравятся пользователям. Соответственно, их оставляем. Также в этой группе те страницы, которые мы просто не можем удалить — домашняя, информация о компании, контакты и т. д.

- Страницы средней производительности (редактируем). Они приносят какой-никакой трафик, но ни одной из них нет в топ-10. Попасть на первую страницу выдачи они могут при некоторой оптимизации. Также они могли бы разово принести много трафика, но с момента создания этого не произошло.

- Страницы низкой производительности (соединяем или переадресовываем). Эта группа со страницами, которые никогда не получали никакого трафика и обратных ссылок. Они иногда дублируют друг друга, пересекаются содержимым, оптимизированы под схожие ключи. Также сюда попадают страницы, например, с информацией об авторе, концентраторы страниц. Их мы никак не сможем оптимизировать:

- страницы с авторами, тегами, архивными данными;

- статьи блога;

- концентраторы контента;

- недоступные товары.

На такие страницы лучше перенаправлять пользователей из других источников — которые находятся выше в иерархии. Также можно на одной странице объединять те материалы, которые похожи между собой.

Шаг 4. Что делать со страницами низкой производительности

Обрезать — не значит удалить URL. Есть несколько вариантов, что делать со второй и третьей группами:

- Объединить контент, доступный по разным URL, на одной странице. Не забудьте про 301 редирект для перенаправления людей со старых адресов на новый.

- Переадресовать на лучшую страницу, или которая стоит выше в иерархии.

- Отредактировать, переработать, переписать, обновить контент.

Начнем с установки для всех URL адресов в третьей группе meta=noindex. Возможно, вам не придется разбираться со всеми страницами. Но можно, например, запретить индексацию страницы с информацией об авторе.

А дальше — методично смотрим на каждую страницу и решаем, что с ней делать. Когда обработаем все адреса из третьей группы, можем приступать ко второй. Возможно, там даже не потребуется вносить серьезных изменений.

Шаг 5. Выкатываем изменения

Я рекомендую разделить процесс на несколько этапов. Начните с самых плохих страниц, а потом подождите несколько недель. Посмотрите, как изменения отразятся на работе вашего сайта.

Какие результаты даст SEO-прунинг

Один сайт, для которого я провел такую процедуру, вырос в топ-20, через месяц трафик увеличился на 25%.

Как часто делать SEO-pruning

Я рекомендую проводить обрезку сайта 1-2 раза в год. Иначе вы рискуете "перепрунить". Но вообще все зависит от размера сайта. Чем больше на нем страниц, тем быстрее вы увидите результат.

Кому это нужно

SEO-прунинг нужен абсолютно всем сайтам. Исключение — небольшой ресурс. Если у вас портал на 100 страниц, вероятно, в прунинге просто нет смысла. А когда у вас будет 1000 страниц — уже можно начинать.

Учтите, я даю произвольные размеры, чтобы показать, что значит "маленький" и "большой" сайт. Чтобы обрезать страницы, вам нужен контент. Нет материалов — и обрезать нечего.

Что еще можно сокращать

Ссылки. Принцип тот же самый — отказываемся от тех, которые являются спамными и подозрительными. Также можно поступить и с товарами в интернет-магазине, которые никто не покупает.

Так вы улучшите общее качество портала.