До сих пор есть люди, которые используют файл robots.txt, чтобы закрыть сайт от индексации в поисковых системах и убрать его из результатов поиска. Объясним, почему файла robots.txt для этих целей недостаточно и что нужно сделать, чтобы страница или домен не появлялись в выдаче.

Самый очевидный способ скрыть нежелательные страницы из поисковой выдачи – закрыть их от индексации с помощью файла robots.txt. Но результат отличается от того, который ждешь: сайты все равно отображаются в поиске. В этой статье Йост де Валк из Yoast объясняет, почему так происходит, и рассказывает, что нужно сделать, чтобы страница или сайт исчезли из выдачи.

Разница между индексированием и показом в результатах поиска Google

Прежде чем объяснить, почему запрет на индексирование сайта не мешает поисковику выводить его в выдаче, вспомним несколько терминов:

- Индексирование – процесс скачивания сайта или страницы контента на сервер поисковой системы, вследствие которого сайт или страница добавляется в индекс.

- Ранжирование/ отображение в поиске – отображение сайта среди результатов поиска.

Наиболее распространенное представление о попадании сайта/страницы в результаты поиска выглядит как двухэтапный процесс: индексирование => ранжирование. Но чтобы отображаться в поиске, сайт не обязательно должен индексироваться. Если есть внешняя ссылка на страницу или домен (линк с другого сайта или с индексируемых внутренних страниц), Google перейдет по этой ссылке. Если robots.txt на этом домене препятствует индексированию страницы поисковой системой, Гугл все равно будет выводить URL в выдаче. Он ориентируется на внешние источники, которые содержат ссылку и ее описание. Раньше источником мог быть DMOZ или директория Yahoo. Сегодня я вполне могу представить, что Google использует, например, ваш профиль в My Business или данные из других сайтов.

Наиболее распространенное представление о попадании сайта/страницы в результаты поиска выглядит как двухэтапный процесс: индексирование => ранжирование. Но чтобы отображаться в поиске, сайт не обязательно должен индексироваться. Если есть внешняя ссылка на страницу или домен (линк с другого сайта или с индексируемых внутренних страниц), Google перейдет по этой ссылке. Если robots.txt на этом домене препятствует индексированию страницы поисковой системой, Гугл все равно будет выводить URL в выдаче. Он ориентируется на внешние источники, которые содержат ссылку и ее описание. Раньше источником мог быть DMOZ или директория Yahoo. Сегодня я вполне могу представить, что Google использует, например, ваш профиль в My Business или данные из других сайтов.

Если написанное выше кажется вам бессмысленным, посмотрите видео с объяснением Мэтта Каттса.

Адаптация видео:

Пользователи часто жалуются на то, что Google игнорирует запрет на индексирование страницы в robots.txt и все равно показывает ее в результатах выдачи. Чаще всего происходит следующее: когда некто отправляет роботу сигнал на запрет индексирования страницы, она появляется в поиске с необычным сниппетом – без текстового описания. Причина: краулеры не сканировали страницу. Они видели только упоминание URL. Именно потому что роботы видели ссылку, а не саму страницу, в выдаче пользователям предлагается сниппет без дескрипшна. Обратимся к примеру.

В какой-то момент California Department of Motor Vehicles, домен www.dmv.ca.gov, заблокировала все поисковые системы с помощью robots.txt. Но если пользователь ищет информацию по запросу California DMV, есть только один релевантный ответ, который поисковик должен предложить пользователю. Несмотря на robots.txt, который говорит роботу, что он не должен сканировать страницу, краулер видит, что многие сайты ссылаются на определенную страницу, используя анкоры с текстом California DMV. Роботы понимают, что эта страница – результат, наиболее релевантный запросу пользователя. Поэтому они показывают результат в выдаче даже без сканирования страницы. Желание предоставить пользователю результат, наиболее релевантный запросу, может быть единственной причиной, по который Google выводит в результатах поиска страницы, не сканированные краулерами.

Еще один пример – сайт Nissan. Долгое время Nissan использовал robots.txt для запрета индексирования всех страниц. Но мы обнаружили сайт и его описание в открытом каталоге DMOZ. Поэтому когда пользователи получали ссылку на сайт среди результатов, они видели такой же сниппет, как и у обычных страниц, которые были просканированы краулерами. Но этот сниппет был составлен не на основе результатов сканирования. Он был создан из информации DMOZ.

В итоге: Google может показать что-то, что считает полезным пользователю, без нарушения запрета на сканирование в robots.txt.

Если вы не хотите, чтобы страница отображалась в поиске, позвольте роботам просканировать страницу, а затем используйте атрибут noindex. Когда робот видит тег «noindex», он выбрасывает страницу изо всех поисковых результатов. Страница не появляется в поиске, даже если на нее ссылаются другие сайты.

Другой вариант – использовать инструмент удаления URL. Блокируйте сайт полностью в robots.txt, а после используйте инструмент удаления URL.

Что получается: закрывая сайт от сканирования, вы лишаете краулеров возможности узнать, что запретили отображение сайта в поисковой системе.

Поэтому:

Чтобы запретить появление сайта в результатах поиска, вам нужно позволить краулерам Google просканировать страницу.

Это может выглядеть противоречиво. Но только так вы сможете скрыть сайт в результатах поиска.

Как запретить отображение страницы в результатах поиска

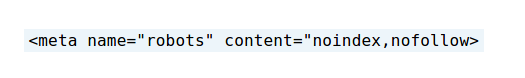

С помощью добавления метатега robots

Первый вариант запрета показа страницы в Google – использование метатега robots. Вам нужно добавить этот тэг на свою страницу:

Проблема с тэгом в том, что его нужно будет добавить на каждую страницу.

Есть еще одна проблема – с помощью метатега robots можно скрывать только html-документы. Это значит, что метатег нельзя применить для документов в формате pdf, doc, xml, а также для аудио и видео контента. Чтобы скрыть документы не в html, нужно использовать файл robots.txt. Что замыкает круг. Потому что эти документы могут появиться в выдаче.

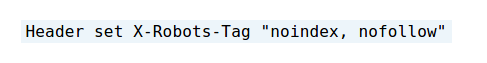

Использовать X-Robots-Tag HTTP header

Добавлять метатег robots к каждой странице сайта сложно. Упрощает задачу X-Robots-Tag HTTP header. С его помощью можно управлять индексированием сайта и его показом в результатах поиска. Так, вы можете установить директиву noindex и nofollow. Noindex – запрет на отображение страницы и сохраненной копии в результатах поиска, nofollow – запрет на переход по ссылкам на этой странице.

Почему X-Robots-Tag HTTP header крут:

- Закрывает от попадания в поиск все файлы – как html, так и pdf, doc, xml.

- Не нужно обрабатывать каждую страницу, можно сразу скрыть из результатов поиска весь сайт.

Если ваш сайт на базе Apache, и mod_headers недоступны, в корневой файл .htaccess добавьте фрагмент кода:

Таким образом ваш сайт будет индексироваться. Но не появятся в результатах поиска.

Чтобы убрать сайт из поиска, не используйте robots.txt. Вместо этого используйте X-Robots-Tag или метатег robots.

Выжимка

- robots.txt закрывает сайт от индексирования, но сайт все равно может появиться в результатах поиска.

- Чтобы скрыть страницы или сайт из поиска, используйте метатег robots или X-Robots-Tag HTTP header.

- Метатег robots нужно добавлять на каждую страницу, которую хотите скрыть, по отдельности. Его можно использовать только для html-документов.

- X-Robots-Tag HTTP header позволяет скрыть из результатов поиска сразу весь сайт. Его можно использовать как для скрытия html-документов, так и файлов других форматов – pdf, doc, xml.

- Не нужно запрещать сканирование страницы файлом robots.txt. Если сканирование будет запрещено, краулеры не увидят директивы относительно индексирования и отображения в поиске. Значит, они не выполнят директивы, и сайт появится в выдаче.

Что еще почитать:

Статью Семантики о закрытии сайта или его части от индексации.